csv 最大数据

- 行业动态

- 2025-01-31

- 3

read_csv函数中的 chunksize参数),可以处理更大规模的数据。2. **数据量级**:CSV文件本身可以容纳任意数量的数据行和列,理论上没有严格的上限。实际应用中会受到硬件资源(如内存、硬盘空间)、软件性能以及数据处理需求(如数据分析、可视化等)的限制。对于超大规模数据集,可能需要采用分布式计算框架(如Hadoop、Spark等)或者数据库管理系统来进行处理。3. **数据类型与精度**:CSV文件中的数据类型通常由用户自行定义,可以是文本、数值、日期等。对于数值型数据,其精度受限于所使用的数据类型(如整型、浮点型)以及编程语言或软件对数值运算的支持。Python中的浮点数默认遵循IEEE 754双精度标准,提供约15-17位有效数字的精度。4. **编码与字符集**:CSV文件支持多种字符编码,如UTF-8、ASCII等。选择适当的编码方式可以确保数据在不同平台间的正确读取与显示。对于包含非ASCII字符(如中文、特殊符号等)的数据,应确保使用支持这些字符的编码格式。“csv 最大数据”这一表述可能涵盖文件大小、数据量级、数据类型与精度、编码与字符集等多个方面。具体取决于您所关注的问题或应用场景,可能需要针对上述某个或多个方面进行深入探讨。如果您能提供更详细的信息或问题背景,我将很乐意为您提供更精确的答案。

CSV(Comma-Separated Values,逗号分隔值)是一种简单的文件格式,常用于存储表格数据,如电子表格或数据库中的数据,它以纯文本形式存在,易于阅读和编写,被广泛应用于数据交换和数据存储场景。

CSV 文件结构

一个典型的 CSV 文件由多行组成,每行代表一条记录,字段之间用逗号隔开。

姓名,年龄,性别 张三,28,男 李四,32,女 王五,24,男

在这个例子中,第一行是表头,定义了每列的含义,后续每一行是一个数据记录。

最大数据限制

虽然 CSV 文件本身没有严格的大小限制,但实际应用中会受到多种因素的影响:

1、文本编辑器限制:大多数文本编辑器在打开非常大的文件时可能会遇到性能问题或无法加载。

2、内存限制:如果将 CSV 文件读入内存进行处理,文件太大可能导致内存不足。

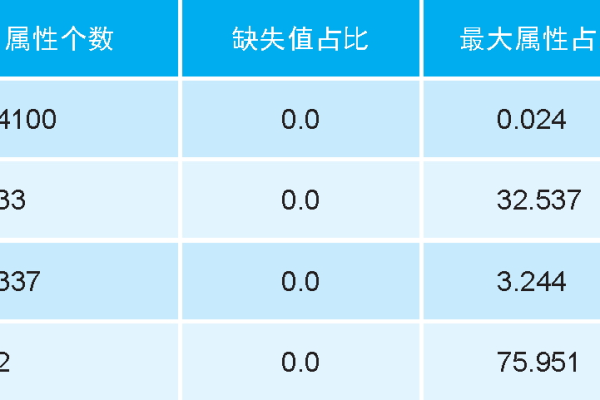

3、软件/库限制:不同的编程语言和库对 CSV 文件的处理能力不同,有些可能无法处理过大的文件。

4、操作系统限制:单个文件的大小还受到操作系统的限制,例如在 FAT32 文件系统中,单个文件的最大大小为 4GB。

处理大 CSV 文件的方法

对于大型 CSV 文件,可以采用以下几种方法来处理:

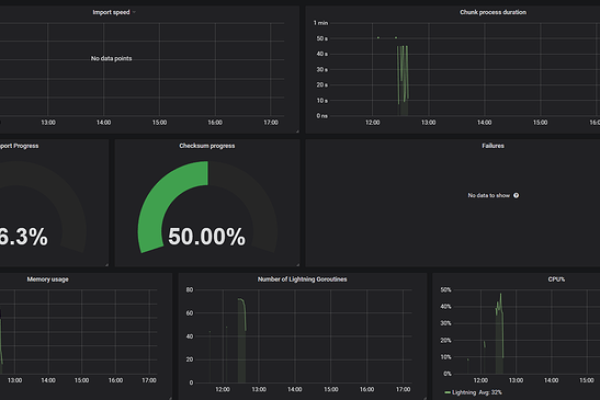

分批处理:将大文件分割成多个小文件,分别处理后再合并结果。

流式处理:使用支持流式读取的库,逐行读取和处理数据,避免一次性加载整个文件到内存中。

数据库导入:将 CSV 数据导入到数据库中,利用 SQL 进行高效的查询和分析。

分布式计算框架:对于极其庞大的数据集,可以使用 Hadoop、Spark 等分布式计算框架来处理。

FAQs

Q1: 如何判断一个 CSV 文件是否过大?

A1: 如果在使用常规工具(如 Excel、记事本)打开 CSV 文件时出现卡顿或无法加载的情况,或者在进行数据处理时遇到内存不足的错误,那么该文件可能被视为“过大”,具体多大算“过大”取决于你的系统配置和所使用的工具/库的能力。

Q2: 有哪些工具可以帮助我更好地管理和分析大型 CSV 文件?

A2: 除了上述提到的数据库管理系统外,还有一些专门的大数据处理工具和编程语言库可以帮助你,Python 中的 Pandas 库(配合适当的设置可以高效地处理大文件)、R 语言、Apache Spark(特别适合于大规模数据集的并行处理)等,一些商业智能软件也提供了强大的数据导入和分析功能。

小编有话说

面对大型 CSV 文件时,不必过于担心其“庞大”的体积,通过合理选择工具和方法,即使是数 GB 甚至更大的数据集也能得到有效的处理,技术总是在进步的,总有更适合的解决方案等待着我们去发现和应用,希望这篇文章能帮助你在处理大型 CSV 文件的道路上更加顺畅!