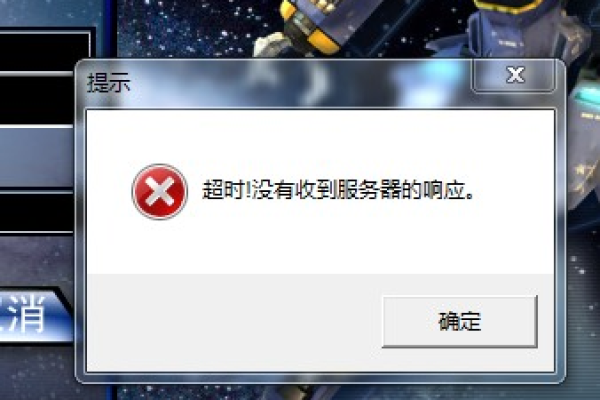

为什么服务器在没有报错的情况下进程会突然终止?

- 行业动态

- 2024-11-14

- 10

服务器进程异常终止可能是由多种因素引起的,包括硬件故障、软件错误、资源耗尽、安全攻击等,为了深入理解这一现象,我们可以从几个关键方面进行分析和探讨。

一、常见原因分析

1. 硬件故障

内存错误:当服务器内存出现物理损坏或配置错误时,可能会导致进程突然崩溃。

硬盘故障:硬盘读写错误或磁盘空间不足也可能导致服务中断。

电源问题:不稳定的电源供应可能引起意外重启或关机。

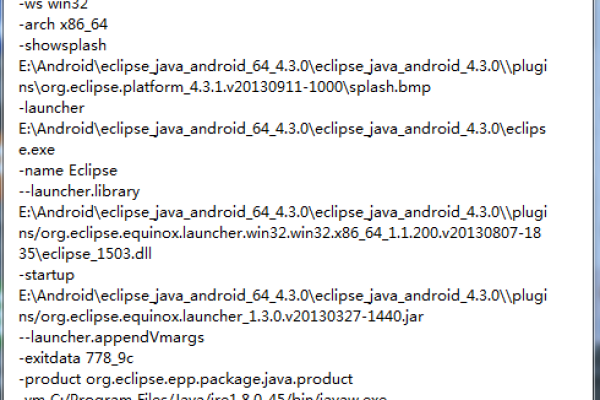

2. 软件缺陷

编程错误:代码中的bug可能导致程序在特定条件下异常退出。

第三方库问题:依赖的外部库或框架存在破绽也可能影响稳定性。

系统更新不兼容:操作系统或应用程序的新版本与现有环境不匹配。

3. 资源限制

CPU过载:长时间高负载运行可能导致处理器过热而自动保护性关闭。

内存泄漏:应用程序未能正确释放不再使用的内存资源,最终耗尽可用内存。

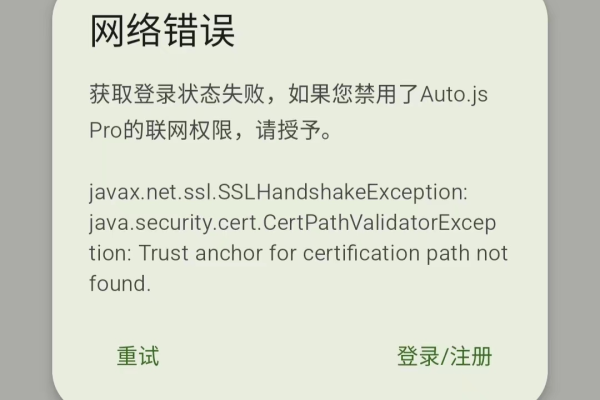

网络带宽饱和:大量并发请求超出网络处理能力,造成连接断开。

4. 安全威胁

反面软件感染:干扰、载入等反面程序可能会破坏系统文件或者消耗过多资源。

DDoS攻击:分布式拒绝服务攻击通过大量无效请求占用服务器资源,使其无法正常提供服务。

权限滥用:未经授权的用户执行了危险操作(如删除关键数据)。

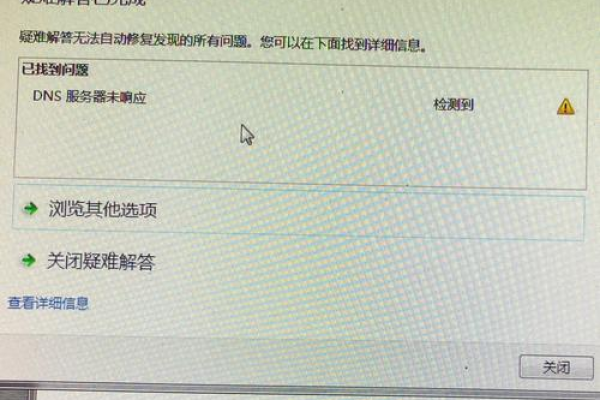

二、诊断方法

针对上述情况,可以采取以下几种方式来进行排查:

| 方法 | 描述 |

| 日志检查 | 查看系统和应用日志以获取错误信息及发生时间点。 |

| 资源监控 | 利用工具实时监测CPU使用率、内存占用等情况。 |

| 性能测试 | 模拟高并发场景下的表现,寻找潜在的瓶颈所在。 |

| 安全扫描 | 定期对整个环境进行全面的安全评估。 |

三、预防措施

为了避免类似问题再次发生,建议实施以下策略:

定期备份:确保重要数据的安全性,并能够快速恢复至最近一次保存的状态。

更新维护:及时安装官方发布的补丁和版本升级,修复已知破绽。

访问控制:设置合理的用户权限管理体系,防止非授权人员随意更改设置。

冗余设计:采用集群架构提高系统的可用性和容错能力。

四、案例研究

为了更好地理解这些概念,我们可以通过一个具体的实例来说明如何应对突发状况,假设某电商平台在促销活动期间遭遇了严重的性能下降甚至完全瘫痪的情况,经过初步调查发现是由于数据库服务器上的一块硬盘出现了物理损坏所致,该事件不仅影响了用户体验,还给企业造成了经济损失,事后分析表明,如果事先做好了充分的准备,比如采用RAID技术提高数据冗余度,则完全可以避免此类灾难的发生。

五、相关问答FAQs

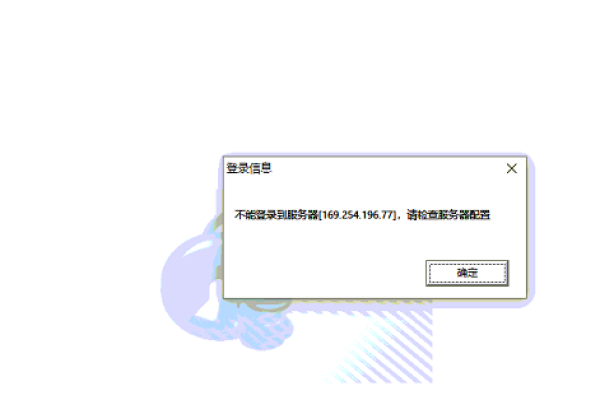

Q1: 如果遇到服务器频繁无故重启应该怎么办?

A1: 首先应该检查是否有任何硬件故障报警信息;其次查看操作系统日志中是否有异常记录;最后考虑是否为软件层面的问题,比如驱动兼容性不佳或是某些服务设置不当造成的循环重启现象。

Q2: 如何有效抵御DDoS攻击?

A2: 除了加强网络边界防护外,还可以引入专业的抗DDoS解决方案,如云服务提供商提供的清洗中心服务;另外也需要优化自身架构设计,比如分散部署前端接入点以减轻单点压力。

以上内容就是解答有关“服务器没报错进程直接死掉了”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。