如何在Android设备上充分利用CSS3的强大功能?

- 行业动态

- 2025-01-23

- 6

CSS3 是层叠样式表(Cascading Style Sheets)的升级版本,于1999年开始制订,2001年5月23日W3C完成了其工作草案,它是CSS技术的后继者,旨在扩展CSS2.1的功能,并引入了许多新的模块和特性,如圆角、阴影、渐变、过渡、动画以及多列布局等。

Android是一个开源的、基于Linux的移动设备操作系统,由Google及其他公司带领的开放手机联盟开发,主要用于智能手机和平板电脑等移动设备。

CSS3与Android的关系

在Android应用开发中,CSS3技术常用于前端页面的样式设计,特别是在使用WebView加载网页或显示HTML内容时,通过CSS3,开发者可以为Android应用中的网页元素添加丰富的视觉效果和交互效果,提升用户体验,利用CSS3的动画和过渡效果,可以创建流畅的页面切换和元素动态变化;使用圆角、阴影和渐变等样式,可以使页面更加美观和专业。

常见问题解答

问:如何在Android中使用CSS3实现动画效果?

答:在Android中,可以通过WebView加载包含CSS3动画的HTML页面来实现动画效果,确保在HTML文件中正确编写CSS3动画代码,并使用适当的前缀(如-webkit-)来兼容不同的浏览器,将HTML文件加载到WebView中,即可看到动画效果,如果需要在不同版本的Android浏览器上测试动画效果,可以使用Chrome DevTools的移动设备模拟器或直接在Android手机上打开网页进行查看。

问:如何判断当前设备是否为Android设备并应用特定的CSS样式?

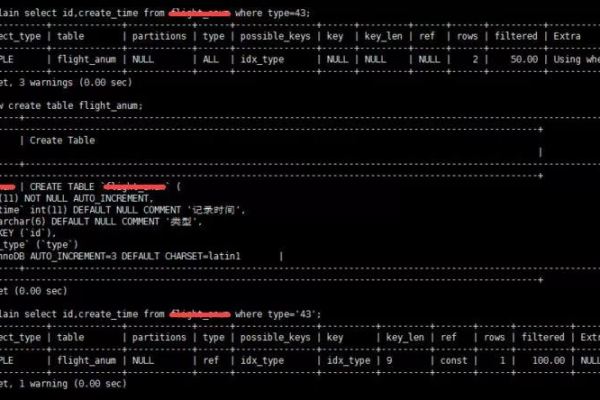

答:可以通过CSS3的媒体查询和某些特定的CSS特性来判断当前设备是否为Android设备,可以使用以下媒体查询代码来检测Android设备:

@media only screen and (max-width: 600px) and (-webkit-min-device-pixel-ratio: 2) {

body {

background-color: lightgreen; /* 如果是Android设备,背景色设为浅绿色 */

}

} 这段代码通过检测设备的屏幕宽度和像素比来判断是否为Android设备,并为符合条件的设备应用特定的样式。

小编有话说

CSS3作为现代网页设计的重要技术之一,为Android应用开发提供了强大的样式设计支持,通过合理运用CSS3的特性和技巧,开发者可以轻松地为Android应用打造出美观、动感且具有良好用户体验的界面,随着移动设备的不断发展和更新换代,CSS3在Android开发中的应用前景将更加广阔。