c# 网站页面抓取

- 行业动态

- 2025-01-29

- 2

### C#实现网站页面抓取:该技术利用C#语言编写程序,模拟浏览器行为访问目标网站,获取并解析HTML内容,支持多种网页元素提取及数据处理,可应用于数据采集、信息监控等领域。

在当今数字化时代,网络数据成为了重要的信息资源,对于C#开发者而言,掌握网站页面抓取技术能够更好地获取和处理网络上的数据,以下将详细介绍使用C#进行网站页面抓取的相关内容:

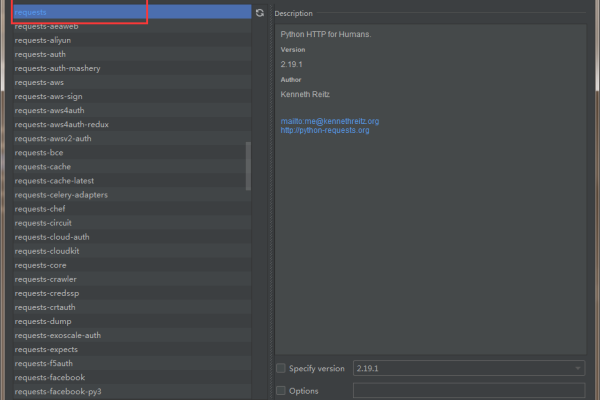

1、使用HttpClient类:HttpClient是.NET Framework中用于发送HTTP请求和接收HTTP响应的类,通过创建HttpClient对象,可以方便地发送GET、POST等请求来获取网页内容。

|代码示例|功能描述|

|—-|—-|

|“csharp|using System;<br>using System.Net.Http;<br>namespace HttpClientExample<br>{<br> class Program<br> {<br> static void Main(string[] args)<br> {<br> using (HttpClient client = new HttpClient())<br> {<br> client.BaseAddress = new Uri("http://example.com/");<br> var response = client.GetAsync("api/values").Result;<br> response.EnsureSuccessStatusCode();<br> string responseBody = response.Content.ReadAsStringAsync().Result;<br> Console.WriteLine(responseBody);<br> }<br> }<br> }<br>}<br>`|创建一个HttpClient`对象,设置基础地址为"http://example.com/",然后发送GET请求到"api/values"接口,获取响应内容并输出。|

2、解析HTML内容:获取到网页内容后,需要对其进行解析,常用的HTML解析库有HtmlAgilityPack等,它提供了便捷的方法来遍历和操作HTML文档。

|代码示例|功能描述|

|—-|—-|

|“csharp|using HtmlAgilityPack;<br>using System;<br>namespace HtmlParserExample<br>{<br> class Program<br> {<br> static void Main(string[] args)<br> {<br> string html = "<html><body><h1>Hello, World!</h1></body></html>";<br> HtmlDocument doc = new HtmlDocument();<br> doc.LoadHtml(html);<br> var root = doc.DocumentNode;<br> var titleNode = root.SelectSingleNode("//title");<br> if (titleNode != null)<br> {<br> Console.WriteLine(titleNode.InnerText);<br> }<br> }<br> }<br>}<br>`|加载HTML字符串,然后使用XPath选择器查找<title>`节点,并输出其文本内容。|

3、处理JavaScript渲染的页面:有些网页内容是通过JavaScript动态生成的,此时可以使用Selenium等工具,Selenium可以模拟浏览器的行为,执行JavaScript代码,从而获取完整的页面内容。

|代码示例|功能描述|

|—-|—-|

|“csharp|using OpenQA.Selenium;<br>using OpenQA.Selenium.Chrome;<br>using System;<br>namespace SeleniumExample<br>{<br> class Program<br> {<br> static void Main(string[] args)<br> {<br> IWebDriver driver = new ChromeDriver();<br> driver.Navigate().GoToUrl("http://example.com");<br> string pageSource = driver.PageSource;<br> Console.WriteLine(pageSource);<br> driver.Quit();<br> }<br> }<br>}<br>“|使用ChromeDriver启动Chrome浏览器,导航到指定网址,获取页面源代码并输出。|

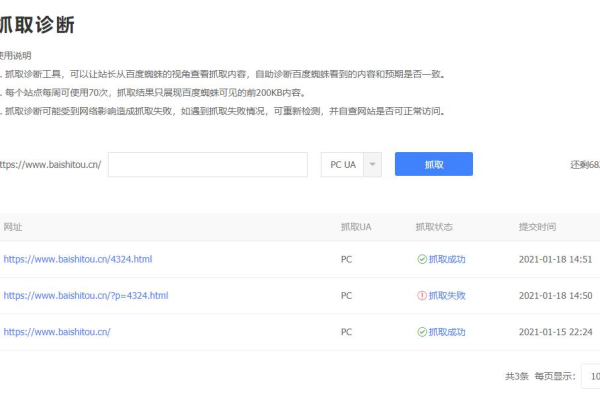

4、遵守网站的robots.txt文件:在进行网站页面抓取时,应该尊重网站的robots.txt文件,该文件规定了哪些页面可以被爬虫访问,哪些不可以,可以通过解析robots.txt文件来确定是否可以抓取某个页面。

5、注意抓取频率和礼仪:避免对目标网站造成过大的负载,应该控制抓取的频率,并且在抓取时尽量模仿真实用户的行为,如设置合适的延迟时间等。

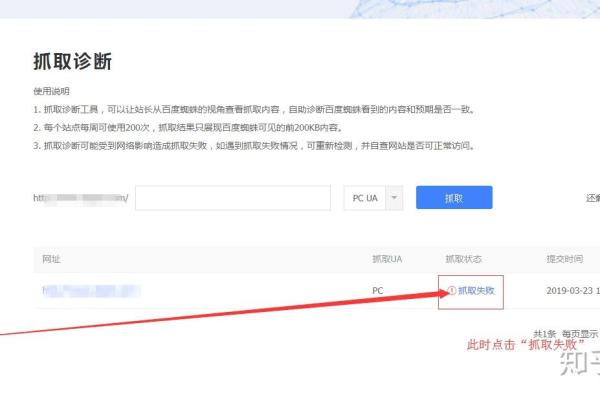

6、错误处理和异常捕获:在抓取过程中可能会遇到各种错误,如网络连接失败、页面不存在等,需要进行适当的错误处理和异常捕获,以确保程序的稳定性和可靠性。

|代码示例|功能描述|

|—-|—-|

|“csharp|try<br>{<br> // 抓取代码<br>}<br>catch (HttpRequestException e)<br>{<br> Console.WriteLine("请求错误:" + e.Message);<br>}<br>catch (Exception e)<br>{<br> Console.WriteLine("其他错误:" + e.Message);<br>}<br>“|捕获HTTP请求异常和其他异常,并输出相应的错误信息。|

7、数据存储:将抓取到的数据进行合理的存储是非常重要的,可以选择将数据存储到数据库、文件或内存中,以便后续的处理和分析,将数据存储到SQL Server数据库中:

|代码示例|功能描述|

|—-|—-|

|“csharp|using System.Data.SqlClient;<br>namespace DataStorageExample<br>{<br> class Program<br> {<br> static void Main(string[] args)<br> {<br> string connectionString = "your_connection_string";<br> using (SqlConnection connection = new SqlConnection(connectionString))<br> {<br> connection.Open();<br> string sql = "INSERT INTO Pages (Title, Content) VALUES (@Title, @Content)";<br> using (SqlCommand command = new SqlCommand(sql, connection))<br> {<br> command.Parameters.AddWithValue("@Title", "Example Title");<br> command.Parameters.AddWithValue("@Content", "Example Content");<br> command.ExecuteNonQuery();<br> }<br> }<br> }<br> }<br>}<br>“|建立与SQL Server数据库的连接,执行插入语句,将页面标题和内容存储到数据库中的Pages表中。|

C#进行网站页面抓取需要综合运用多种技术和方法,同时要遵循相关的规范和礼仪,以确保抓取过程的合法性和有效性。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/402445.html