如何用C语言编写高效网络爬虫代码?

- 行业动态

- 2025-01-30

- 2

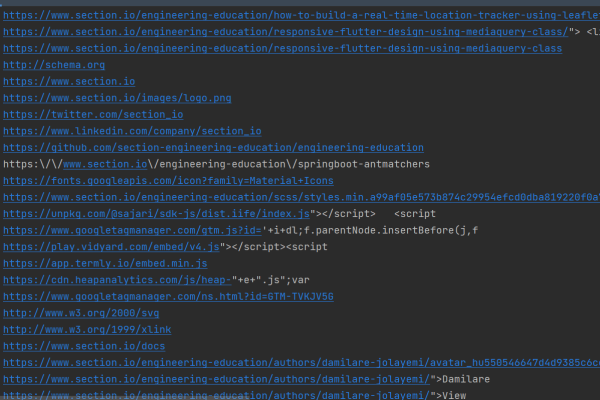

网络爬虫代码是用于自动访问互联网并抓取网页数据的程序,通常通过发送HTTP请求获取网页内容,再利用解析库提取所需信息。

在当今数字化时代,网络爬虫技术成为了获取网络数据的重要手段之一,C语言作为一种高效、灵活的编程语言,在编写网络爬虫方面具有独特的优势,下面将详细介绍如何使用C语言编写网络爬虫代码,包括网络请求与响应处理、HTML解析以及数据存储与管理等关键步骤。

一、网络请求与响应处理

网络请求与响应处理是网络爬虫的基础,它负责向目标网站发送HTTP请求并接收服务器返回的响应数据,在C语言中,我们可以使用libcurl库来实现这一功能,libcurl是一个强大的开源库,支持多种协议,包括HTTP和HTTPS,可以简化网络编程的复杂性。

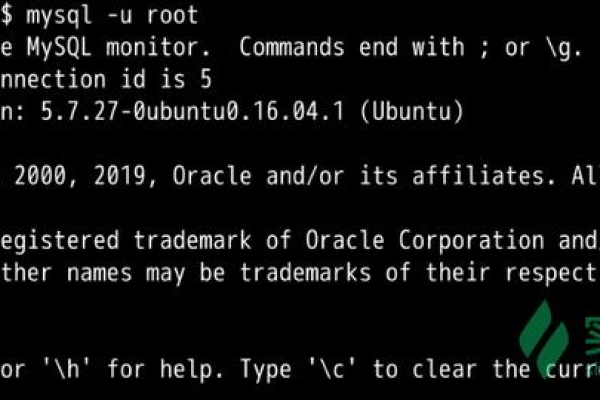

我们需要安装libcurl库,在大多数Linux发行版上,可以通过包管理器安装libcurl开发包,在Ubuntu上,可以使用以下命令安装:

sudo apt-get install libcurl4-openssl-dev

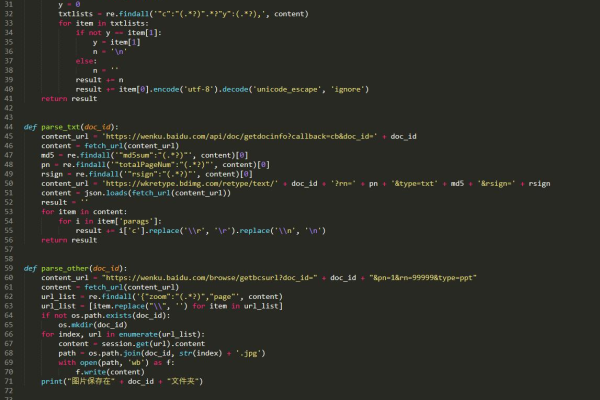

我们编写一个简单的示例代码来演示如何使用libcurl发送HTTP请求并接收响应数据:

include <stdio.h>

include <stdlib.h>

include <string.h>

include <curl/curl.h>

size_t write_callback(char *ptr, size_t size, size_t nmemb, char **userdata) {

size_t realsize = size * nmemb;

char *temp = realloc(*userdata, strlen(*userdata) + realsize + 1);

if (temp == NULL) {

fprintf(stderr, "realloc() failed

");

return 0;

}

*userdata = temp;

memcpy(&((*userdata)[strlen(*userdata)]), ptr, realsize);

(*userdata)[strlen(*userdata) + realsize] = ' 本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/402428.html