如何在Linux环境下进行CUDA编程实例开发?

- 行业动态

- 2025-01-29

- 2

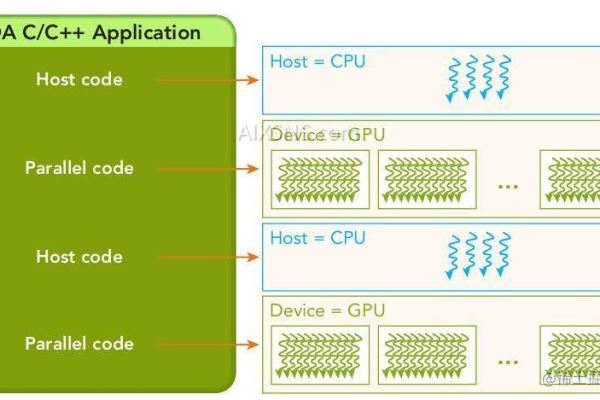

CUDA Linux实例教程助你快速掌握GPU加速编程,通过向量加法、矩阵乘法、图像处理等实例,深入理解CUDA并行计算原理与编程流程。

CUDA(Compute Unified Device Architecture)是由NVIDIA开发的一种并行计算平台和应用程序接口,它允许开发者利用GPU的强大计算能力来加速各种计算任务,在Linux系统下进行CUDA编程,需要安装相应的软件包、配置环境变量,并编写CUDA程序,以下是关于CUDA编程实例的详细内容:

CUDA编程基础

1、硬件要求:确保你的计算机安装了支持CUDA的NVIDIA GPU,可以通过以下命令查看系统中的GPU信息:

lspci | grep -i nvidia

这将列出所有NVIDIA GPU设备的信息。

2、软件安装:

NVIDIA驱动程序:首先需要安装与你的GPU兼容的NVIDIA驱动程序,可以通过NVIDIA官方网站下载适合你Linux发行版的驱动程序。

CUDA Toolkit:包含编译器(nvcc)、库文件以及示例代码等,可以从NVIDIA官网下载对应版本的CUDA Toolkit,并按照官方文档进行安装。

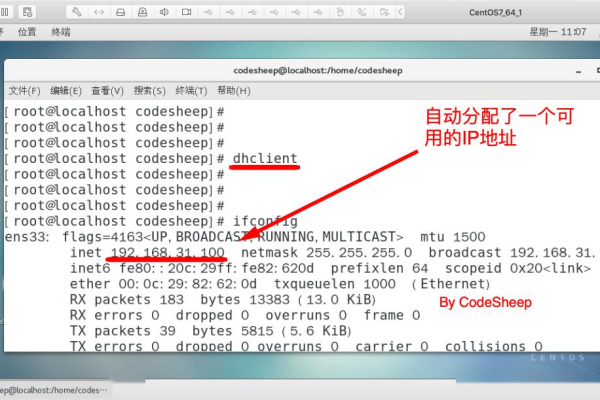

3、环境变量配置:安装完成后,需要设置环境变量以便系统能够找到CUDA相关的工具和库,通常需要在~/.bashrc或~/.zshrc文件中添加以下行(以CUDA Toolkit安装在/usr/local/cuda为例):

export PATH=/usr/local/cuda/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

然后执行source ~/.bashrc(或source ~/.zshrc)使环境变量生效。

CUDA编程实例

下面以一个简单的矩阵加法为例,展示如何在Linux下进行CUDA编程。

1、创建项目目录:首先创建一个用于存放CUDA项目的目录,例如cuda_matrix_add。

2、编写CUDA代码:

在项目目录下创建两个文件:matrix_add.cu(包含CUDA内核函数)和main.cpp(包含主函数)。

matrix_add.cu如下:

#include <cuda_runtime.h>

// 定义矩阵大小

#define MAT_SIZE 512

// CUDA内核函数,实现矩阵加法

__global__ void matrixAdd(float *A, float *B, float *C) {

int idx = threadIdx.x + blockIdx.x * blockDim.x;

if (idx < MAT_SIZE * MAT_SIZE) {

C[idx] = A[idx] + B[idx];

}

}main.cpp如下:

#include <iostream>

#include "matrix_add.cu"

using namespace std;

int main() {

// 定义矩阵大小和线程块、网格大小

const int matSize = MAT_SIZE;

const int blockSize = 256;

const int gridSize = (matSize + blockSize 1) / blockSize;

// 分配主机内存

float *h_A = new float[matSize * matSize];

float *h_B = new float[matSize * matSize];

float *h_C = new float[matSize * matSize];

// 初始化矩阵A和B

for (int i = 0; i < matSize * matSize; i++) {

h_A[i] = 1.0f;

h_B[i] = 2.0f;

}

// 分配设备内存

float *d_A, *d_B, *d_C;

cudaMalloc((void **)&d_A, matSize * matSize * sizeof(float));

cudaMalloc((void **)&d_B, matSize * matSize * sizeof(float));

cudaMalloc((void **)&d_C, matSize * matSize * sizeof(float));

// 将主机内存数据传输到设备内存

cudaMemcpy(d_A, h_A, matSize * matSize * sizeof(float), cudaMemcpyHostToDevice);

cudaMemcpy(d_B, h_B, matSize * matSize * sizeof(float), cudaMemcpyHostToDevice);

// 调用CUDA内核函数进行矩阵加法计算

matrixAdd<<<gridSize, blockSize>>>(d_A, d_B, d_C);

// 将计算结果从设备内存传输回主机内存

cudaMemcpy(h_C, d_C, matSize * matSize * sizeof(float), cudaMemcpyDeviceToHost);

// 输出计算结果的部分元素进行验证

for (int i = 0; i < 10; i++) {

cout << "C[" << i << "] = " << h_C[i] << endl;

}

// 释放设备和主机内存

cudaFree(d_A);

cudaFree(d_B);

cudaFree(d_C);

delete[] h_A;

delete[] h_B;

delete[] h_C;

return 0;

}3、编译和运行:使用以下命令编译和运行上述程序:

nvcc -o matrix_add main.cpp matrix_add.cu -lcudart ./matrix_add

如果一切正常,你将看到输出类似于:

C[0] = 3 C[1] = 3 C[2] = 3 ...

这表明矩阵加法运算成功完成。

常见问题解答(FAQs)

1、问题:如何检查CUDA是否安装成功?

回答:可以通过以下命令检查CUDA是否安装成功以及安装的版本等信息:

nvcc --version

如果CUDA安装正确,该命令将输出CUDA编译器的版本信息,还可以运行一些简单的CUDA示例程序,如deviceQuery,来验证CUDA环境是否正常工作。

./deviceQuery

如果输出显示了正确的GPU信息,说明CUDA安装成功且环境配置正确。

2、问题:在编写CUDA程序时,如何确定线程块和网格的大小?

回答:线程块(block)和网格(grid)的大小选择需要根据具体的计算任务和数据规模来确定,线程块的大小应该适中,既不能太大也不能太小,太大可能导致寄存器不足或共享内存冲突,太小则无法充分利用GPU的并行性,网格的大小则应根据数据的总量和每个线程块处理的数据量来计算,确保所有的数据都能被处理到,在上述矩阵加法的例子中,我们根据矩阵的大小和每个线程处理一个元素的原则,计算出了合适的线程块和网格大小,对于不同的应用场景,可能需要根据实际情况进行调整和优化。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/402278.html