如何将网页内容抓取并保存到数据库中?

- 行业动态

- 2025-01-29

- 4

暂未搜索到关于“将获取网页保存到数据库”的相关信息。通常情况下,摘要可能为:,,1. 通过编程实现从网页抓取数据并存储于 数据库中。,,2. 利用爬虫技术获取网页内容,再将其保存至数据库。,,3. 编写代码以实现网页数据的获取与数据库存储功能。,,4. 运用网络爬虫抓取网页信息并存入数据库系统。,,5. 借助相关技术手段把网页上的数据提取后保存在数据库里。

在当今数字化时代,互联网上的信息量呈爆炸式增长,网页作为信息的重要载体,蕴含着海量有价值的数据,将获取的网页保存到数据库中,无论是对于企业进行数据挖掘、市场分析,还是个人进行知识管理等都有着重要意义,以下将详细阐述如何用C语言实现这一功能。

一、环境搭建与准备工作

在开始编写代码之前,需要确保开发环境中已经安装了合适的编译器(如GCC),并且配置好了相关的数据库环境(以MySQL为例),需要安装用于操作数据库的C语言库,例如MySQL Connector/C,以便在C程序中能够与MySQL数据库进行交互。

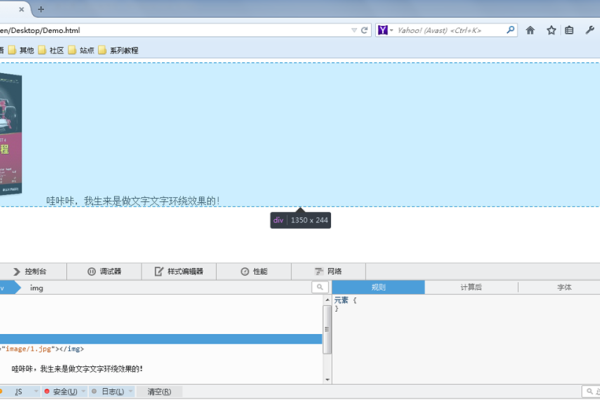

二、网页获取

1、使用libcurl库获取网页内容

libcurl是一个强大的开源库,支持多种协议的数据获取,包括HTTP,首先需要在项目中引入libcurl库。

初始化libcurl环境,设置目标URL,例如http://example.com,可以使用curl_easy_init()函数来初始化一个CURL句柄。

通过curl_easy_setopt()函数设置各种选项,如设置跟随重定向(CURLOPT_FOLLOWLOCATION)、设置超时时间(CURLOPT_TIMEOUT)等。

调用curl_easy_perform()函数执行请求,获取网页内容,该函数会将网页数据读取到一个缓冲区中。

2、处理网页内容

获取到的网页内容通常是HTML格式的字符串,如果只需要提取其中的部分数据(如特定标签内的内容),可以使用HTML解析库,如libxml2。

利用libxml2库的函数,如xmlReadMemory()将HTML字符串解析为一个可遍历的文档结构,然后可以通过XPath表达式定位到感兴趣的节点,提取节点内容。

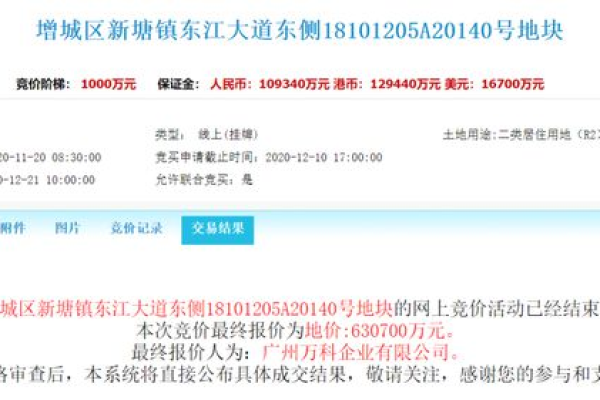

三、数据库连接与操作

1、连接到MySQL数据库

在C程序中,使用MySQL Connector/C提供的函数连接到数据库,首先需要创建一个数据库连接句柄,例如使用mysql_init()函数。

通过mysql_real_connect()函数指定数据库服务器地址、端口、用户名、密码和要连接的数据库名称等信息,建立与数据库的连接。

2、创建表(如果不存在)

在保存网页数据之前,需要确定数据库中有合适的表来存储数据,可以使用SQL语句CREATE TABLE IF NOT EXISTS来创建表,创建一个名为webpages的表,包含字段id(自增主键)、url(存储网页URL)、content(存储网页内容)等。

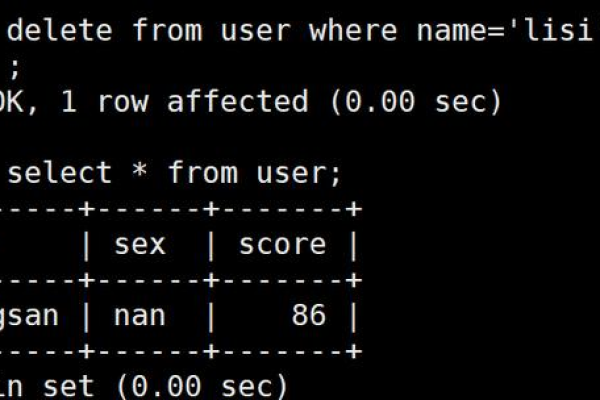

3、插入数据

将从网页中提取并处理好的数据插入到数据库表中,使用mysql_query()函数执行INSERT INTO语句,将数据插入到相应的字段中,将获取到的网页URL和内容插入到webpages表的url和content字段中。

四、错误处理与资源释放

1、错误处理

在获取网页和操作数据库的过程中,可能会出现各种错误,如网络连接失败、SQL语法错误等,需要对每个可能出错的函数调用进行检查,获取错误信息并进行处理,对于libcurl函数,可以检查返回值是否为CURLE_OK,如果不是,则使用curl_easy_strerror()函数获取错误描述并进行相应处理,对于MySQL函数,可以检查返回值是否为NULL或错误代码,并根据错误情况进行处理。

2、资源释放

在程序结束前,需要释放所有分配的资源,对于libcurl,使用curl_easy_cleanup()函数清理CURL句柄;对于MySQL,使用mysql_close()函数关闭数据库连接句柄。

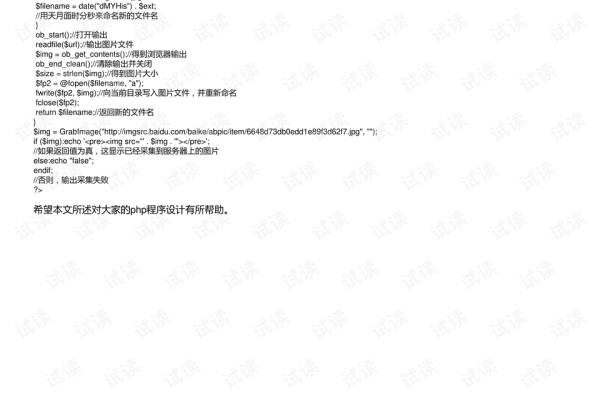

以下是一个简单的示例代码框架:

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <curl/curl.h>

#include <mysql/mysql.h>

// libcurl写回调函数,用于处理获取到的数据

size_t write_callback(void *ptr, size_t size, size_t nmemb, void *stream) {

// 这里可以将数据写入到一个字符串中,方便后续处理

return size * nmemb;

}

int main() {

CURL *curl;

CURLcode res;

MYSQL *conn;

const char *server = "localhost";

const char *user = "root";

const char *password = "password"; /* 替换为实际密码 */

const char *database = "testdb";

// 初始化libcurl

curl = curl_easy_init();

if (curl) {

curl_easy_setopt(curl, CURLOPT_URL, "http://example.com");

curl_easy_setopt(curl, CURLOPT_WRITEFUNCTION, write_callback);

res = curl_easy_perform(curl);

if (res != CURLE_OK) {

fprintf(stderr, "curl_easy_perform() failed: %s

", curl_easy_strerror(res));

}

curl_easy_cleanup(curl);

}

// 连接数据库

conn = mysql_init(NULL);

if (!mysql_real_connect(conn, server, user, password, database, 0, NULL, 0)) {

fprintf(stderr, "%s

", mysql_error(conn));

exit(1);

}

// 执行SQL查询等操作...

// 关闭数据库连接

mysql_close(conn);

return 0;

}上述代码只是一个非常基础的框架,实际应用中需要根据具体需求进行完善,如添加更多的错误处理、根据网页内容动态构建SQL语句等。

相关问答FAQs

问题1:如果网页内容非常大,一次性插入数据库可能会导致内存不足或性能问题,该怎么办?

答:可以将网页内容进行分片处理,例如按照一定的字符数或HTML标签进行分割,然后分批次插入数据库,这样可以避免一次性占用过多内存,同时也能提高插入数据的效率,可以考虑在插入数据时使用事务,以提高数据的一致性和完整性。

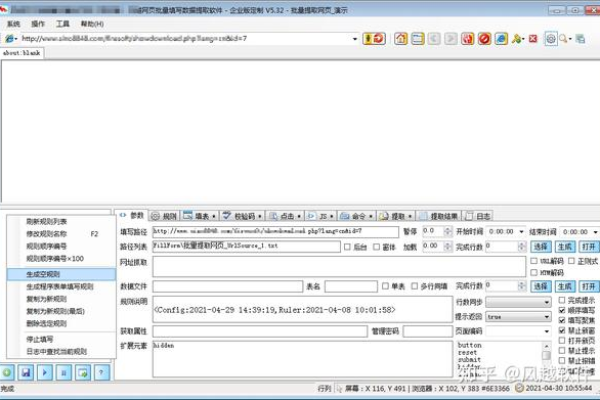

问题2:如何处理网页中的动态内容(如通过JavaScript加载的数据)?

答:对于动态加载的数据,单纯的使用libcurl获取静态网页内容可能无法获取到完整的数据,此时可以考虑使用浏览器自动化工具,如Selenium WebDriver,通过编写脚本模拟浏览器的行为,等待JavaScript执行完成后再获取页面内容,然后将获取到的内容按照正常的流程进行处理并保存到数据库中,不过需要注意的是,使用Selenium WebDriver可能会相对复杂一些,需要熟悉其相关的编程接口和操作方法。

小编有话说

将获取网页保存到数据库是一个涉及多个技术领域的复杂任务,需要综合运用网络编程、HTML解析、数据库操作等多方面的知识,在实际操作中,可能会遇到各种各样的问题,如网页结构的变化、网络环境的不稳定等,需要不断地学习和探索,灵活运用各种技术手段来解决问题,以确保能够稳定、高效地获取和保存网页数据。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/402214.html