cuda深度学习

- 行业动态

- 2025-01-29

- 2

### ,,CUDA(Compute Unified Device Architecture)是由NVIDIA开发的一种并行计算平台和编程模型,允许开发者利用GPU进行高效的并行计算。随着深度学习的发展,CUDA在加速深度学习算法方面发挥了重要作用。它通过并行处理能力和高吞吐量显著提升了模型训练和推理的速度,并支持大型模型的训练和实时数据处理。CUDA的动态资源分配和优化工具进一步提升了性能。CUDA已成为深度学习领域不可或缺的工具,推动了该领域的技术进步和应用普及。

在深度学习领域,CUDA(Compute Unified Device Architecture)技术已成为推动模型训练和推理速度提升的关键力量,以下是关于CUDA深度学习的详细内容:

一、CUDA的定义与演进

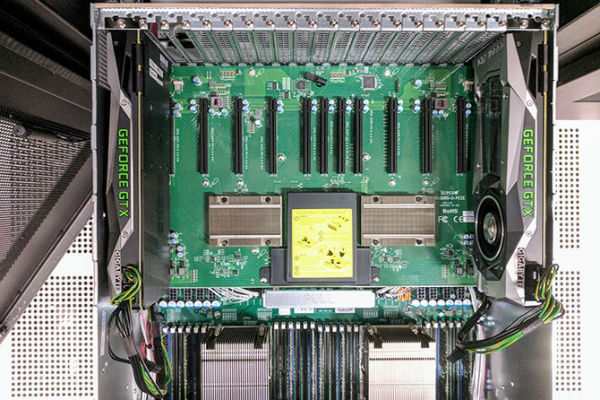

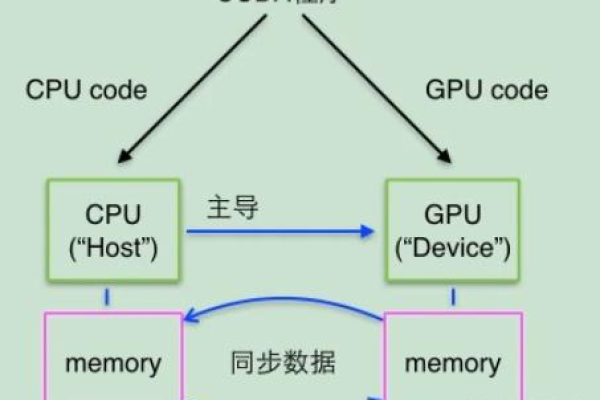

1、定义:CUDA是由NVIDIA开发的一种并行计算平台和应用编程接口(API)模型,它允许开发者使用NVIDIA的GPU进行高效的并行计算,从而加速计算密集型任务。

2、演进历程:自2006年首次发布以来,CUDA经历了多个版本的迭代,不断优化性能、增强功能并扩展其编程模型,从最初的CUDA 1.0到最新的CUDA 11.x,每个版本都在性能、易用性和编程模型等方面进行了改进和扩展。

二、CUDA与传统CPU计算的对比

1、架构差异:CPU设计注重通用性和灵活性,适合处理复杂的、串行的计算任务;而GPU则设计重点在于处理大量的并行任务,适合执行重复且简单的操作。

2、性能对比:在处理可以并行化的大规模数据时,如图像处理、科学计算等,GPU表现出远超CPU的处理速度,当任务可以并行化时,GPU在能效比上通常更有优势。

3、应用场景:CPU更适合处理复杂逻辑处理和单线程性能要求高的任务;而GPU则更适合于需要大量计算资源的深度学习模型、大规模图像或视频处理以及高吞吐量计算任务。

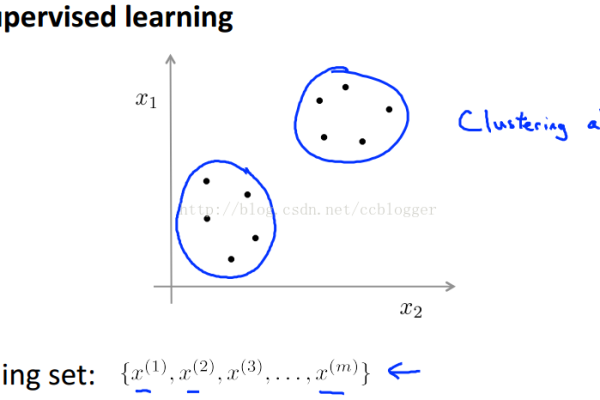

三、CUDA在深度学习中的应用

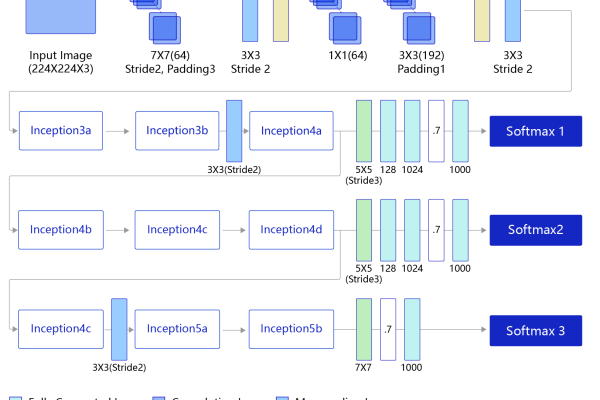

1、并行处理能力:深度学习模型需要处理大量数据,CUDA提供的并行处理能力使得这些计算可以同时进行,大幅提高效率。

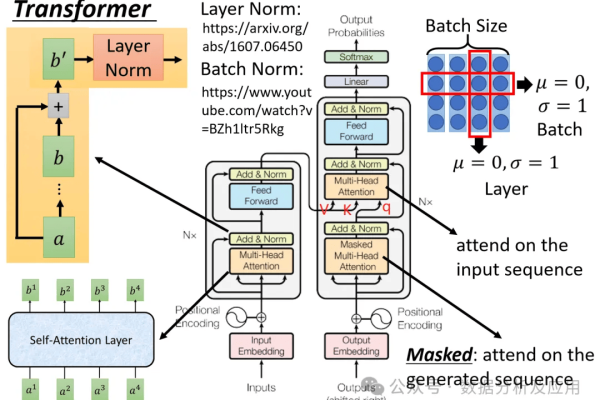

2、矩阵运算加速:神经网络的训练涉及大量的矩阵运算(如矩阵乘法),GPU的并行架构非常适合这种类型的计算。

3、高吞吐量:在深度学习中处理大型数据集时,GPU能够提供远高于CPU的吞吐量,加快模型训练和推理过程。

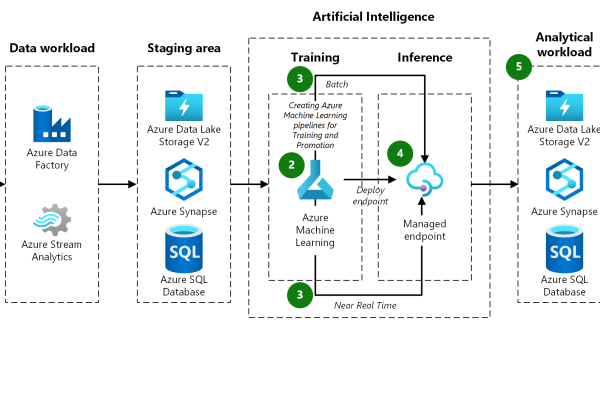

4、动态资源分配:CUDA允许动态分配和管理GPU资源,使得深度学习模型训练更为高效。

5、实时数据处理:在推理阶段,CUDA加速了数据的处理速度,使得模型能够快速响应,适用于需要实时反馈的应用,如自动驾驶车辆的视觉系统。

6、高效资源利用:在边缘计算设备上,CUDA可以提供高效的计算,使得在资源受限的环境下进行复杂的深度学习推理成为可能。

7、数据预处理:在准备训练数据时,CUDA可以用于快速加载和转换大量的输入数据,如图像或视频内容的预处理。

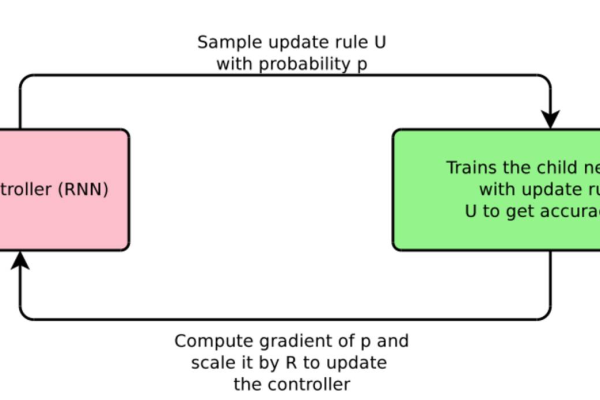

8、研究与开发:CUDA的高效计算能力使研究人员和开发者能够快速测试新的模型架构和训练策略,加速研究和产品开发的进程。

四、FAQs

1、问:CUDA是否只支持NVIDIA的GPU?

答:是的,CUDA是NVIDIA开发的技术,目前主要支持NVIDIA的GPU,随着技术的发展,也有一些开源项目和框架开始支持多平台的深度学习加速,但NVIDIA的GPU仍然是深度学习领域的主流选择。

2、问:如何安装和配置CUDA?

答:安装和配置CUDA通常需要下载NVIDIA官方网站提供的安装包,并按照官方教程进行操作,具体步骤可能因操作系统和CUDA版本的不同而有所差异,建议参考NVIDIA的官方文档和社区资源进行安装和配置。

3、问:CUDA编程是否复杂?

答:对于初学者来说,CUDA编程可能会有一定的难度,因为它涉及到GPU编程和并行计算的概念,随着越来越多的深度学习框架(如TensorFlow、PyTorch等)内置对CUDA的支持,开发者无需深入了解CUDA的内部细节即可轻松地在GPU上训练和部署模型。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/401924.html