如何在CUDA编程中有效利用局部存储器提升性能?

- 行业动态

- 2025-01-28

- 3

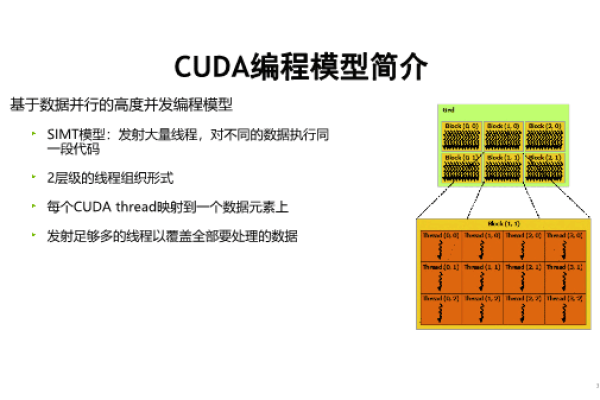

### ,,CUDA中的局部存储器是GPU片上高速缓存器,每个线程拥有私有寄存器和局部存储器,用于加速运算。

在CUDA编程中,局部存储器(Local Memory)是每个线程私有的存储空间,当寄存器被耗尽时,数据将被存储到局部存储器中,以下是关于CUDA使用局部存储器的详细回答:

一、定义与特点

1、定义:局部存储器是每个线程私有的存储空间,当寄存器被耗尽时,数据将被存储到局部存储器中。

2、特点:

每个线程私有,没有缓存,访问速度慢。

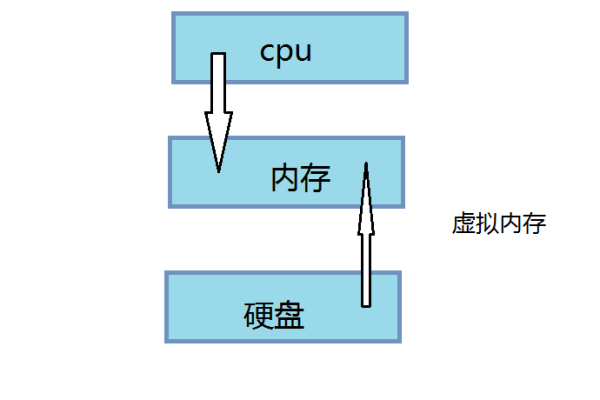

存储位置在于显存上,即在局存储器上。

二、使用场景

1、寄存器溢出:当每个线程中使用了过多的寄存器,或声明了大型结构体或数组,或编译器无法确定数组大小时,线程的私有数据就会被分配到局部存储器中。

2、动态分配:局部存储器可以在需要时动态分配,但需要注意的是,其访问速度较慢,因此应尽量避免在性能关键的代码段中使用过多的局部存储器。

三、优化建议

1、减少使用:尽量使变量可以分配到寄存器中,以减少对局部存储器的依赖,将大型结构体或数组拆分成多个较小的变量,或者使用更高效的数据结构来存储数据。

2、合理分配:在声明局部变量时,尽量使其可以分配到寄存器中,将unsigned int mt[3];改为unsigned int mt0, mt1, mt2;。

3、利用共享存储器:对于需要频繁访问的数据,可以考虑使用共享存储器来提高访问速度,共享存储器是GPU片内的高速存储器,访问速度几乎与寄存器一样快。

四、示例代码

以下是一个使用局部存储器的简单示例:

__global__ void exampleKernel(float *input, float *output) {

int idx = threadIdx.x + blockIdx.x * blockDim.x;

float temp[10]; // 假设这是一个大型数组,会被分配到局部存储器中

// 执行一些操作...

output[idx] = temp[0] + temp[1]; // 示例操作

}在这个示例中,temp数组可能会因为过大而无法完全放入寄存器中,因此部分或全部数据会被分配到局部存储器中,这会导致访问速度变慢,因此在实际应用中需要尽量避免这种情况的发生。

五、FAQs

1、问:为什么局部存储器的访问速度比寄存器慢?

答:因为局部存储器位于显存上,而不是片上的寄存器或者缓存中,显存的访问速度通常比片上存储器慢很多。

2、问:如何优化局部存储器的使用?

答:可以通过减少使用、合理分配和利用共享存储器等方法来优化局部存储器的使用,就是尽量减少在局部存储器中存储大量的数据,尽量使变量可以分配到寄存器中;在声明局部变量时注意其大小和类型;对于需要频繁访问的数据可以考虑使用共享存储器来提高访问速度。

六、小编有话说

在使用CUDA进行并行计算时,合理利用各种存储器资源对于提高程序性能至关重要,局部存储器作为每个线程私有的存储空间,虽然在某些情况下无法避免使用,但我们仍然可以通过优化代码结构和数据存储方式来减少对其的依赖,也需要注意不同存储器类型的特点和适用场景,以便在实际应用中做出更合理的选择。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/401778.html