如何高效导出百万级数据库?C语言实现方案解析

- 行业动态

- 2025-01-27

- 4

### ,,导出百万级数据库需综合运用多种策略,包括选择合适工具如mysqldump、pg_dump等,优化查询语句以提高速度,分批次导出以降低负载,提升硬件性能,关注事务管理确保数据一致性,定期备份以防数据丢失,同时可借助项目团队管理系统提高效率。

在处理大规模数据库时,导出数据是一项关键任务,对于百万级数据库的导出,需要特别注意性能、资源消耗和数据完整性,以下将详细探讨如何高效地导出百万级数据库,包括使用的工具、步骤以及注意事项。

一、选择合适的工具

1、MySQLdump

优点:简单易用,适用于各种规模的数据库。

缺点:对于非常大的数据库,可能会导致服务器负载过高。

2、pg_dump

适用场景:PostgreSQL数据库的导出。

特点:支持并行导出,可以显著提高大型数据库的导出速度。

3、Oracle Data Pump

优势:专为Oracle数据库设计,支持大数据量的快速导出。

功能:提供多种导出模式,如表空间传输、全库导出等。

4、第三方工具

例子:Navicat、HeidiSQL等。

特点:通常具有图形界面,操作更加直观。

二、导出步骤

1、准备工作

备份策略:确定是全量备份还是增量备份。

资源评估:检查服务器的内存、CPU和磁盘空间是否足够。

2、执行导出

命令行操作:根据选择的工具,执行相应的命令,使用mysqldump时,命令可能如下:

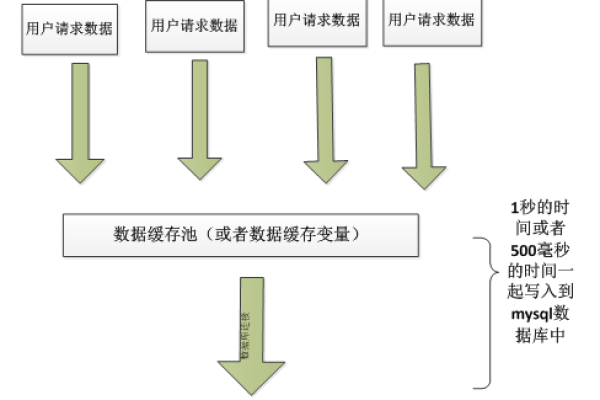

mysqldump -u username -p database_name > backup.sql参数优化:对于大数据库,可以使用多线程或分批次导出等参数来优化性能。

3、验证导出结果

数据完整性检查:确保所有表和数据都已正确导出。

一致性测试:如果可能,进行数据一致性测试以确保没有损坏的数据块。

三、注意事项

1、避免影响业务

时间选择:尽量在业务低峰期进行导出操作。

资源隔离:如果条件允许,可以在独立的服务器上进行导出。

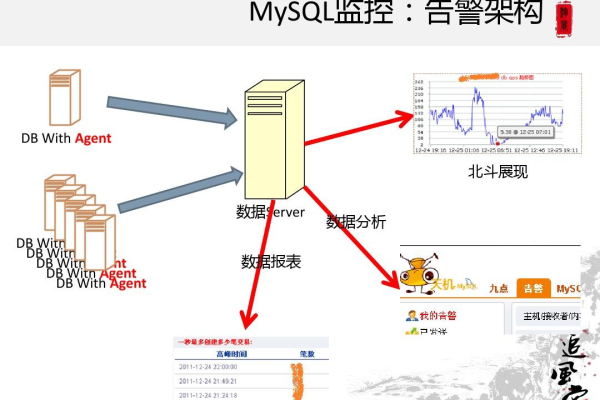

2、监控与日志记录

实时监控:观察导出过程中的资源使用情况,及时调整策略。

日志保存:保留详细的操作日志以便于后续分析和故障排查。

3、安全性考虑

加密传输:确保数据传输过程中的安全性,必要时使用SSL/TLS加密。

权限管理:严格控制对导出文件的访问权限。

四、FAQs

Q1: 如果数据库非常大,单个导出文件超过了系统限制怎么办?

A1: 可以考虑将数据库分成多个部分进行导出,或者使用支持大文件分割的工具版本,也可以调整系统的单个文件大小限制(如Linux下的file-max设置)。

Q2: 如何确保导出过程中不会因为断电或其他意外中断而导致数据丢失?

A2: 大多数现代数据库管理系统都提供了事务支持和崩溃恢复机制,在开始导出前,可以先启动一个事务;如果发生中断,可以通过回滚该事务恢复到初始状态,定期保存进度点也是一种有效的方法。

小编有话说

导出百万级数据库是一项复杂但至关重要的任务,通过合理选择工具、精心规划步骤并注意相关细节,我们可以有效地完成这一过程,希望本文能为您提供有价值的参考,帮助您更好地管理和保护您的数据资产,如果您有任何疑问或需要进一步的帮助,请随时联系我们!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/400861.html