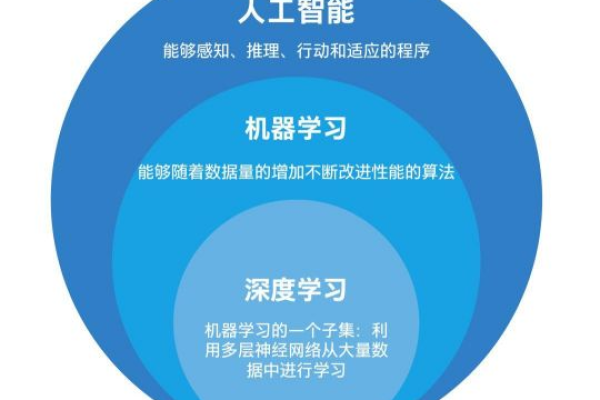

深度学习性能是否真的与CPU核心数成正比?

- 行业动态

- 2025-01-27

- 3256

### ,,CPU核心数对深度学习有重要影响,更多核心可提升并行处理能力与计算速度,但需结合内存、带宽等优化。

在深度学习领域,CPU 核心数扮演着至关重要的角色,它与模型训练的速度和效率紧密相连。

CPU 核心数对深度学习的影响

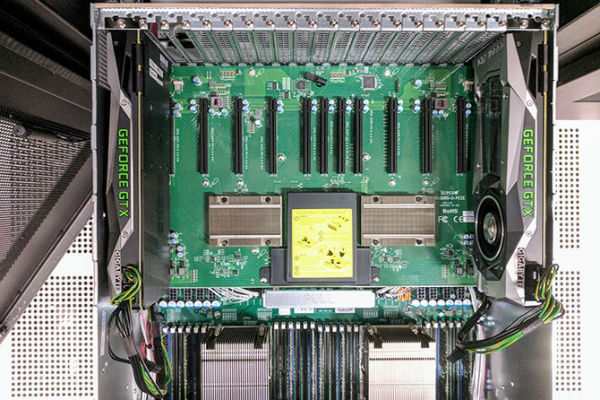

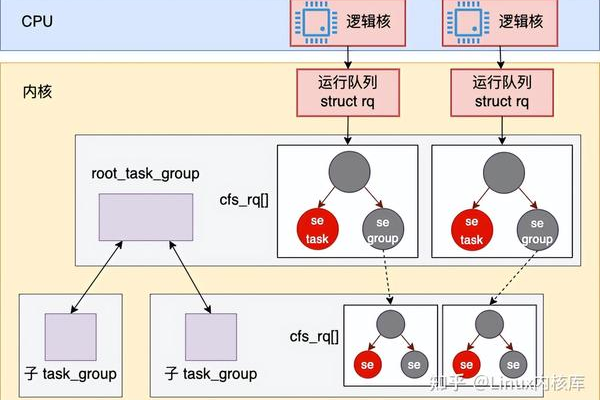

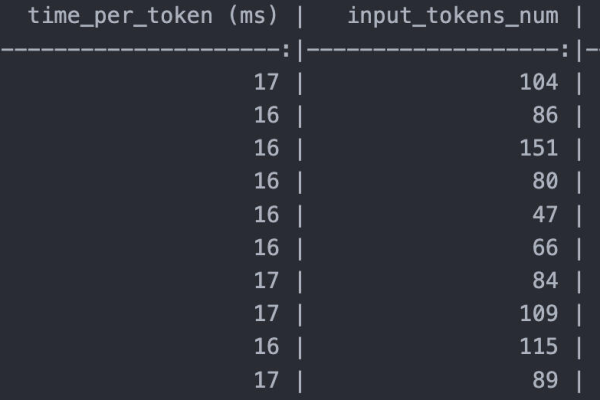

计算资源分配与并行计算能力:在深度学习中,模型的训练通常需要大量的计算资源,特别是在处理大规模数据集或复杂模型时,CPU 核心数的多少直接影响着计算资源的分配和并行计算能力,更多的 CPU 核心数意味着可以同时处理更多的计算任务,从而提高计算效率。

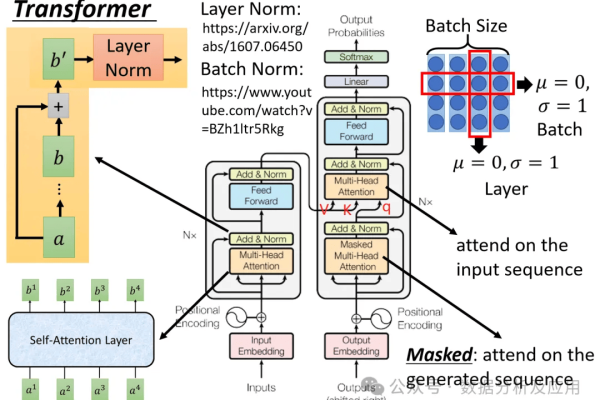

加速模型训练过程:一些常见的计算任务如矩阵乘法、卷积运算等都可以通过并行计算来加速,多核 CPU 可以同时处理多个计算任务,提高计算效率,更多的 CPU 核心数可以更好地利用计算资源,加速深度学习模型的训练过程。

利用多核 CPU 加速深度学习

设置环境变量:在实际应用中,我们通常会使用深度学习框架如 TensorFlow、PyTorch 等来构建和训练模型,这些框架通常会自动利用多核 CPU 来加速计算,在 TensorFlow 中,可以通过设置环境变量OMP_NUM_THREADS 来控制使用的 CPU 核心数,以下是一个示例代码:

import os os.environ["TF_CPP_MIN_LOG_LEVEL"] = "2" os.environ["OMP_NUM_THREADS"] = "4"

上述代码设置了OMP_NUM_THREADS 变量为 4,表示使用 4 个 CPU 核心进行计算,我们可以根据自己的计算资源情况来设置合适的 CPU 核心数,以达到最佳的计算效率。

查看当前 CPU 核心数:我们可以通过 TensorFlow 的tf.config.threading 方法来查看当前的 CPU 核心数:

import tensorflow as tf print(tf.config.threading.get_inter_op_parallelism_threads()) print(tf.config.threading.get_intra_op_parallelism_threads())

通过以上代码,我们可以查看当前 TensorFlow 所使用的 CPU 核心数,从而验证我们之前设置的核心数是否生效。

使用多核 CPU 训练模型:我们可以使用多核 CPU 来训练深度学习模型,以下是一个简单的神经网络模型训练代码:

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

model.fit(x_train, y_train, epochs=10)通过设置合适的 CPU 核心数,我们可以加速模型的训练过程,提高计算效率。

相关问答 FAQs

问:在深度学习中,CPU 核心数和频率哪个更重要?

答:在深度学习中,CPU 核心数和频率都很重要,但它们在不同的场景下发挥着不同的作用,CPU 核心数决定了同时可以处理多少个任务,对于深度学习中的并行计算任务非常关键,而 CPU 频率则决定了 CPU 处理每个任务的速度,对于单线程执行的任务或没有明显并行化的工作更有优势,综合来看,由于深度学习任务通常是高度并行的,拥有多个核心的 CPU 在多数情况下会表现得更好,在某些特定的场景下,频率同样不可忽视。

问:如何选择适合深度学习的 CPU?

答:选择适合深度学习的 CPU 需要考虑多个因素,包括核心数、频率、缓存大小、功耗等,更多的核心数和更高的频率可以提供更好的性能,还需要考虑 CPU 的缓存大小和功耗等因素,以确保在长时间运行深度学习任务时能够保持稳定的性能和较低的能耗。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/400670.html