CS231n课程中的循环神经网络(RNN)是如何工作的?

- 行业动态

- 2025-01-17

- 2521

循环神经网络(RNN)是一类用于处理序列数据的神经网络,适用于不定长输入或输出的任务。其基本结构包括隐藏状态和权重参数,通过时间步更新。

循环神经网络(Recurrent Neural Networks,RNN)是一种在处理序列数据方面表现突出的神经网络模型,与传统的前馈神经网络不同,RNN具有内部状态,可以保留和利用之前输入的信息,从而更好地处理时间序列数据,本文将详细介绍RNN的基本结构、类型、应用以及相关的变种和优化方法。

RNN的基本结构和工作原理

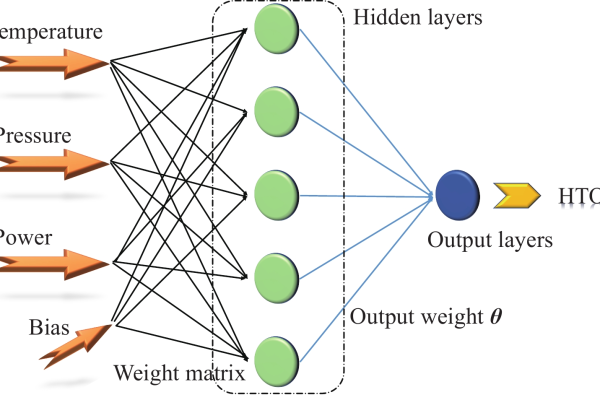

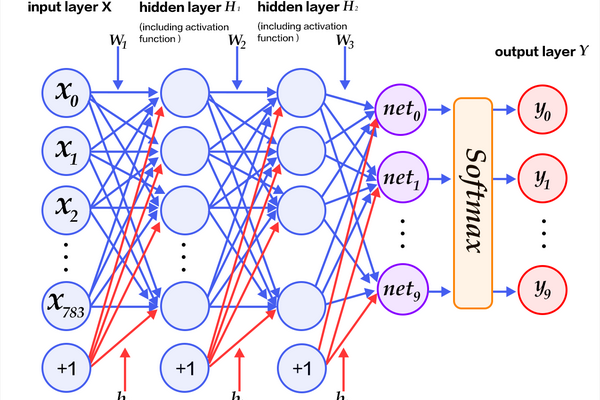

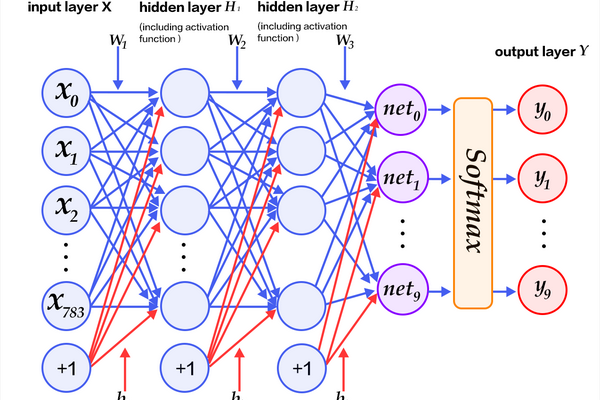

基本结构

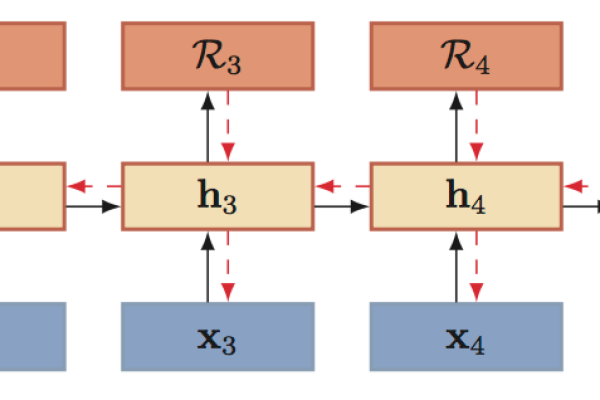

RNN的基本结构包括一个隐藏层,这个隐藏层不仅接收当前时刻的输入,还接受前一时刻隐藏层的状态,这种设计使得RNN能够记住之前的输入信息,并在当前输出中加以利用,RNN的工作流程如下:

1、输入层:接收输入数据。

2、隐藏层:结合当前输入和前一时刻的隐藏状态进行计算,更新当前的隐藏状态。

3、输出层:基于当前隐藏状态生成输出。

循环函数

RNN的核心是其循环函数,通常表示为:

[ h_t = f(W_{hh} h_{t-1} + W_{xh} x_t) ]

( h_t ) 是当前时刻的隐藏状态,( x_t ) 是当前时刻的输入,( W_{hh} ) 和 ( W_{xh} ) 分别是隐藏状态到隐藏状态和输入到隐藏状态的权重矩阵,( f ) 是激活函数,通常是tanh或ReLU。

RNN的五种类型

根据输入和输出的尺寸是否可变,RNN可以分为以下五种类型:

1、Vanilla RNN:最简单的RNN形式,输入和输出都是固定长度的序列,适用于简单的序列预测任务。

2、One to Many:输入是固定长度的序列,输出是不定长度的序列,给定一张图片,生成描述图片的句子。

3、Many to One:输入是不定长度的序列,输出是固定长度的序列,情感分析任务,输入一段文本,输出文本的情感类别。

4、Many to Many:输入和输出都是不定长度的序列,机器翻译任务,输入一句英文句子,输出对应的法文句子。

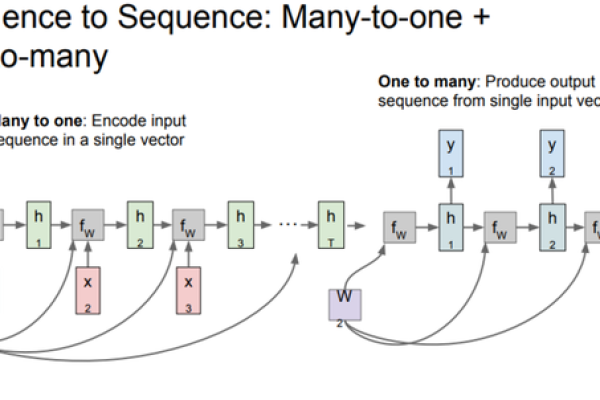

5、Sequence to Sequence:一种特殊的Many to Many模型,用于更复杂的任务如机器翻译,编码器将输入序列编码成一个向量,解码器再将该向量解码成输出序列。

RNN的应用

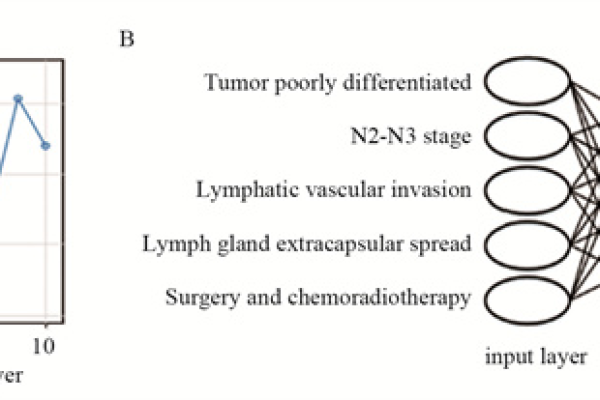

RNN在自然语言处理(NLP)和计算机视觉中有广泛的应用,以下是一些常见的应用场景:

1、语言建模:通过学习大量文本数据,RNN可以预测下一个单词或字符,从而生成自然语言。

2、图像标注:输入一幅图像,RNN可以生成描述图像内容的自然语言句子。

3、视觉问答:输入一张图片和一个用自然语言描述的问题,RNN可以输出针对问题的回答。

4、机器翻译:将一种语言翻译成另一种语言,这是典型的Many to Many任务。

RNN的变种和优化

尽管RNN在处理序列数据方面有优势,但它也存在一些缺陷,如梯度消失和梯度爆炸问题,为了克服这些问题,研究者提出了一些改进的RNN变种:

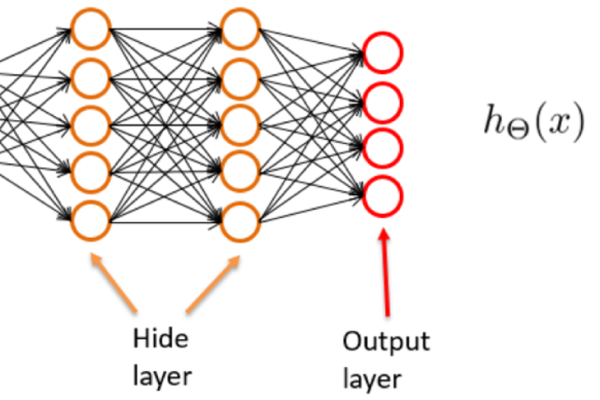

1、多层递归神经网络(Multilayers RNN):通过增加隐藏层的数量,可以提高模型的表达能力和效果。

2、长短期记忆网络(LSTM):LSTM通过引入记忆单元和门控机制,有效解决了梯度消失问题,适合处理长时间依赖的数据。

3、门控循环单元(GRU):GRU是LSTM的简化版,计算效率更高,同时保持了较好的性能。

Q&A

Q1: 为什么在测试阶段不能直接输入softmax向量?

A1: 在测试阶段输入softmax向量会导致模型产生偏差,因为训练阶段使用的是one-hot向量,softmax向量计算复杂度较高,不适合大规模数据处理。

Q2: 如何应对RNN的梯度消失问题?

A2: 梯度消失问题可以通过使用LSTM或GRU等改进的RNN结构来解决,这些结构通过引入门控机制和记忆单元,有效缓解了梯度消失问题。

小编有话说

RNN作为深度学习的重要模型之一,在处理序列数据方面展现了强大的能力,它的应用并不仅限于NLP和计算机视觉,还可以扩展到更多需要序列建模的领域,随着技术的不断进步,我们可以期待更多高效的RNN变种和应用出现,希望本文能帮助读者更好地理解RNN的原理和应用,激发大家在深度学习领域的兴趣和创造力。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/395352.html