光年日志分析工具使用技巧

- 行业动态

- 2025-04-23

- 2

聚焦核心指标,善用过滤与搜索功能,结合时间轴定位异常,巧用图表可视化分析

数据导入与预处理

支持的文件格式

| 文件类型 | 说明 |

|---|---|

.log |

通用文本日志,按行解析 |

.csv |

结构化数据,自动识别表头 |

.json |

支持嵌套结构,需配置路径表达式 |

.parquet |

列式存储,适合大规模数据 |

预处理建议:

- 时间字段格式化:统一为

YYYY-MM-DD HH:MM:SS格式 - 字段映射:通过配置文件指定原始字段与系统字段的对应关系

- 数据清洗:启用

drop-field参数过滤无关字段(如调试信息)

查询语言基础

核心语法结构

SELECT [fields] FROM [index] WHERE [conditions] [GROUP BY] [ORDER BY] [LIMIT]

常用过滤条件:

| 操作符 | 示例 | 说明 |

|——–|——|——|

| | status == 200 | 精确匹配 |

| | method != "GET" | 排除指定值 |

| | message =~ "error" | 正则匹配 |

| > | duration > 100 | 数值比较 |

| EXISTS| EXISTS field | 字段存在性检测 |

聚合函数:

COUNT():统计事件总数SUM(field):数值字段求和AVG(field):平均值计算TERCENT(field):三分位数统计HISTOGRAM(field, bin):直方图分布

可视化配置技巧

图表类型选择指南

| 分析场景 | 推荐图表 | 配置要点 |

|---|---|---|

| 趋势分析 | 折线图 | 设置时间粒度(自动采样) |

| 分布统计 | 柱状图 | 启用堆叠模式查看细分 |

| 异常检测 | 散点图 | 配置阈值警戒线 |

| 占比分析 | 饼图 | 限制分类数量(建议<8) |

| 关联分析 | 热力图 | 设置相关性计算方式 |

颜色主题定制:

通过theme.json文件修改配色方案,支持:

- 预设主题:

light/dark/high-contrast - 自定义色板:

["#447ADB", "#EE6666", ...] - 动态渐变:

heatmap: true实现温度映射

性能优化策略

索引优化方案

| 优化类型 | 实施方法 | 效果 |

|---|---|---|

| 字段索引 | index-field: ["user_id", "status"] |

加速等值查询 |

| 倒排索引 | enable-inverted: true(适用于文本字段) |

提升全文搜索速度 |

| 分区策略 | partition-by: ["date_hour"] |

按时间粒度拆分数据块 |

| 压缩配置 | compression: "lz4" |

平衡存储空间与查询性能 |

查询加速技巧:

- 使用

FETCH_FIELDS限定返回字段 - 复杂计算前置:

WITH子句预聚合 - 时间范围过滤优先:

time >= "$start" - 避免

SELECT,指定必要字段

告警规则设置

触发条件配置

alert:

name: HighErrorRate

condition: "SUM(status=500) / SUM(status=200) > 0.05"

period: 5m

for: 2m

actions:

"notify-team"

"create-incident"

通知渠道集成:

| 渠道类型 | 配置参数 | 说明 |

|———-|———-|——|

| Webhook | url: "https://hook.example.com", method: POST | 自定义HTTP回调 |

| Email | to: ["admin@domain.com"], smtp-server: smtp.example.com | 邮件通知 |

| Slack | channel: #alerts, webhook-url: "..." | 即时消息推送 |

| PagerDuty| api-key: "xxxx", service-id: "12345" | 事件工单集成 |

权限管理方案

角色权限矩阵

| 角色 | 数据查看 | 查询执行 | 告警管理 | 配置修改 |

|---|---|---|---|---|

| Observer | ||||

| Editor | ||||

| Admin | ||||

| CustomRole | 自定义字段权限组合 |

安全策略:

- 强制访问控制(RBAC)

- 敏感字段脱敏:

mask-fields: ["password", "token"] - API密钥管理:设置有效期和IP白名单

- 审计日志:记录所有数据访问操作

相关问题与解答

Q1:如何处理超过10TB的日志文件导入?

A1:建议采用以下方案:

- 使用

filebeat进行流式传输,配置buffer-size和flush-interval参数 - 启用分布式导入:将文件拆分为多个分片并行处理

- 创建中间暂存索引,使用

_bulkAPI批量提交 - 监控磁盘IO状态,必要时启用SSD缓存层

- 示例配置:

importer: mode: distributed shard-size: 2GB concurrency: 4

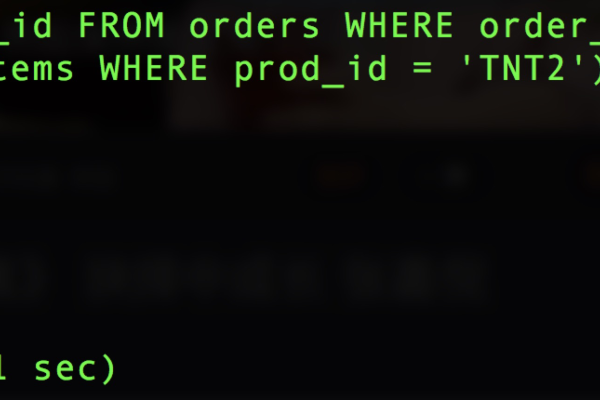

Q2:如何实现跨多个日志源的联合查询?

A2:操作步骤如下:

- 确保各日志源建立索引时使用统一的时间字段命名(建议

@timestamp) - 在查询中使用

INDEX关键字指定多个索引:SELECT FROM index1, index2, index3 WHERE @timestamp >= '2023-01-01' AND user_id = 'abc123'

- 配置跨源关联字段(需在索引设置中声明):

{ "mappings": { "properties": { "user_id": {"type": "keyword", "cross-source": true} } } } - 使用

JOIN语法进行多表关联(需开启索引间的关联配置)