光学文字识别系统

- 行业动态

- 2025-04-23

- 6

光学文字识别系统通过光学扫描将图像转为数字信号,经图像处理、文字分割、特征提取及识别,实现图文转换,广泛应用于文档电子化、车牌识别

光学文字识别系统(OCR)

光学文字识别(Optical Character Recognition, OCR)是通过光学设备(如扫描仪、摄像头)获取图像,将图像中的文字转换为可编辑文本的技术,其核心目标是实现从图像到结构化文本的自动化转换,广泛应用于文档数字化、自动驾驶、智能安防等领域。

系统核心原理

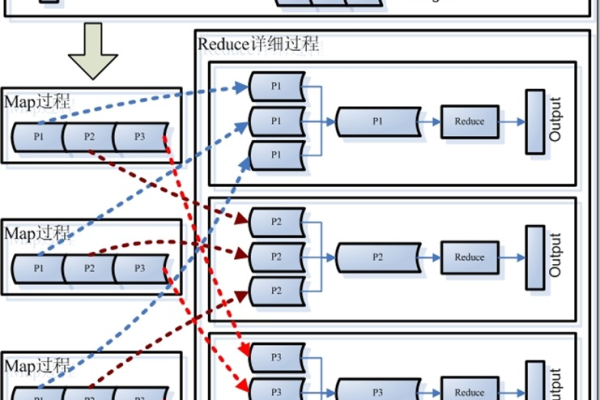

OCR系统通过以下步骤实现文字识别:

- 光学成像:通过扫描或拍摄获取纸质文档或屏幕文字的图像。

- 预处理:对图像进行去噪、二值化、倾斜校正等操作,提升文字清晰度。

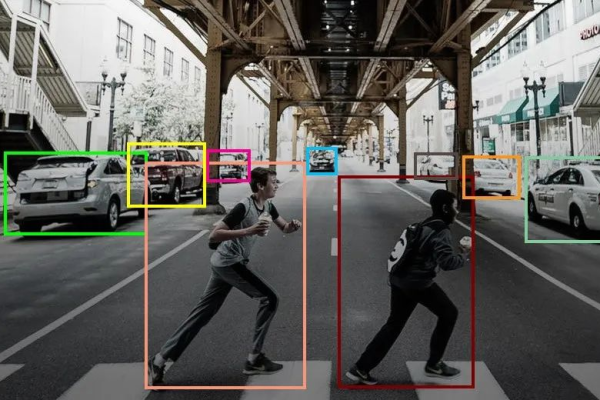

- 文字检测:定位图像中的文字区域(如段落、表格、手写体)。

- 字符分割:将文本行拆分为单个字符(针对印刷体)或保留语义块(针对手写体)。

- 特征提取:提取字符的形态特征(如笔画、结构)或深度学习特征(如卷积神经网络特征)。

- 字符分类:通过分类模型(如SVM、CNN)识别字符类别,并输出文本结果。

系统组成模块

| 模块类型 | 功能描述 |

|---|---|

| 图像采集模块 | 通过扫描仪、摄像头或手机拍照获取原始图像,需保证分辨率、光照均匀性。 |

| 预处理模块 | 图像去噪(如高斯滤波)、二值化(如Otsu算法)、透视矫正(如仿射变换)。 |

| 文字检测模块 | 基于传统算法(如MSER、HOG)或深度学习(如CTPN、DBNet)定位文字区域。 |

| 字符识别模块 | 印刷体识别:基于模板匹配或SVM;手写体识别:基于CNN(如ResNet、Transformer)。 |

| 后处理模块 | 校正识别错误(如拼写检查)、还原排版(如段落、表格结构)。 |

关键技术对比

| 技术类型 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

| 传统图像处理 | 印刷体文档、高清晰度图像 | 速度快、无需训练数据 | 对手写体、复杂排版鲁棒性差 |

| 深度学习 | 手写体、复杂背景、低质量图像 | 精度高、适应多样化字体和排版 | 需要大量标注数据、计算资源消耗大 |

典型应用场景

- 文档数字化:将纸质书籍、档案转换为可搜索的电子文本(如Google Books、档案馆数字化)。

- 身份证/银行卡识别:自动提取证件关键信息(如姓名、号码),用于金融、政务领域。

- 手写体转文本:会议纪要、手写笔记的数字化(如Notability、CamScanner)。

- 工业自动化:生产线上的产品标签识别、设备参数读取。

- 医疗影像分析:CT/MRI报告中的文字提取与结构化存储。

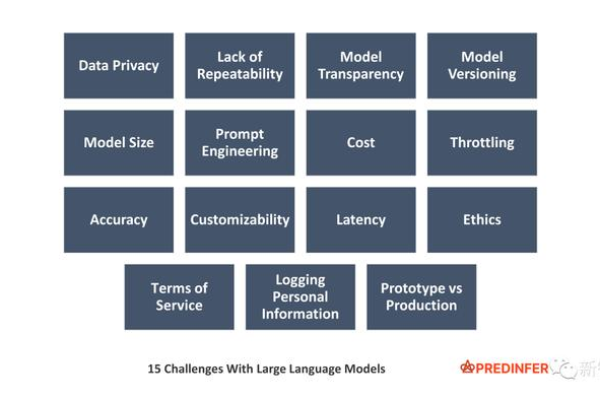

挑战与解决方案

| 挑战 | 解决方案 |

|---|---|

| 光照不均 | 使用自适应阈值算法(如局部自适应二值化)或深度学习光照归一化模型。 |

| 复杂排版 | 基于语义分割的表格/公式识别算法(如BERT+ViT混合模型)。 |

| 多语言支持 | 训练多语言联合识别模型(如Tesseract支持100+语言),或语言分类+单语言模型。 |

| 手写体多样性 | 数据增强(如旋转、扭曲)+ 大规模手写数据集预训练(如IAM Handwriting Dataset)。 |

相关问题与解答

问题1:传统OCR与基于深度学习的OCR有何本质区别?

解答:

- 传统OCR:依赖手工设计特征(如笔画方向、结构特征),通过分类器(如SVM)识别字符,对规则化印刷体效果较好,但对噪声、变形敏感。

- 深度学习OCR:通过CNN/Transformer自动提取高层次特征,端到端训练,对手写体、复杂背景适应性强,但需要大量标注数据和算力。

问题2:如何解决OCR在移动端的实时性问题?

解答:

- 模型轻量化:采用MobileNet、ShuffleNet等轻量级网络,减少参数量和计算量。

- 离线推理:通过TensorRT、MNN等框架优化模型部署,支持CPU/GPU混合加速。

- 图像压缩:预处理阶段降低图像分辨率(如300dpi→150dpi),平衡速度与精度。

- 硬件加速:利用手机NPU或专用AI芯片(如华为NPU、高通DSP)提升推理