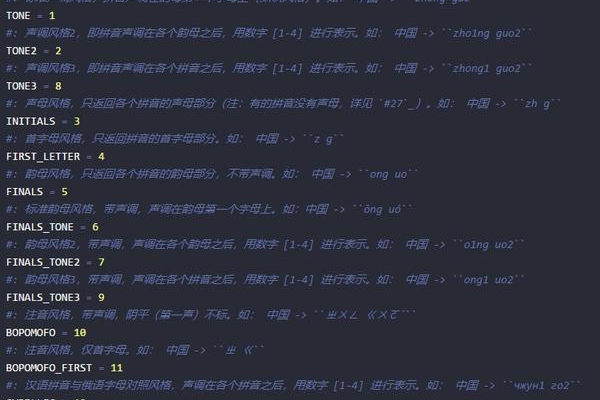

个性语音合成

- 行业动态

- 2025-04-23

- 2

个性语音合成基于声学模型及文本处理技术,融合深度学习与对抗生成网络,实现音色、情感、语调的精准定制,广泛应用于智能客服、有声阅读及虚拟主播等领域,兼具自然流畅与个性化表达

个性语音合成详解

定义与原理

个性语音合成是通过技术手段模拟特定个人的声音特征,生成具有该人物语音特点的音频内容,其核心在于提取目标人物的音色、语调、发音习惯等个性化参数,并结合文本转换为语音的技术,实现高度拟真的语音复制。

实现流程

| 步骤 | 技术要点 | 工具/方法 |

|---|---|---|

| 语音数据采集 | 录制目标人物的大量语音样本,覆盖不同语句、情感状态 | 专业录音设备、安静环境 |

| 数据预处理 | 降噪、去静音、归一化处理,切割为短时语音片段 | Praat、Adobe Audition |

| 声学模型训练 | 提取梅尔频谱、基频等声学特征,构建神经网络模型 | Kaldi框架、TensorFlow/PyTorch |

| 个性化调整 | 通过少量样本微调模型参数,捕捉说话人特质 | 迁移学习、对抗生成网络(GAN) |

| 语音合成 | 输入文本→预测声学参数→波形生成 | WaveNet、Tacotron系列模型 |

关键技术对比

| 技术类型 | 适用场景 | 优缺点 |

|---|---|---|

| 参数合成 | 实时性要求高的场景(如导航) | 合成速度快,但自然度较低 |

| 拼接合成 | 对音质要求极高的应用(如广播) | 音质接近真人,但数据依赖性强 |

| 深度学习合成 | 个性化定制服务(如虚拟主播) | 灵活性高,需大量训练数据 |

典型应用场景

- 虚拟偶像/数字人:为动漫角色、虚拟主播赋予独特声线

- 辅助残障人士:模仿使用者声音生成语音,提升交流自然度

- 影视配音:快速生成演员原声的多语言版本

- 游戏NPC:创建数万种差异化的角色语音库

伦理与挑战

- 隐私风险:未经授权的声音克隆可能侵犯个人权益

- 深度伪造:需防范反面伪造名人语音进行诈骗

- 技术瓶颈:情感表达丰富度仍低于真人,复杂语境下易出现机械感

相关问题与解答

Q1:个性语音合成需要采集多少数据?

A1:基础模型训练通常需要数百小时的通用语音数据,个性化调整阶段仅需10-30分钟的目标人物语音样本,数据质量比时长更重要,需包含多种语句类型和情感状态。

Q2:如何防止他人盗用我的声音进行合成?

A2:现有防护措施包括:

- 声纹生物识别技术,验证语音来源合法性

- 数据水印嵌入,追踪非规合成内容

- 立法保护,如欧盟《声音指令》已将声音认定为个人生物特征数据