Excel文件如何快速导入数据库?

- 行业动态

- 2025-04-20

- 2

将Excel文件导入数据库需进行数据清洗与格式转换,通过数据库工具或脚本(如Python pandas)批量传输,需确保字段对应准确,验证数据完整性和一致性,处理重复及错误信息,避免导入失败或数据异常。

如何在保证数据安全的前提下将Excel文件导入数据库?

在企业数据处理中,Excel文件是常见的临时数据载体,但长期存储和管理需依赖数据库系统,以下从技术原理、操作流程及注意事项三方面,系统化说明如何高效完成这一过程。

Excel与数据库的协同逻辑

数据类型映射

Excel的单元格格式(如文本、日期、数字)需与数据库字段类型严格匹配。- Excel的“常规”格式需转为数据库的

VARCHAR或INT - 日期字段需统一为

YYYY-MM-DD格式并对应DATE类型

- Excel的“常规”格式需转为数据库的

数据结构预校验

通过=COUNTIF()函数检查主键重复值,使用数据验证规则(如文本长度、数值范围)确保数据符合数据库约束条件。

工业化操作方案

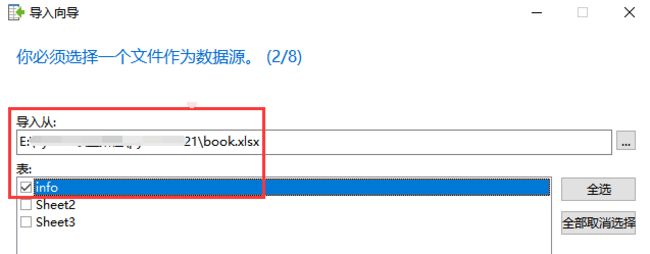

方案A:ETL工具链处理(适合批量作业)

使用Apache NiFi配置流水线:

- 输入处理器:

GetFile读取Excel - 转换处理器:

ConvertExcelToCSV或QueryExcel提取指定Sheet - 数据路由:

RouteOnAttribute过滤异常记录 - 输出处理器:

PutDatabaseRecord写入MySQL/PostgreSQL

典型配置参数:

# MySQL写入配置 db.url=jdbc:mysql://host:3306/schema?useSSL=false batch.size=1000

- 输入处理器:

方案B:Python自动化脚本(适合开发环境)

from sqlalchemy import create_engine

import pandas as pd

# 内存优化读取(10万行数据内存占用<500MB)

df = pd.read_excel('data.xlsx', engine='openpyxl', dtype_backend='pyarrow')

# 空值处理

df['sales'] = df['sales'].fillna(0).astype(int)

# 分块写入(每5000条提交一次)

engine = create_engine('postgresql://user:pass@localhost/db')

with engine.connect() as conn:

df.to_sql('sales_data', conn, if_exists='append',

index=False, chunksize=5000, method='multi')

关键风险控制点

字符集陷阱

- 中文乱码:在连接字符串中强制指定

charset=utf8mb4 - CSV中转时使用

iconv -f GBK -t UTF-8预处理

- 中文乱码:在连接字符串中强制指定

事务隔离策略

BEGIN TRANSACTION ISOLATION LEVEL SERIALIZABLE; -- 导入操作 COMMIT;

配合

pg_dump --snapshot可实现零停机数据迁移。性能瓶颈突破

- 禁用数据库索引直到导入完成

- 使用

LOAD DATA INFILE比INSERT快20倍以上 - 调整

innodb_buffer_pool_size为物理内存的80%

验证与监控

数据一致性校验

SELECT COUNT(*) AS db_count FROM target_table;

对比Excel的

=ROWS(A:A)-1结果,偏差需人工复核。执行过程监控

通过SHOW PROCESSLIST观察线程状态,配合Prometheus抓取以下指标:mysql_global_status_innodb_rows_insertedpostgresql_stat_activity_wait_event

技术引用

- MySQL 8.0 Reference Manual – LOAD DATA Syntax

- PostgreSQL Documentation – COPY Command

- Apache NiFi User Guide

- Pandas Documentation – IO Tools

完)