光学符号识别技术和语音识别的流程

- 行业动态

- 2025-04-23

- 2

光学符号识别通过图像处理、字符分割及特征匹配 识别文字;语音识别则经音频处理、特征提取,利用声学与语言模型转换语音为

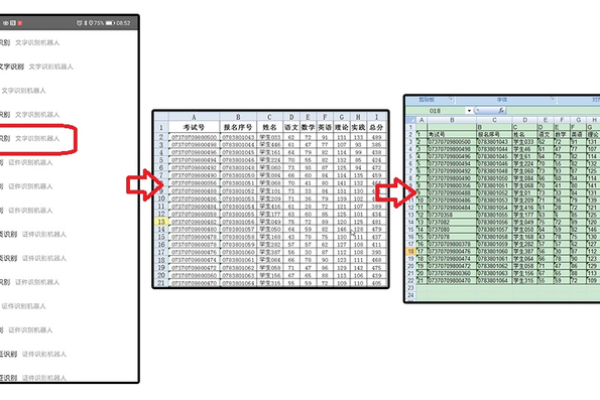

光学符号识别技术(OCR)流程

图像预处理

- 灰度化:将彩色图像转为灰度图,减少计算量。

- 二值化:通过阈值分割,将图像转为黑白像素(如Otsu算法)。

- 降噪:去除干扰点(如高斯滤波、中值滤波)。

- 倾斜校正:检测并修正文本倾斜(如Hough变换)。

文字区域检测

- 文本定位:识别图像中的文字区域(算法如CTPN、EAST)。

- 版面分析:分割段落、标题、表格等结构(基于布局或语义)。

字符分割

- 单字切割:将文本行拆分为单个字符(适用于印刷体)。

- 自适应分割:处理连笔或特殊字体(如基于深度学习的实例分割)。

字符识别

- 特征提取:传统方法(如HOG、LBP)或深度特征(CNN)。

- 分类模型:基于CTC损失(如CRNN)、注意力机制或Transformer。

后处理校正

- 拼写检查:结合词典修正错误结果(如编辑距离算法)。

- 语义纠错:利用NLP模型修正语法或上下文错误。

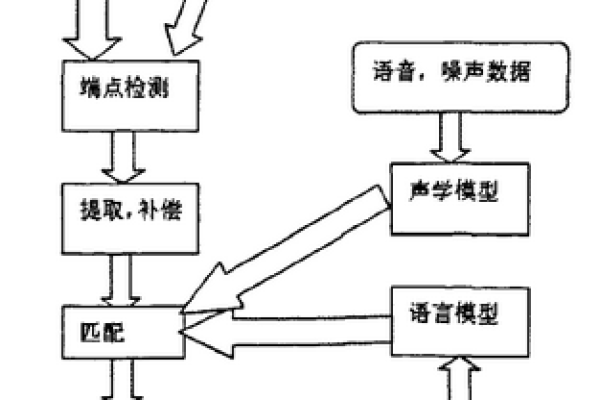

语音识别技术(ASR)流程

音频预处理

- 降噪:去除背景噪声(如谱减法、Wiener滤波)。

- 端点检测:标记语音起始和结束点(基于能量或零交叉率)。

- 分帧:将音频分割为短帧(通常20-40ms,帧移10-20ms)。

特征提取

- 声学特征:提取MFCC(13-40维)、梅尔频谱或FBank。

- 归一化:倒谱均值方差归一化(CMNV)或全局归一化。

声学模型建模

- 传统模型:HMM+GMM(混合高斯模型)。

- 深度学习模型:CNN(时频特征提取)、RNN(捕捉时序依赖)、Transformer(自注意力机制)。

语言模型融合

- 统计语言模型:N-gram(如三元模型)或基于神经网络的语言模型(如BERT)。

- 解码策略:维特比算法(传统)或束搜索(Beam Search)生成最优文本。

输出优化

- 置信度筛选:过滤低置信度结果(如CTC空白符处理)。

- 语义校正:结合领域词典或上下文修正(如数字、专有名词)。

相关问题与解答

问题1:OCR和语音识别在处理噪声数据时有何不同?

解答:

- OCR主要依赖视觉信息,噪声可能来自模糊、光照不均或复杂背景,需通过图像增强(如锐化、对比度调整)或深度学习降噪(如U-Net)解决。

- 语音识别的噪声来自环境音或录音设备,需通过信噪比提升(如麦克风阵列)、声学模型鲁棒性训练(如多噪声数据增强)或后端语音增强算法(如Deep Denoising)处理。

问题2:如何提升OCR对不规则字体(如手写体)的识别率?

解答:

- 数据增强:合成旋转、扭曲、形变字体,增加模型泛化性。

- 模型改进:使用序列到序列模型(如Transformer或CRNN)捕捉笔画顺序,或引入注意力机制关注关键区域。

- 后处理优化:结合字形结构规则(如笔画连贯性)修正识别结果,或利用语言模型纠正语义