GPU服务器究竟值不值得投资?

- 行业动态

- 2025-04-22

- 1

GPU服务器在处理高性能计算、深度学习及图形渲染等任务时优势显著,依托并行计算能力可大幅提升效率,适合AI训练、科学模拟等场景,但其成本较高且功耗较大,需结合具体需求评估性价比,非密集型任务可能造成资源浪费。

GPU服务器好不好?一文讲透核心价值与适用场景

在人工智能、大数据分析等高性能计算需求激增的背景下,GPU服务器成为企业和科研机构热议的技术工具,但对于普通用户而言,“GPU服务器究竟好不好”“是否值得投入成本”等问题仍存疑虑,本文从技术原理、实际应用及行业趋势出发,为您全面解析。

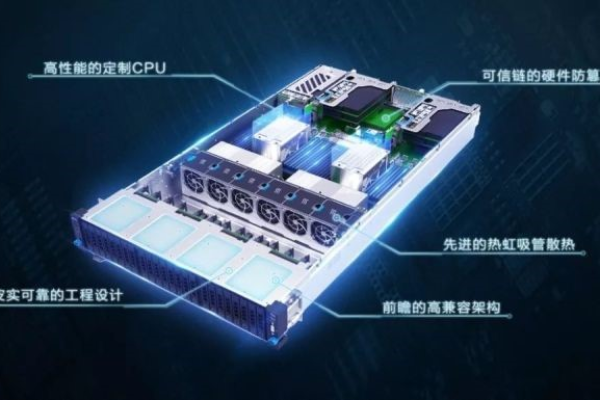

GPU服务器的核心优势:为何“强于CPU”?

GPU(图形处理器)与CPU(中央处理器)的设计逻辑截然不同。

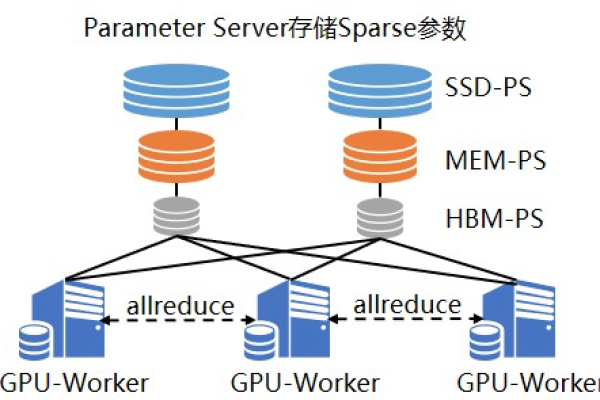

- 并行计算能力突出:GPU拥有数千个计算核心(如NVIDIA A100含6912个CUDA核心),擅长同时处理海量简单任务,如深度学习模型训练、图像渲染等,效率可达CPU的数十倍。

- 高吞吐量支持:在需要实时处理TB级数据的场景(如自动驾驶、气象模拟)中,GPU服务器能显著缩短计算时间。

- 能效比更优:以同等算力为标准,GPU的功耗成本通常低于多台CPU集群。

案例佐证:

- OpenAI训练GPT-3时,使用数千块GPU并行计算,若换成CPU,耗时可能从数周延长至数年。

- 某电商平台采用GPU服务器优化推荐算法,点击率提升30%,响应速度提高5倍。

哪些场景需要GPU服务器?

并非所有业务都需GPU加持,但以下领域已将其视为“刚需”:

- 人工智能与机器学习

深度学习模型训练、自然语言处理(NLP)、计算机视觉(CV)依赖GPU加速。

- 科学计算与仿真

基因测序、流体力学模拟、金融风险建模等需大量并行计算的任务。

- 图形渲染与元宇宙

影视特效、3D建模、虚拟现实(VR)内容制作依赖GPU实时渲染。

- 边缘计算与物联网

智能安防、工业质检等场景中,GPU服务器可部署在边缘端完成实时推理。

数据支撑:

据IDC报告,2025年全球GPU服务器市场规模同比增长43%,其中AI领域采购占比超60%。

潜在不足:GPU服务器不适合所有人

尽管性能卓越,GPU服务器存在以下局限性:

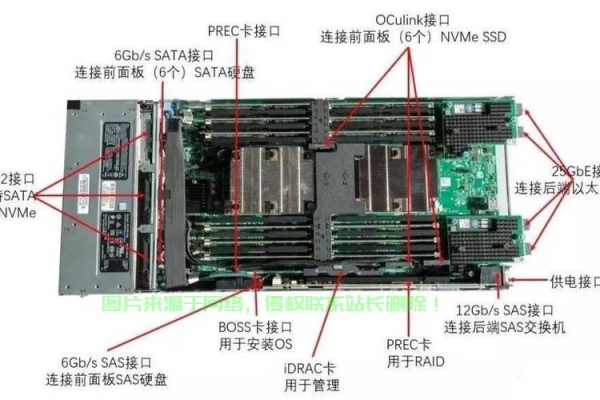

- 成本高昂:单块高端GPU(如NVIDIA H100)售价超3万美元,且需配套散热、电源等设施。

- 编程门槛高:需掌握CUDA、OpenCL等并行框架,对开发团队技术要求严格。

- 通用性受限:对顺序逻辑强、并行度低的任务(如常规数据库操作),CPU更具性价比。

如何判断是否需要GPU服务器?

可通过三个维度评估:

- 业务需求

是否涉及密集计算?任务是否可并行化?

- ROI分析

预计提升的效率和收益能否覆盖硬件与运维成本?

- 技术储备

团队是否具备GPU优化能力?是否需要云端弹性方案(如租用云GPU)?

企业决策参考:

- 中小型团队可优先采用云服务(如AWS EC2 P3实例、阿里云GN6),按需付费。

- 大型企业或科研机构建议自建集群,长期成本更低。

未来趋势:GPU生态持续扩展

随着技术迭代,GPU服务器的适用性将进一步增强:

- 软硬件协同优化:NVIDIA的Hopper架构、AMD的CDNA技术持续提升算力与能效。

- 行业渗透加深:医疗、制造、农业等领域加速引入GPU方案。

- 绿色计算兴起:液冷GPU服务器可降低40%能耗,符合“双碳”目标。

GPU服务器的“好”与“不好”取决于具体场景。

- 推荐采用:AI研发、科学计算、实时渲染等高性能需求领域。

- 谨慎投入:中小型非技术企业、低并行度业务。

技术选型时,建议咨询专业服务商,结合业务需求制定混合方案(CPU+GPU),最大化资源利用率。

引用说明

本文数据与案例参考自:

- NVIDIA官方技术白皮书(2025)

- IDC《全球人工智能基础设施市场报告》

- OpenAI GPT-3训练日志(2020)

- 阿里云《企业GPU上云指南》