GPU服务器显示错误该如何快速解决?

- 行业动态

- 2025-04-21

- 1

GPU服务器显示错误通常由硬件故障、驱动兼容性问题或系统配置不当引发,常见原因包括显卡损坏、电源不足、驱动版本不匹配、内存溢出或散热异常,建议检查硬件状态、更新驱动程序并监测系统资源使用情况进行排查修复。

GPU服务器显示错误?全面解析与高效解决方案

作为数据中心、AI训练或高性能计算的核心设备,GPU服务器一旦出现显示错误,可能导致任务中断、数据丢失甚至硬件损坏,本文从硬件、驱动、软件、环境四大维度,系统梳理GPU显示错误的排查与修复方法,并提供长期运维建议,助您快速恢复设备正常运行。

常见GPU显示错误类型及原因

黑屏/无显示输出

- 硬件故障:GPU板卡未插紧、电源供电不足、PCIe插槽接触不良。

- 信号传输问题:显示器线缆损坏、多GPU配置中主卡未指定。

- BIOS设置异常:未启用PCIe通道或未正确识别GPU。

花屏/显示异常(条纹、噪点)

- GPU显存故障:频繁运算导致显存颗粒损坏。

- 过热保护触发:散热不良或风扇停转引发GPU降频/锁死。

- 驱动兼容性问题:驱动版本与操作系统内核或CUDA工具包不匹配。

驱动报错(如“NVIDIA Driver Not Found”)

- 驱动未正确安装:安装过程中依赖项缺失(如gcc、kernel headers)。

- 内核模块加载失败:Secure Boot启用或签名冲突导致

nvidia.ko加载异常。 - 版本冲突:深度学习框架(如TensorFlow/PyTorch)要求的CUDA版本与驱动不兼容。

应用程序崩溃(CUDA Error/Core Dump)

- 显存溢出:批量数据处理超过GPU显存容量。

- 多线程竞争:并行任务未合理分配显存或流处理器资源。

- 软件缺陷:第三方库未适配特定GPU架构(如Ampere与Turing差异)。

5步诊断法:精准定位问题源头

硬件自检

- 断电后重新插拔GPU,检查金手指氧化痕迹。

- 使用万用表测量电源12V输出是否稳定(波动需<±5%)。

- 替换法测试:更换PCIe插槽或使用备用GPU验证。

驱动状态验证

# 查看GPU状态与驱动版本 nvidia-smi # 检查内核模块加载 lsmod | grep nvidia # 查看驱动日志 cat /var/log/nvidia-installer.log

系统日志分析

dmesg | grep -i nvidia:检索内核级报错。journalctl -u nvidia-persistenced:检查驱动守护进程状态。- Xorg日志路径:

/var/log/Xorg.0.log(图形界面相关错误)。

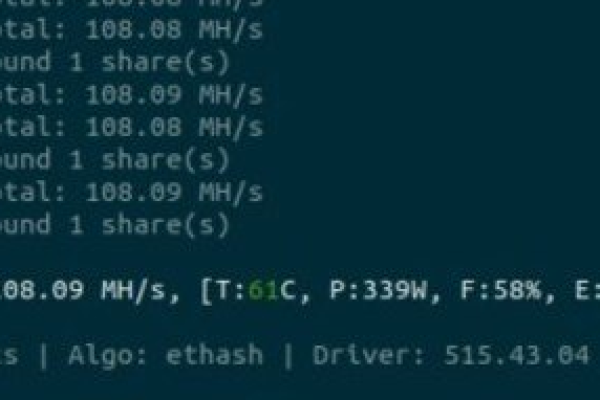

压力测试与温度监控

- 使用

stress-ng或FurMark进行满负载测试,观察温度曲线(安全阈值:NVIDIA GPU通常≤85℃)。 - 执行

nvidia-smi -q -d TEMPERATURE,POWER获取实时数据。

- 使用

环境一致性检查

- 对比

ldconfig -p | grep cuda确认CUDA库路径正确。 - 使用

conda list或pip freeze检查Python环境依赖版本。

- 对比

针对性解决方案

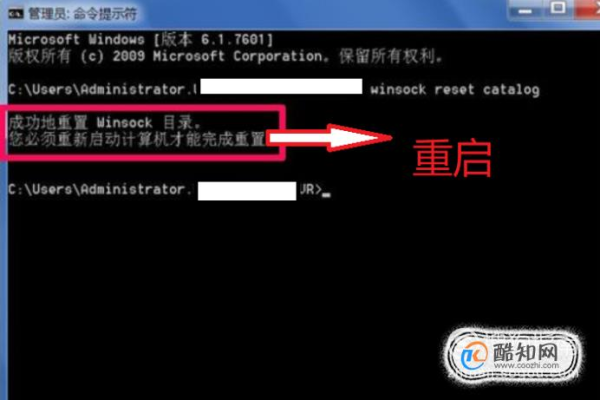

场景1:驱动安装失败

- 步骤1:卸载旧驱动

sudo apt-get purge nvidia* sudo /usr/bin/nvidia-uninstall

- 步骤2:安装依赖项

sudo apt install build-essential linux-headers-$(uname -r)

- 步骤3:禁用Nouveau驱动

echo "blacklist nouveau" | sudo tee /etc/modprobe.d/blacklist-nvidia-nouveau.conf sudo update-initramfs -u

- 步骤4:从NVIDIA官网下载指定版本驱动,按文档编译安装。

场景2:显存不足导致任务中断

- 优化策略:

- 使用

torch.cuda.empty_cache()(PyTorch)或tf.config.experimental.reset_memory_stats(TensorFlow)手动释放缓存。 - 启用混合精度训练(AMP)减少显存占用。

- 调整

batch_size或采用梯度累积(Gradient Accumulation)。

- 使用

场景3:多GPU负载不均

- 配置建议:

- 使用

CUDA_VISIBLE_DEVICES指定任务绑定的GPU。 - 通过NCCL优化多卡通信:

export NCCL_ALGO=Tree。 - 在Kubernetes中设置

nvidia.com/gpu.limit资源配额。

- 使用

预防与优化建议

- 定期维护:每季度清洁散热器灰尘,使用压缩空气清理PCIe插槽。

- 环境隔离:通过Docker或Singularity容器化部署,避免依赖冲突。

- 备份与回滚:使用Ansible编写驱动部署剧本,故障时快速回退至稳定版本。

- 监控告警:部署Prometheus+Grafana,监控GPU利用率、温度、ECC错误计数。

何时需要专业支持?

若出现以下情况,建议立即联系服务器厂商或IT团队:

- 多次蓝屏且日志提示

VIDEO_TDR_FAILURE(硬件级故障风险)。 - GPU板卡电容鼓包或PCB焦痕(电源短路征兆)。

- 数据中心级设备(如NVIDIA DGX/A100)报错,避免自行拆解影响保修。

引用说明

本文参考:

- NVIDIA官方驱动安装指南

- Linux内核模块管理文档

- TensorFlow GPU兼容性矩阵

- 《数据中心GPU运维最佳实践》(O’Reilly, 2022)