bp神经网络相关理论

- 行业动态

- 2025-04-09

- 3

BP神经网络相关理论

BP神经网络(Back Propagation Neural Network)是一种基于误差反向传播算法训练的多层前馈神经网络,广泛应用于模式识别、数据预测、分类等领域,其核心思想是通过不断调整网络权重和偏置,使输出误差最小化,以下是BP神经网络的关键理论要点:

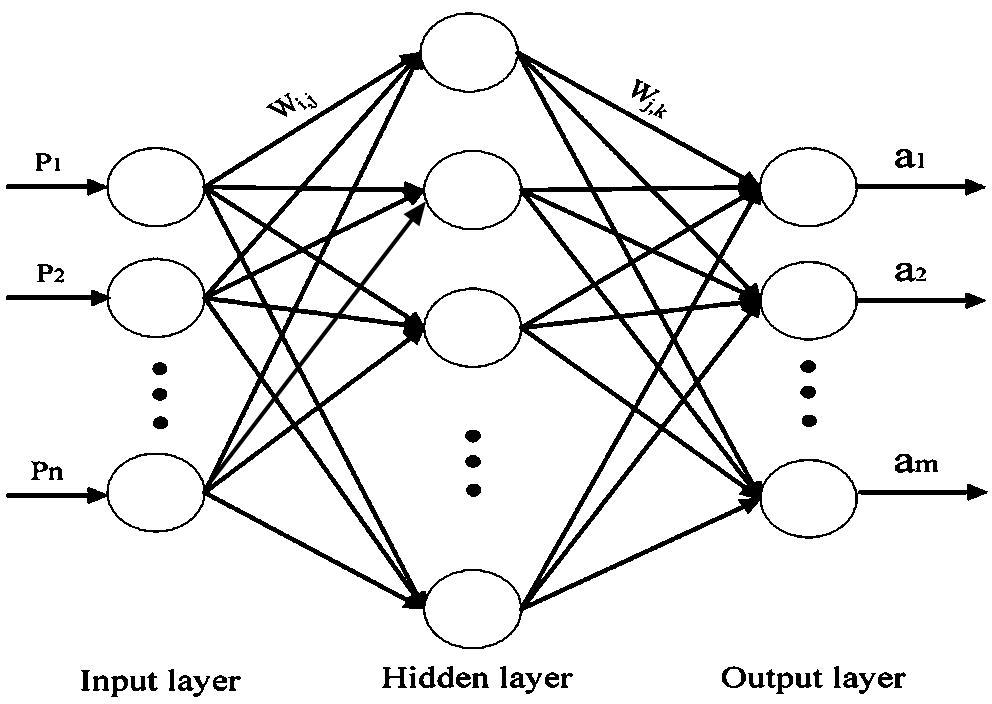

BP神经网络的基本结构

BP神经网络通常由三部分组成:

- 输入层:接收外部数据,节点数等于输入特征维度。

- 隐含层:负责特征的非线性变换,层数和节点数需根据任务调整。

- 输出层:输出预测结果,节点数由输出类别或回归维度决定。

核心算法:误差反向传播

前向传播

输入数据逐层计算,每层输出通过激活函数(如Sigmoid、ReLU)传递:

[

yj = fleft(sum{i} w_{ij}x_i + bjright)

]

(w{ij})为权重,(b_j)为偏置,(f)为激活函数。误差计算

输出层误差通过损失函数(如均方误差、交叉熵)衡量:

[

E = frac{1}{2}sum_{k}(t_k – y_k)^2

]

(t_k)为真实值,(y_k)为预测值。反向传播

误差从输出层反向传递,逐层更新权重和偏置:

[

Delta w{ij} = -eta frac{partial E}{partial w{ij}}

]

(eta)为学习率,控制参数调整步长。

激活函数的作用

- Sigmoid:将输出压缩到(0,1),适合二分类问题,但易导致梯度消失。

- ReLU:解决梯度消失问题,计算高效,但可能出现神经元“死亡”。

- Softmax:多分类任务中,将输出转化为概率分布。

训练优化策略

- 学习率调整

动态学习率(如Adam优化器)可加速收敛并避免震荡。 - 正则化

L1/L2正则化防止过拟合,Dropout随机屏蔽神经元增强泛化能力。 - 批量训练

小批量梯度下降(Mini-batch)平衡计算效率与稳定性。

应用场景与局限性

- 应用:

- 金融预测(股票价格、信用评分)

- 图像识别(手写数字分类)

- 自然语言处理(文本情感分析)

- 局限性:

- 需大量标注数据

- 训练时间长,易陷入局部最优

- 黑箱特性导致可解释性差

引用说明

本文部分理论参考自《神经网络与深度学习》(Michael Nielsen)及Stanford CS231n课程资料,具体公式推导可查阅Bishop, C. M. (2006). Pattern Recognition and Machine Learning。