从零实现分布式存储

- 行业动态

- 2025-04-10

- 1

分布式存储是解决海量数据管理、高并发访问和容灾备份的核心技术,从零构建一套分布式存储系统,需要综合网络通信、数据分片、一致性协议、冗余机制等知识,本文以技术视角拆解实现路径,结合实际代码逻辑,为开发者提供可落地的参考方案。

核心架构设计

分布式存储系统的核心目标是高可用和可扩展性,典型架构分为三层:

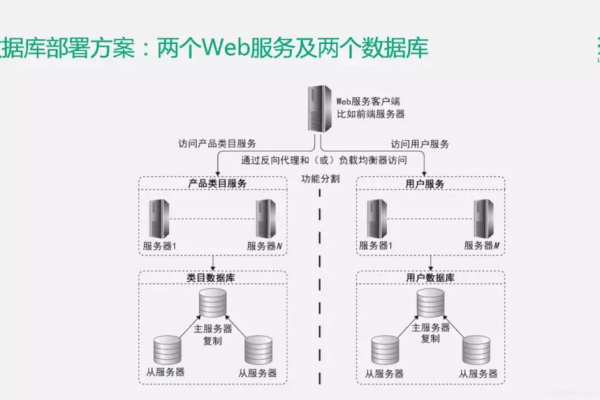

- 接入层:负责处理客户端请求(如HTTP或RPC协议),实现负载均衡与路由分发。

- 存储层:由多个节点(Node)组成,通过分片(Sharding)将数据分散存储,支持横向扩容。

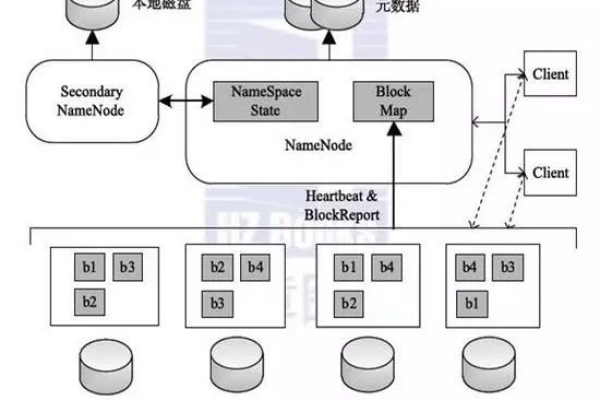

- 协调层:维护元数据(Metadata),管理节点状态,通常基于ZooKeeper或ETCD实现。

技术选型示例:

- 开发语言:Golang(高并发支持)

- 通信协议:gRPC(高性能RPC框架)

- 数据分片:一致性哈希(Consistent Hashing)

- 冗余策略:Reed-Solomon纠删码(节省存储空间)

数据分片与路由

分片策略:

- 范围分片(Range-based):按Key的字典序划分区间(如MySQL分库分表)。

- 哈希分片(Hash-based):对Key哈希后取模,确保均匀分布。

// 一致性哈希实现示例(Golang)

type ConsistentHash struct {

nodes []string

hashRing map[uint32]string

replicas int // 虚拟节点数

}

func (ch *ConsistentHash) AddNode(node string) {

for i := 0; i < ch.replicas; i++ {

virtualKey := fmt.Sprintf("%s#%d", node, i)

hash := crc32.ChecksumIEEE([]byte(virtualKey))

ch.hashRing[hash] = node

}

}

数据一致性协议

分布式系统的最大挑战是网络分区和节点故障,常用方案:

- 强一致性:Raft/Paxos协议(如ETCD),确保所有节点数据同步写入。

- 最终一致性:通过版本号(Vector Clock)或CRDT(无冲突数据类型)解决冲突。

Raft协议关键步骤:

- Leader选举:节点通过心跳机制竞选Leader。

- 日志复制:Leader将操作日志广播给Follower节点。

- 提交确认:超半数节点ACK后提交日志。

冗余与数据恢复

- 副本机制(Replication):同一数据块存储多份(如HDFS默认3副本)。

- 纠删码(Erasure Coding):将数据拆分为k个分块,生成m个校验块,总存储空间降低至(k+m)/k。

数据恢复流程:

- 检测失效节点(心跳超时或健康检查失败)。

- 从其他节点读取冗余数据。

- 重建数据并迁移到新节点。

存储引擎实现

本地存储引擎直接影响性能,需平衡读写速度与持久化:

- LSM-Tree(Log-Structured Merge Tree):写优化,适用于高频写入场景(如Cassandra)。

- B+Tree:读优化,适合事务型系统(如MySQL)。

// LSM-Tree写入流程伪代码

func (s *Storage) Write(key, value []byte) {

// 1. 写入WAL日志(防止崩溃丢失数据)

s.wal.Append(key, value)

// 2. 写入内存MemTable

s.memTable.Put(key, value)

// 3. MemTable写满后转为Immutable,异步刷盘

if s.memTable.Size() > threshold {

s.FlushToDisk()

}

}

元数据管理

元数据包括文件目录、分片映射、节点状态等,需确保高效查询与强一致性:

- 集中式存储:使用关系型数据库(如MySQL)或嵌入式KV存储(LevelDB)。

- 去中心化存储:通过Gossip协议同步元数据(如Cassandra)。

容灾与运维

- 多机房部署:数据跨地域冗余,避免单点故障。

- 灰度发布:新版本先在小范围节点测试。

- 监控指标:节点CPU/内存、网络延迟、分片均衡率。

安全性设计

- 传输加密:TLS协议保护节点间通信。

- 权限控制:RBAC(基于角色的访问控制)。

- 数据加密:AES算法加密落盘数据。

挑战与优化方向

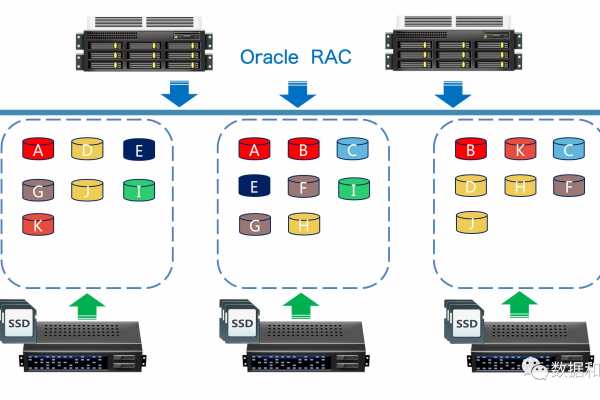

- 热点问题:动态分片迁移(如TiDB的Region Split)。

- 跨集群同步:基于Binlog或CDC(Change Data Capture)。

- 成本优化:冷热数据分层存储(SSD+HDD混合架构)。

实现分布式存储需权衡一致性、可用性和分区容忍性(CAP定理),关键在于选择合适的协议与架构,并通过自动化运维降低风险,开源项目如MinIO、Ceph的核心代码可提供进一步参考。

引用说明

- Google File System (GFS) 论文:https://research.google/pubs/pub51/

- Raft一致性算法:https://raft.github.io/

- Apache Cassandra 架构:https://cassandra.apache.org/

- Reed-Solomon Codes:https://web.mit.edu/6.02/www/s2012/handouts/12.pdf