服务器与存储服务器如何高效连接?快速上手步骤全解析

- 行业动态

- 2025-04-20

- 3

在当今数字化时代,服务器与存储服务器的连接是企业IT架构的核心环节,无论是搭建本地数据中心还是构建混合云环境,高效、安全的连接方式直接影响数据存取速度和系统稳定性,以下从技术原理、实践方案到注意事项,系统阐述二者的连接方法。

物理层面的连接方式

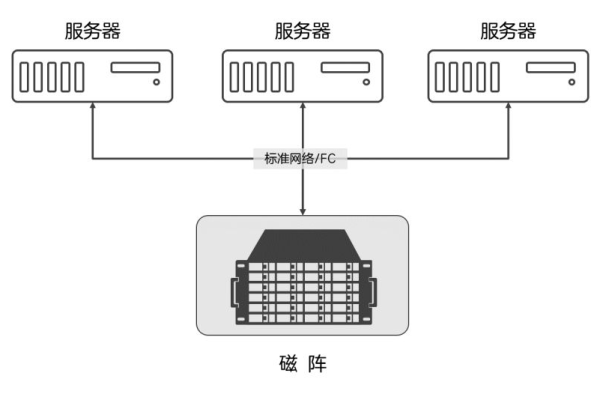

直连模式(DAS)

通过SAS(Serial Attached SCSI)或SATA线缆直接连接服务器与存储设备,每台服务器独占存储资源,适用于小型部署场景。

优势:零网络延迟,部署简单。

局限:扩展性差,存储资源无法共享。光纤通道网络(SAN)

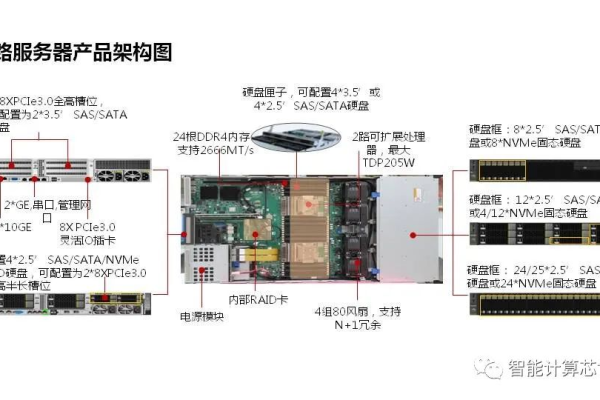

采用专用光纤交换机搭建独立网络,服务器通过HBA卡(Host Bus Adapter)接入,支持FC(Fibre Channel)协议,提供8Gbps至32Gbps传输速率。

实施要点:- 配置Zoning划分访问权限

- 启用多路径IO(MPIO)实现链路冗余

- 使用LUN Masking隔离逻辑单元

IP网络连接(NAS/SAN over IP)

利用标准以太网传输存储数据,包含两种主流方案:- iSCSI SAN:通过TCP/IP封装SCSI指令,支持万兆网络

- NAS:基于NFS/SMB协议实现文件级共享

典型配置示例:存储服务器创建iSCSI Target → 服务器端配置Initiator → 映射虚拟磁盘

软件层配置要点

存储协议选择

| 协议类型 | 适用场景 | 性能对比 |

|—|—|—|

| Fibre Channel | 高IOPS数据库 | 延迟<1ms |

| iSCSI | 虚拟化集群 | 延迟2-5ms |

| NFS v4.1 | 文件共享服务 | 支持并行访问 |

多路径管理策略

在Linux环境中安装multipathd工具,配置/etc/multipath.conf实现:- 自动故障切换(Failover)

- 负载均衡(Round-Robin)

- 路径优先级分级

安全加固措施

- CHAP双向认证(iSCSI环境)

- 启用存储端加密(AES-256)

- 定期更新HBA卡固件

高可用架构设计

双控制器存储部署

主流存储设备如Dell PowerStore、HPE Nimble均采用Active-Active控制器,通过交叉连接确保单点故障时自动接管。网络冗余设计

graph LR A[服务器] -->|Port1| B(交换机A) A -->|Port2| C(交换机B) B --> D[存储控制器A] C --> E[存储控制器B]

性能优化技巧

- 启用Jumbo Frame(MTU 9000)降低协议开销

- 分离存储流量与业务网络

- 使用NVMe over Fabrics提升SSD阵列性能

混合云连接方案

云网关设备

部署AWS Storage Gateway或Azure StorSimple,实现本地存储与云存储的无缝分层。软件定义存储

采用Ceph、GlusterFS等分布式存储系统,构建跨数据中心的统一存储池。

实施验证与监控

完成连接后必须执行:

- 连通性测试

ping <存储IP> iscsiadm -m session -P 3 # 查看iSCSI会话状态

- 性能基准测试

使用fio工具模拟真实负载:fio --name=randread --ioengine=libaio --rw=randread --bs=4k --numjobs=16 --size=10G --runtime=60 --time_based

- 持续监控指标

- 存储响应时间(<20ms为优)

- IOPS波动范围

- 网络丢包率(应接近0%)

关键注意事项

- 不同厂商设备的兼容性需提前验证

- 存储网络建议采用物理隔离或VLAN划分

- 定期进行灾难恢复演练

通过以上技术方案,企业可根据业务规模、性能需求和预算,选择最合适的连接方式,实际部署时建议遵循《SNIA(全球网络存储工业协会)架构标准》,并参考存储厂商的《最佳实践指南》进行细节调整。

引用说明:本文技术参数参考自EMC《SAN部署白皮书》、RFC 7143(iSCSI协议规范)及Intel《存储性能优化手册》。