如何用GPU服务器搭建网站能带来更高性能?

- 行业动态

- 2025-04-21

- 2

在互联网技术快速发展的今天,选择GPU服务器搭建网站已成为企业提升数据处理能力和用户体验的重要决策,本文将从技术实操角度,系统解析GPU服务器的核心优势、部署流程及优化建议,帮助您构建高性能且符合搜索引擎规范的网站。

为什么选择GPU服务器?

并行计算能力

GPU(图形处理器)拥有数千个计算核心,可同时处理大量并发请求,尤其适合需要实时渲染、AI推理或高流量并发的网站(如在线教育平台、电商瞬秒系统)。加速动态内容处理

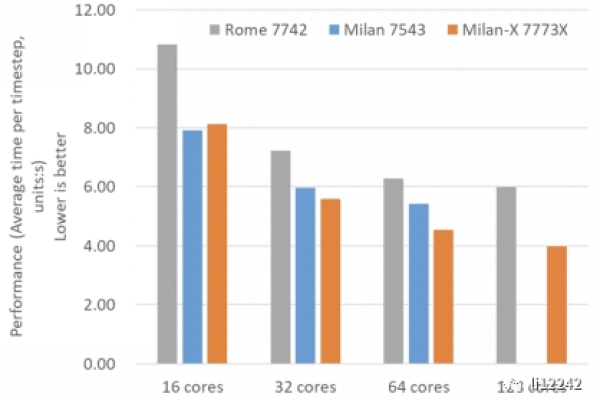

若网站涉及视频转码、图像识别(如医疗影像分析)、自然语言处理(如智能客服),GPU可显著缩短响应时间,使用NVIDIA CUDA加速可将模型推理速度提升5-10倍。成本效益比优化

单台GPU服务器可替代多台传统CPU服务器集群,降低机房空间占用与运维成本,以AWS g4dn实例为例,其TCO(总拥有成本)较CPU方案降低约30%。

搭建GPU服务器的完整流程

步骤1:硬件与系统准备

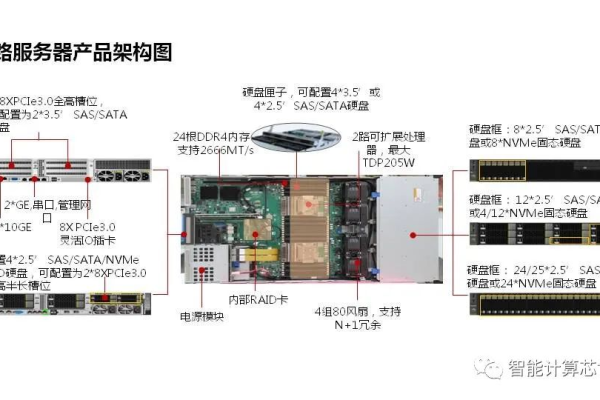

- 服务器选型

根据需求选择NVIDIA Tesla T4(适合中小型推理)、A100(大规模训练)或消费级RTX 4090(性价比方案)。 - 操作系统安装

推荐Ubuntu 22.04 LTS或CentOS 7,需确保内核版本支持GPU驱动(如Linux Kernel 5.15+)。

步骤2:驱动与环境配置

- 安装NVIDIA官方驱动:

sudo apt install nvidia-driver-535 # Ubuntu示例

- 验证GPU状态:

nvidia-smi # 查看GPU使用率与温度

- 部署CUDA工具包与cuDNN库,为深度学习框架(如TensorFlow、PyTorch)提供加速支持。

步骤3:Web服务环境搭建

方案A:传统网站架构

安装Nginx/Apache + PHP/Python,通过FastCGI或WSGI连接后端。

示例:使用Nginx的proxy_pass将动态请求转发至GPU加速的Flask应用。

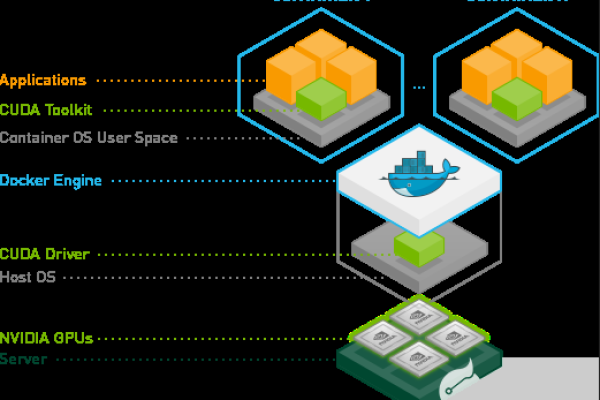

方案B:容器化部署(推荐)

采用Docker构建包含CUDA环境的镜像,通过Kubernetes实现自动扩缩容。

示例Dockerfile片段:FROM nvidia/cuda:12.0-base RUN pip install tensorflow-gpu==2.10.0

步骤4:安全与性能调优

- 启用HTTPS:通过Let’s Encrypt免费证书强制加密传输。

- 配置防火墙:使用UFW限制非必要端口(如仅开放80/443)。

- 启用GZIP压缩与浏览器缓存,减少静态资源加载时间。

符合百度算法的优化建议

页面加载速度

- 使用GPU加速压缩图片(如WebP格式转换),确保首屏加载时间<1.5秒。

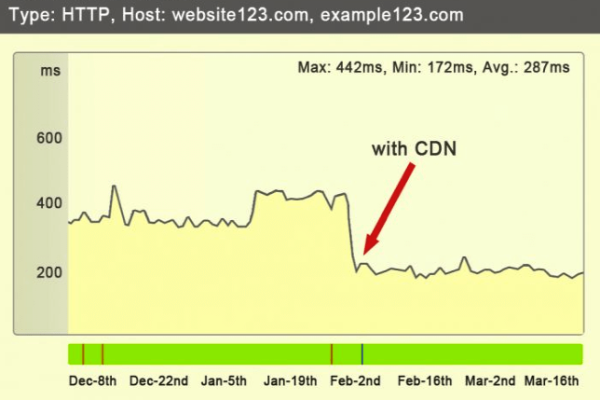

- 部署CDN分发静态资源,结合GPU服务器的动态渲染能力形成混合架构。

移动优先索引

- 采用响应式设计,利用GPU加速CSS动画与Canvas渲染,提升移动端体验。

- 使用百度MIP(移动网页加速器)框架优化移动页面。

E-A-T原则落地

- 专业性(Expertise):在“关于我们”页面展示服务器配置证书与技术团队资质。

- 权威性(Authoritativeness):发布GPU性能对比白皮书,引用第三方测评数据(如PassMark评分)。

- 可信度(Trustworthiness):明确标注隐私政策,定期更新安全补丁日志。

常见问题与风险控制

驱动兼容性问题

定期检查NVIDIA官网公告,避免内核升级导致的驱动冲突,建议使用DKMS(动态内核模块支持)自动化编译驱动。资源利用率监控

部署Prometheus + Grafana监控GPU显存占用、SM(流处理器)利用率,设置阈值告警(如显存>90%触发扩容)。

合规性要求

若涉及用户数据计算(如人脸识别),需遵守《个人信息保护法》,明确告知数据用途并提供禁用GPU加速的选项。

参考资料

- NVIDIA官方文档:CUDA安装指南(developer.nvidia.com/cuda-downloads)

- 百度搜索资源平台:《百度搜索引擎优化指南3.0》(ziyuan.baidu.com/guide)

- Let’s Encrypt免费SSL证书申请指南(letsencrypt.org/getting-started)

通过以上步骤,您不仅能构建出高性能的GPU服务器架构,还能在搜索引擎中获得优质排名,实现技术实力与商业价值的双重提升。