Hadoop怎样实现GIS数据的高效存储

- 行业动态

- 2025-04-20

- 2

GIS数据在Hadoop中主要通过分布式文件系统(HDFS)存储,支持Shapefile、GeoTIFF等格式,结合HBase或对象存储管理矢量/栅格数据,利用空间索引和分区策略优化查询效率,并通过MapReduce/Spark进行大规模空间分析,实现海量地理数据的高效存储与处理。

GIS数据在Hadoop中的存储方法与实践

随着地理信息系统(GIS)数据量的快速增长,传统存储方式面临容量和效率的瓶颈,Hadoop作为分布式存储与计算的代表框架,为海量GIS数据的存储和高效处理提供了新的解决方案,以下是GIS数据在Hadoop中的存储原理、技术实现及优化策略的详细解析。

GIS数据的特点与存储挑战

GIS数据通常包括矢量数据(点、线、面)、栅格数据(遥感影像、DEM)、属性数据以及时空数据,具有以下特征:

- 体量大:高分辨率遥感影像或全球覆盖的地理数据可达TB甚至PB级。

- 结构复杂:需同时存储空间坐标、属性信息和元数据。

- 高频更新:如实时交通轨迹或气象数据需支持动态写入。

传统关系型数据库难以满足此类需求,而Hadoop凭借分布式存储、横向扩展和高吞吐量的特性成为理想选择。

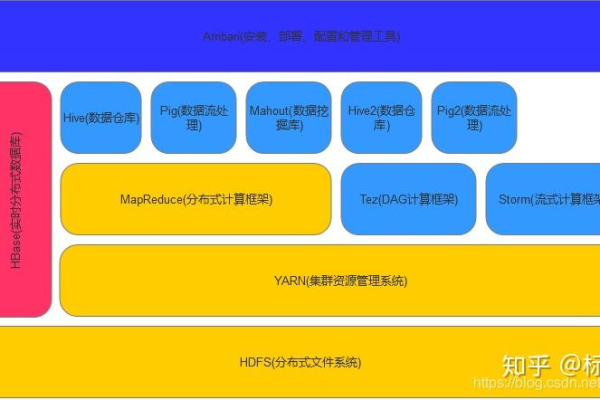

Hadoop存储GIS的核心机制

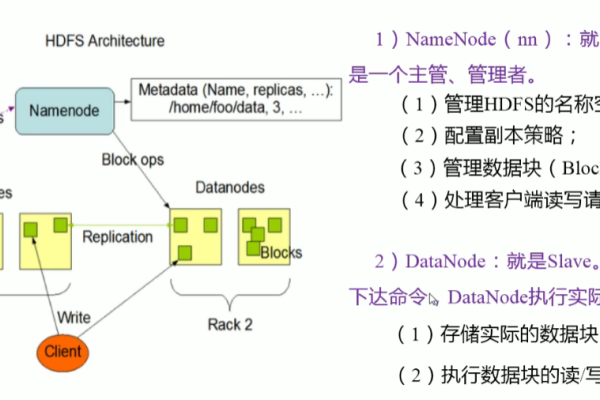

基于HDFS的分布式存储

Hadoop分布式文件系统(HDFS)将GIS数据切割为固定大小的数据块(默认128MB/256MB),分布式存储在集群节点中。

- 矢量数据:可转换为序列化格式(如GeoJSON、Shapefile的二进制形式)存储。

- 栅格数据:直接以原始二进制文件(如GeoTIFF)形式分块存储,配合空间索引提升查询效率。

优势:高容错性、支持超大文件、成本低。

结构化存储:HBase与空间索引

对于需要快速查询的GIS属性数据,可结合HBase(Hadoop的NoSQL数据库)存储,并通过空间索引技术(如Geohash、R树)优化检索效率。

- 示例:将经纬度坐标编码为Geohash字符串,作为HBase的RowKey,实现区域查询的快速定位。

数据格式优化

- 列式存储:使用Parquet或ORC格式存储属性数据,减少I/O开销。

- 压缩技术:采用LZO、Snappy压缩栅格数据,节省存储空间。

GIS数据存储的最佳实践

数据分块与并行化

- 将大型栅格数据按规则网格分块,每块独立存储于HDFS,便于MapReduce或Spark并行处理。

- 矢量数据可按空间范围(如行政区划)分区,减少跨节点数据传输。

元数据管理

- 使用Hive或HBase存储GIS元数据(坐标系、分辨率、时间戳等),并与实际数据路径关联。

- 通过Elasticsearch建立元数据全文索引,提升检索效率。

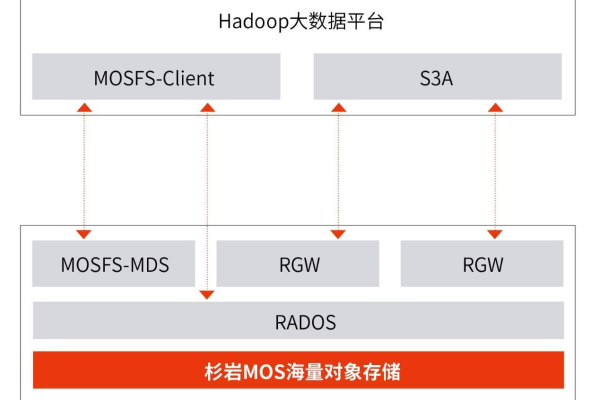

与GIS工具链集成

- GeoMesa:基于HBase和Spark的开源时空数据库,支持矢量与栅格数据的分布式存储与查询。

- GDAL:通过GDAL的HDFS驱动插件,直接读写HDFS中的栅格数据。

- ESRI GeoAnalytics Server:商业解决方案,提供Hadoop集群与ArcGIS平台的深度集成。

典型应用场景

- 智慧城市:存储路网、传感器实时数据,支持交通流量分析。

- 环境监测:管理全球气象卫星影像,进行气候变化建模。

- 物流追踪:存储历史轨迹数据,优化路径规划。

注意事项

- 数据一致性:HDFS适合“一次写入多次读取”场景,频繁更新的GIS数据需结合HBase或Kudu。

- 坐标系统一:存储前需统一为WGS84或Web Mercator等标准坐标系。

- 安全权限:通过Kerberos或Ranger管理HDFS中敏感地理数据的访问权限。

引用说明

本文技术细节参考自Apache Hadoop官方文档、ESRI技术白皮书及GDAL开源项目实践案例。