光年日志分析是什么

- 行业动态

- 2025-04-22

- 2

核心概念

光年日志分析是一种针对海量日志数据的高效处理与分析方法,结合分布式计算、存储优化和智能算法,实现对日志数据的快速挖掘、异常检测、趋势预测等目标,其核心特点是通过“光年级”数据处理速度(类比光速的高效性),解决传统日志分析中存在的延迟高、存储成本高、计算资源消耗大等问题。

技术架构

光年日志分析通常基于以下技术组件构建:

| 组件 | 功能描述 |

|————————-|—————————————————————————–|

| 数据采集层 | 使用 Fluentd、Logstash 等工具实时采集多源日志(服务器、容器、应用等)。 |

| 分布式消息队列 | 通过 Kafka、RabbitMQ 等缓冲日志流,支持高并发写入和削峰填谷。 |

| 存储层 | 采用 HDFS、对象存储(如 S3)或时序数据库(如 InfluxDB)长期保存日志数据。 |

| 计算引擎 | 基于 Spark、Flink 等分布式计算框架,实现批量或流式处理。 |

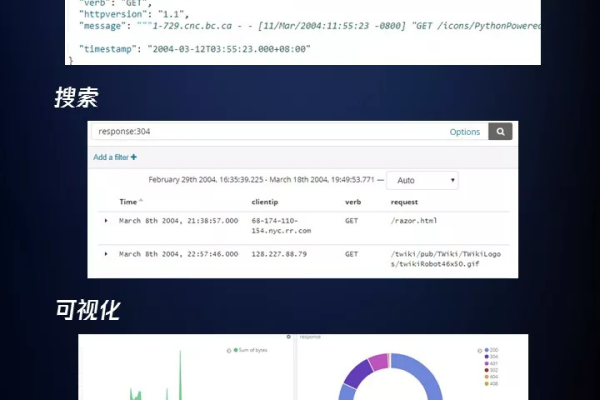

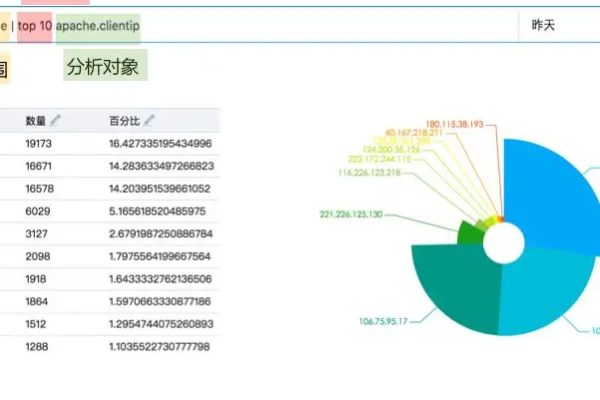

| 分析与可视化层 | 通过 Elasticsearch、Grafana 等工具实现日志检索、聚合分析和可视化展示。 |

应用场景

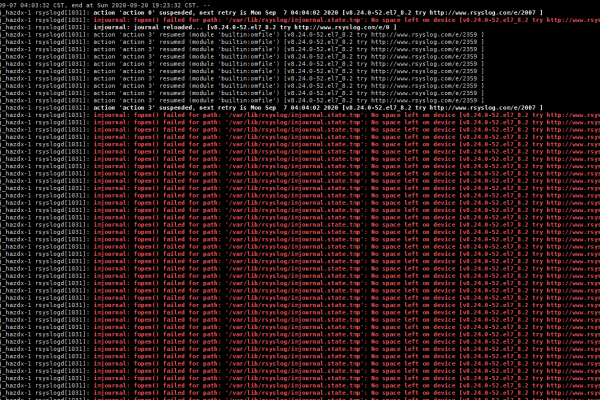

- 故障排查:快速定位系统错误、性能瓶颈(如异常请求、服务崩溃)。

- 安全审计:检测反面攻击、异常登录、数据泄露等安全事件。

- 业务分析:统计用户行为路径、转化率、功能使用频率等指标。

- 容量规划:预测未来日志量增长趋势,优化存储和计算资源分配。

优势与挑战

| 优势 | 挑战 |

|---|---|

| 处理海量数据(PB级) | 数据格式多样性导致解析复杂化 |

| 低延迟实时分析 | 硬件成本高(需集群部署) |

| 支持复杂查询与机器学习 | 数据隐私与合规性要求(如敏感信息脱敏) |

相关问题与解答

问题1:光年日志分析如何平衡实时性与准确性?

解答:

- 实时性:通过流式计算(如 Flink)和内存缓存技术,优先处理高频日志,秒级响应关键指标。

- 准确性:结合批处理(如 Spark)对历史数据进行深度清洗和关联分析,修正实时结果的偏差。

- 策略:根据业务需求分级处理,例如对监控告警采用实时分析,对报表统计采用离线计算。

问题2:光年日志分析是否适用于小规模企业?

解答:

- 适用场景:若企业日志量较大(每日 GB 级以上)且需要多维度分析(如安全、性能),可考虑轻量化方案(如 ELK Stack)。

- 局限性:小规模企业可能因技术维护成本高、硬件资源不足而难以发挥其全部价值,需评估实际需求后