GPU服务器采购需注意哪些关键因素才能节省预算?

- 行业动态

- 2025-04-21

- 3

GPU服务器采购需重点评估计算性能、显存容量及兼容性,根据AI训练、深度学习等场景选择适配的GPU型号(如NVIDIA A100/H100),需综合考虑功耗散热、扩展接口、软件生态支持及供应商服务,结合预算平衡短期需求与长期扩展性,确保高效稳定支撑业务负载。

GPU服务器采购指南:企业如何科学选择高性能计算设备

在人工智能、深度学习、大数据分析等领域的快速发展下,GPU服务器的需求激增,面对市场上琳琅满目的产品和复杂的参数配置,许多企业在采购时容易陷入误区,导致资源浪费或性能不达预期,本文从专业角度出发,结合行业经验与权威数据,为企业提供一套科学的GPU服务器采购策略。

GPU服务器的核心参数解析

GPU型号与计算能力

- NVIDIA系列:A100/H100适用于大规模训练,T4适合推理场景,RTX 6000适配图形渲染;

- AMD系列:Instinct MI250X在多卡并行场景下表现优异;

- 需根据业务类型(训练/推理/渲染)选择对应的CUDA核心数、Tensor Core性能及FP32/FP64算力。

显存容量与带宽

- 显存容量决定单卡任务处理上限(如32GB显存可支持更大批量图像训练);

- 显存带宽影响数据吞吐效率(HBM2e技术的显存带宽可达3TB/s)。

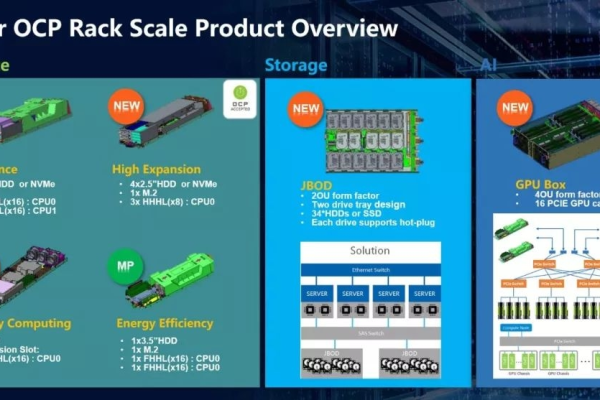

服务器扩展性与兼容性

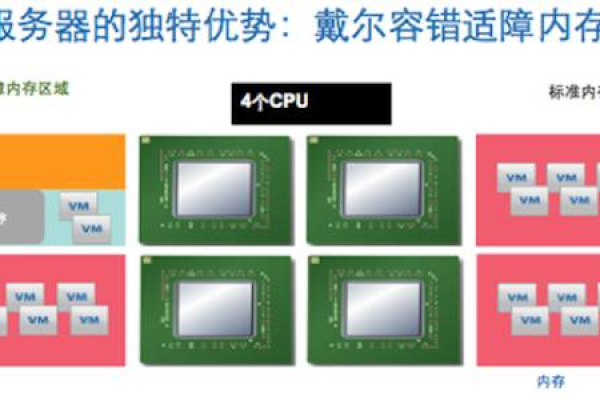

- 单机支持GPU数量(4卡/8卡/16卡架构);

- PCIe版本(PCIe 4.0/5.0的带宽差异直接影响多卡通信效率);

- 与深度学习框架(TensorFlow/PyTorch)及云平台的兼容性测试。

采购前的关键评估维度

业务场景匹配度

| 场景类型 | 推荐配置 |

|—————-|—————————-|

| 图像/视频训练 | 多颗A100 + 高内存服务器 |

| 实时推理 | T4/Tesla L4 + 低延迟网络 |

| 科学计算 | AMD MI250X + 双路CPU |能效比与TCO(总拥有成本)

- 计算每瓦特性能(参考MLPerf基准测试数据);

- 综合评估电费、散热成本及3-5年运维成本。

供应商资质与售后服务

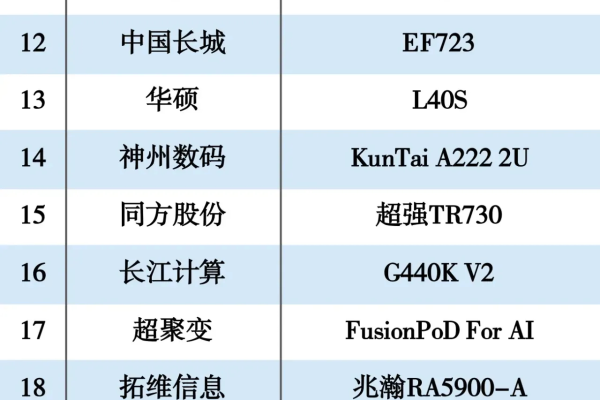

- 优先选择具备ODM/OEM能力的厂商(如戴尔PowerEdge系列、浪潮NF5488系列);

- 确认保修期(建议≥3年)、现场技术支持响应时间(≤4小时)。

行业权威推荐配置方案

中小型企业入门方案

- 机型:NVIDIA DGX Station A100(4×A100 80GB)

- 优势:预装AI软件栈,开箱即用,支持混合精度计算。

大规模训练集群方案

- 机型:Supermicro SYS-420GP-TNAR(8×H100 SXM5)

- 特性:支持NVLink 4.0全互联,3U空间实现1.6 PetaFLOPS FP8算力。

云计算服务商通用方案

- 机型:HPE ProLiant DL380 Gen10(4×RTX 6000 Ada)

- 适用:多租户虚拟化场景,支持vGPU切分管理。

避免踩坑:常见采购误区

- 误区1:“盲目追求最新型号”

(H100需配套PCIe 5.0主板,旧机房可能需额外升级成本) - 误区2:“忽视散热系统设计”

(8卡服务器需配置液冷或冗余风扇,否则可能引发降频) - 误区3:“未预留扩展空间”

(建议预留20%的PCIe插槽和电源冗余)

采购流程标准化建议

- 需求评审会:联合算法团队、运维部门明确性能指标与预算;

- POC测试:要求供应商提供样机进行实际负载压力测试;

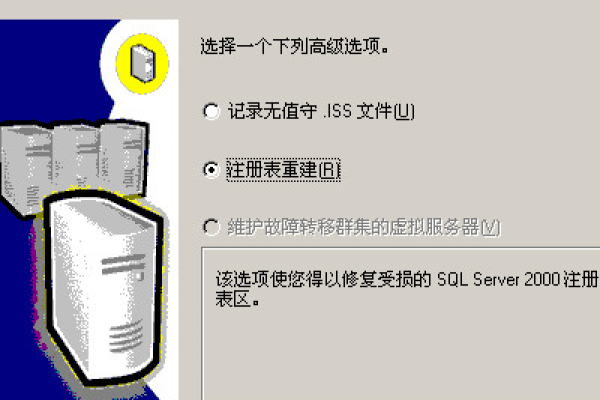

- 合同条款审核:明确性能不达标的退换机制及数据迁移支持;

- 验收标准:参考ISO/IEC 15408安全认证及Tier IV数据中心标准。

引用说明

本文技术参数参考NVIDIA官网白皮书、MLCommons公布的MLPerf测试数据及IDC《2025全球AI基础设施报告》,售后服务标准依据TIA-942数据中心评级规范。