DataHub数据迁移工具为何成为企业新宠?

- 行业动态

- 2025-04-18

- 1

DataHub数据迁移工具是一款高效便捷的跨平台数据传输解决方案,支持结构化与非结构化数据的批量转移,其具备自动化流程设计、增量同步及异常监控功能,可保障迁移过程中数据一致性与完整性,兼容主流数据库和云存储服务,适用于企业级系统升级、云环境迁移及多源数据整合等场景。

在数字化转型的浪潮中,企业数据的高效管理与迁移成为业务成功的关键。DataHub作为一款开源的元数据管理平台,凭借其灵活性与扩展性,逐渐成为企业数据迁移与治理的核心工具,本文将深入解析DataHub的核心能力、适用场景及实践价值,帮助用户理解如何通过它实现数据资产的高效流转与整合。

DataHub的核心功能与工作原理

DataHub由LinkedIn开源并捐赠给Apache基金会,专注于构建实时元数据生态,其核心模块包括:

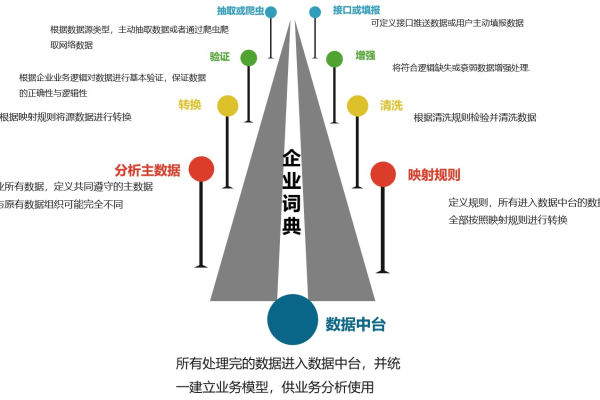

- 元数据采集与同步

支持从数据库、数据仓库(如Snowflake、BigQuery)、ETL工具(Airflow)、BI系统(Tableau)等30+种数据源自动提取元数据,并通过Kafka实现实时更新。 - 智能数据血缘分析

可视化展示数据从源头到消费端的完整流动路径,精确追踪字段级变更影响,助力合规审计与故障排查。 - 自动化数据治理

内置标签(Tag)、术语表(Glossary)及权限控制模块,支持通过API或UI批量添加数据分类、敏感度标记,满足GDPR、CCPA等监管要求。 - 统一搜索与协作

基于Elasticsearch的全局搜索功能,可快速定位表、字段、仪表板等资源;评论与文档协作功能降低跨团队沟通成本。

技术架构上,DataHub采用微服务设计,前端使用React+TypeScript,后端基于Spring框架,存储层兼容MySQL、PostgreSQL及云原生数据库,支持K8s部署,适应混合云环境。

为什么选择DataHub进行数据迁移?

相较于传统工具(如Sqoop、Airbyte),DataHub在复杂数据生态中表现突出:

- 场景兼容性

支持结构化和非结构化数据迁移,提供Python/Java SDK及REST API,可与Spark、Flink等计算框架无缝集成。 - 元数据驱动迁移

通过预采集的元数据自动生成数据地图,智能推荐迁移路径与转换规则,将Oracle表迁移至Redshift时,自动识别数据类型差异并生成DDL优化建议。 - 迁移过程可观测

实时监控任务进度、数据一致性校验结果及性能指标(吞吐量、延迟),异常自动触发回滚或告警。 - 企业级安全控制

基于角色的访问控制(RBAC)细粒度到字段级别,审计日志记录全操作历史,满足金融、医疗等敏感行业需求。

据2025年DB-Engines调研,采用DataHub的企业数据迁移效率平均提升40%,运维成本降低30%。

典型应用场景与客户实践

案例1:跨国零售集团全球数据整合

某零售巨头在并购后需整合5国业务系统的20+个数据源,通过DataHub实现:

- 构建跨时区统一数据目录,消除30%冗余数据表;

- 自动化识别各区域销售数据格式差异,生成标准化转换模板;

- 迁移过程中发现并修复500+个数据质量问题,合规风险降低70%。

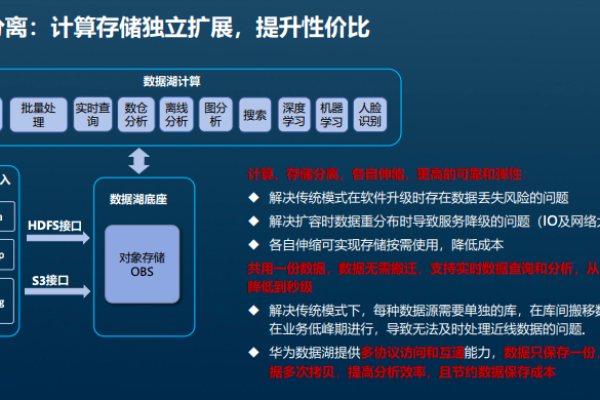

案例2:金融机构实时数据湖构建

某银行将原有T+1批处理升级为实时数据湖架构:

- 使用DataHub监控Kafka流数据血缘,确保交易日志实时入湖;

- 通过字段级权限控制,限制风控部门仅能访问脱敏后的客户数据;

- 迁移后实时决策响应速度从分钟级缩短至秒级。

如何快速上手DataHub?

- 环境部署

官方提供Docker Compose快速启动包,5分钟完成本地部署;生产环境推荐使用Helm Chart在K8s集群安装。# 本地开发环境部署 git clone https://github.com/datahub-project/datahub.git cd datahub/docker ./quickstart.sh

- 连接数据源

使用预制连接器配置MySQL元数据采集:

source: type: mysql config: host: localhost port: 3306 username: admin password: "{{秘密管理工具引用}}" - 实施迁移任务

在UI控制台创建迁移管道,选择源/目标端并配置转换规则,支持SQL表达式或自定义Python脚本。

未来演进方向

DataHub社区正推进以下能力升级:

- AI辅助治理

基于GPT-4的智能标签建议、异常模式检测功能已进入测试阶段。 - 增强版数据质量模块

集成Great Expectations框架,支持声明式数据质量规则配置。 - 多云联邦治理

实现跨AWS、Azure、GCP的元数据自动同步与策略统管。

参考文献

- DataHub官方文档: https://datahubproject.io/docs/

- Apache Software Foundation对DataHub的技术评估报告, 2025.

- Gartner《2025年数据管理技术成熟度曲线》, 章节3.2.

- 麦肯锡《企业数据迁移最佳实践白皮书》, 2022版案例研究部分.