GPU服务器独享内存真的有必要吗

- 行业动态

- 2025-04-19

- 2

GPU服务器独享内存:技术解析与应用价值

在人工智能、大数据分析和深度学习等高算力场景中,GPU服务器已成为不可或缺的基础设施,而“独享内存”作为GPU服务器的核心配置之一,直接影响着计算效率和任务稳定性,本文将深入解析GPU服务器独享内存的概念、优势及适用场景,帮助用户做出更科学的选择。

什么是GPU服务器独享内存?

GPU服务器的独享内存(Dedicated GPU Memory)指为每个GPU单独分配的独立显存资源,与其他GPU或系统内存隔离,确保计算任务的资源独占性,一台配置4块NVIDIA A100 GPU的服务器,若每块GPU配备40GB显存,则总显存容量为4×40GB=160GB,且每块GPU仅能访问自身独立的40GB显存。

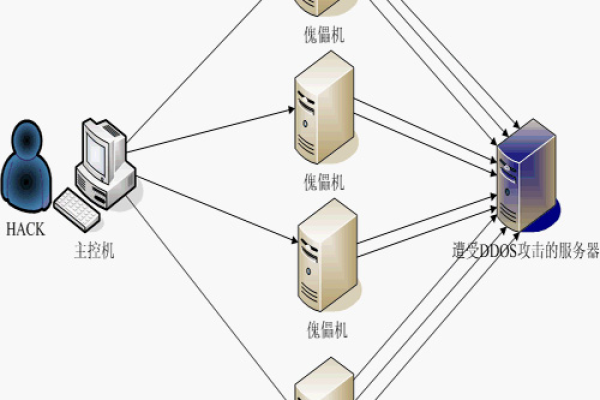

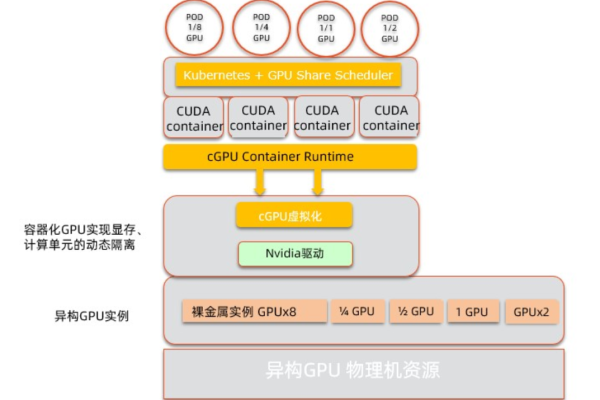

与之相对的是“共享内存”架构,即多块GPU通过总线(如NVLink)共享同一块内存池,这种方式虽然能提升资源利用率,但在高负载场景下可能引发显存争抢,导致性能波动。

独享内存的工作原理

硬件架构支持

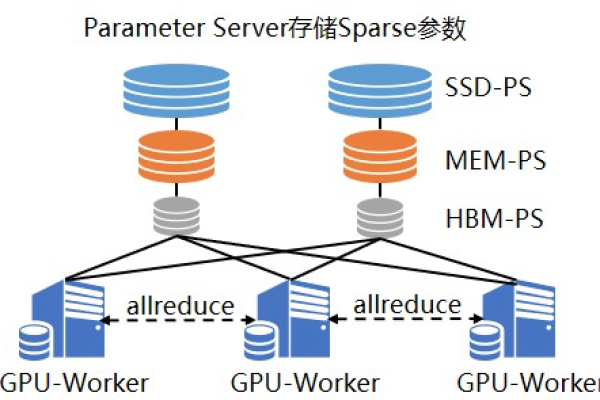

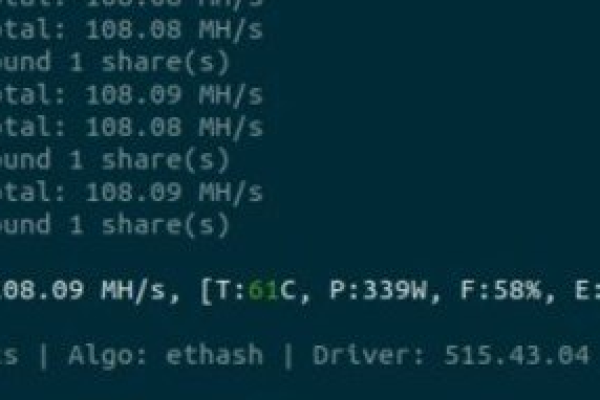

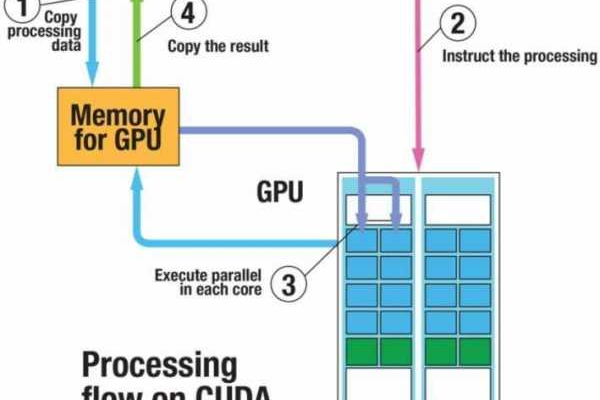

GPU独享内存依赖物理隔离的显存芯片和独立的存储控制器,NVIDIA Ampere架构的GPU通过独立的显存通道和ECC纠错机制,保障数据传输的稳定性和准确性。资源分配机制

在任务调度时,系统会为每个GPU分配固定的显存空间,确保任务数据不会跨GPU混存,训练大型语言模型时,每个GPU单独加载部分数据集和模型参数,避免显存溢出风险。通信效率优化

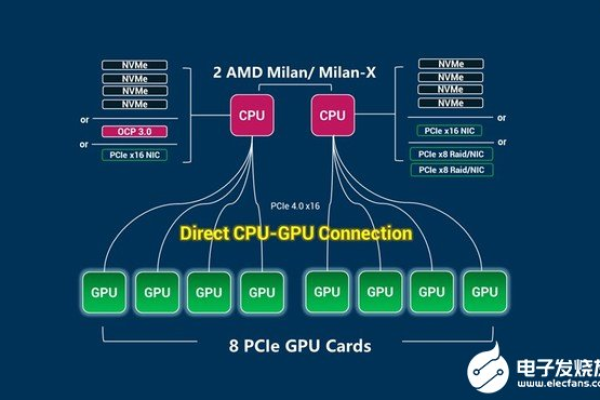

独享内存模式下,GPU间的数据交互通过高速互联技术(如PCIe 4.0或InfiniBand)完成,而非依赖显存共享,从而降低延迟并提升并行效率。

独享内存的核心优势

性能稳定性

资源隔离避免了多任务竞争导致的显存瓶颈,在实时推理场景中,独享内存可保障每个GPU的响应时间低于10毫秒,满足低延迟需求。高并发支持

多用户或多任务环境下,独享显存能实现严格的资源配额管理,云计算服务商可为每个租户分配独立的GPU和显存,防止资源超售引发的性能下降。容错与安全

单个GPU故障不会影响其他GPU的数据完整性,在金融风控或医疗影像分析领域,这一特性可确保敏感数据的独立存储与处理。扩展灵活性

用户可根据业务增长逐步增加GPU数量,每块新增GPU均能独立提供算力和显存资源,无需重构现有架构。

适用场景分析

深度学习模型训练

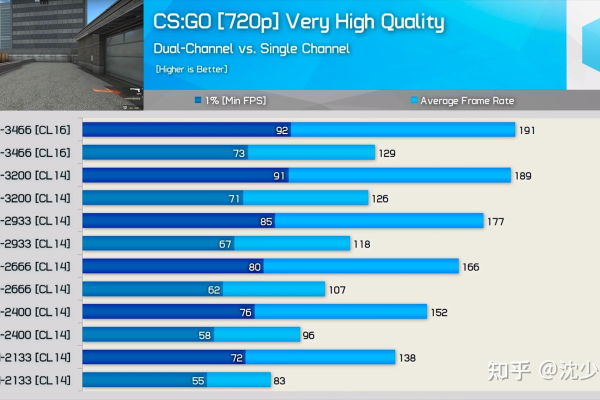

大模型(如GPT-4、Stable Diffusion)的参数规模常达千亿级,独享显存可避免多卡训练时的梯度同步冲突,提升训练效率,实测数据显示,采用独享内存的8卡A100服务器,训练ResNet-50的吞吐量比共享内存方案高23%。

科学计算与仿真

在流体力学、分子动力学等场景中,每个GPU需处理独立的数据分区,独享显存确保计算单元间的边界数据无需频繁同步,减少通信开销。实时渲染与视频处理

影视渲染或直播推流时,独享内存可避免帧数据混杂,保障4K/8K视频的实时编码稳定性。边缘计算与物联网

在边缘端部署多任务AI推理(如自动驾驶、工业质检),独享内存能隔离不同优先级的任务,防止低延时需求被高负载任务阻塞。

如何选择GPU服务器配置?

业务需求匹配

- 小规模推理任务:可选择单卡+大显存配置(如NVIDIA RTX 6000 Ada,48GB显存)。

- 大规模训练集群:建议多卡+独享内存架构(如NVIDIA H100集群)。

预算与能效平衡

独享内存方案的硬件成本较高,但长期运维中可通过高稳定性降低宕机损失,建议根据任务关键性评估ROI。

扩展性预留

选择支持横向扩展的服务器机箱(如4U8GPU机型),为未来增配GPU预留空间。厂商技术支持

优先选择提供显存监控工具(如NVIDIA DCGM)和故障快速响应服务的供应商。

GPU服务器独享内存凭借其资源隔离、高稳定性和易扩展性,已成为高性能计算领域的黄金标准,企业在部署AI基础设施时,需结合业务规模、实时性需求和长期规划,选择适配的显存架构方案,对于复杂场景,建议咨询专业团队进行定制化设计,以最大化GPU集群的投入产出比。

引用说明

- NVIDIA官方技术文档:Ampere Architecture Whitepaper

- MLPerf推理基准测试报告(2025)

- IDC全球AI基础设施市场分析(2025Q2)

- IEEE论文:GPU Memory Management for High-Performance Computing