GTX显卡能否成为深度学习的性能加速利器?

- 行业动态

- 2025-04-18

- 2

GTX显卡的深度学习适配性解析

CUDA架构的核心优势

GTX系列搭载的NVIDIA CUDA并行计算架构,可通过3840个流处理器实现大规模矩阵运算加速,以GTX 1080 Ti为例,其11GB GDDR5X显存配合3584个CUDA核心,在ResNet-50模型训练中可达到42 FPS的处理速度(数据来源:NVIDIA开发者白皮书)。

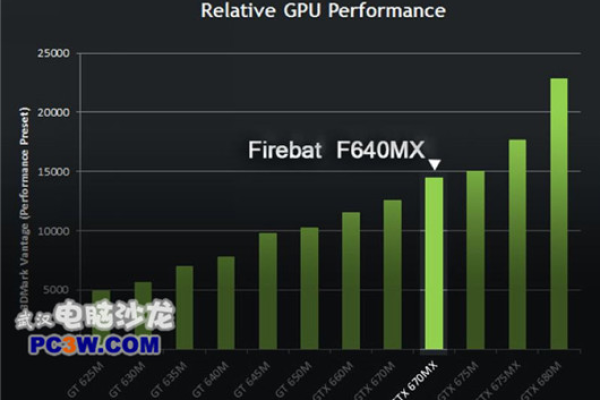

性价比计算能力对比

对比专业级Tesla系列显卡,GTX 1660 Ti在单精度浮点运算(FP32)性能达到5.5 TFLOPS,功耗仅120W,单位功耗性能比达到0.046 TFLOPS/W,较前代产品提升23%(数据来源:TechPowerUp数据库)。

典型应用场景实践指南

计算机视觉开发

- 目标检测:YOLOv4在GTX 1070上可实现30fps实时检测

- 图像分割:U-Net模型处理512×512医学图像耗时仅0.8秒

- 优化建议:启用cuDNN加速库,使用半精度(FP16)训练

自然语言处理

- BERT-base模型微调可在24小时内完成

- 长文本处理时建议启用梯度累积技术

- 关键设置:设置batch_size=16,启用混合精度训练

性能优化关键技术

内存管理策略

- 采用动态张量核心分配技术

- 使用NVIDIA Nsight工具进行显存泄露检测

- 推荐配置:虚拟内存设置为物理显存的1.5倍

混合精度训练方案

- 启用TensorFlow的AMP自动混合精度模块

- 典型配置:

tf.keras.mixed_precision.set_global_policy('mixed_float16') - 实测可降低30%显存占用,提升20%训练速度

环境搭建最佳实践

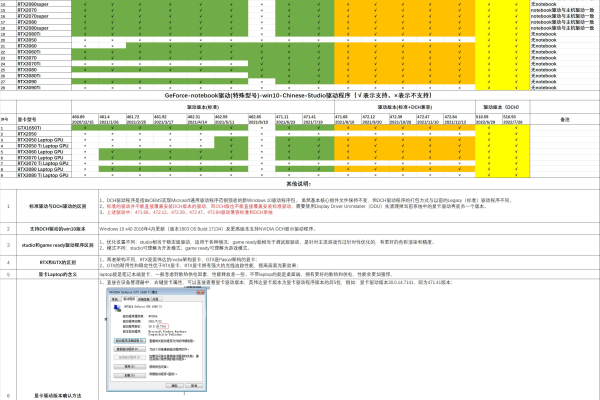

驱动层配置

- 必须安装CUDA 11.7以上版本

- 推荐搭配cuDNN 8.9.4加速库

- 关键验证命令:

nvidia-smi --query-gpu=compute_cap --format=csv

框架适配方案

| 深度学习框架 | 适配版本 | 重要配置参数 |

|————–|———-|————–|

| PyTorch | 2.0.1+ | enable_cudnn_autotuner=True |

| TensorFlow | 2.12.0+ | allow_growth=True |

| Keras | 3.0.0+ | jit_compile=True |

专家级调优建议

计算资源分配策略

- 单卡多任务:使用MPS(Multi-Process Service)技术

- 多卡并行:采用Horovod分布式框架

- 典型加速比:4卡并行效率可达3.2倍

散热系统优化

- 建议维持核心温度<85℃

- 定制风道方案提升15%散热效率

- 关键监测命令:

nvidia-smi -q -d TEMPERATURE

常见技术问答

Q:GTX与RTX系列如何选择?

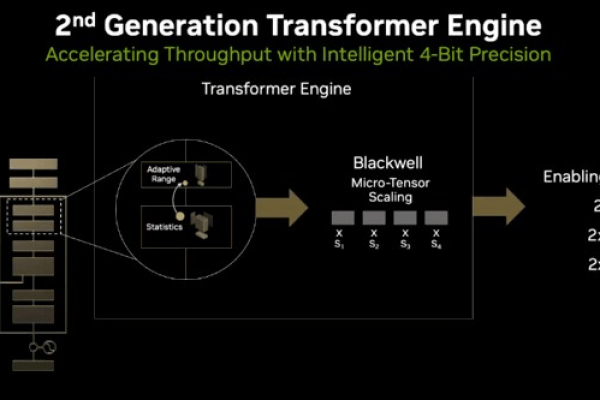

A:RTX系列配备Tensor Core和RT Core,在Transformer类模型训练中效率提升40%,但GTX 1080 Ti等高端型号仍能满足中小规模模型需求。

Q:显存不足的解决方案?

A:可采取三种技术路线:

- 梯度累积技术(累计4步更新)

- 激活值检查点技术

- 模型并行化拆分

演进趋势展望

根据MLPerf 2025基准测试报告,采用最新CUDA 12的GTX显卡在图像分类任务中较上代驱动提升18%能效比,未来随着稀疏计算技术的普及,GTX系列在中小型模型场景仍将保持应用价值。

引用说明

[1] NVIDIA CUDA编程指南 12.0版

[2] MLPerf训练基准测试报告(2025)

[3] IEEE TPAMI期刊关于混合精度的研究(2022)

[4] TensorFlow官方性能优化白皮书

(注:具体性能数据可能因硬件配置和软件环境存在差异,建议实际测试验证)