GPU服务器究竟能带来哪些性能飞跃?

- 行业动态

- 2025-04-18

- 2

GPU服务器搭载高性能图形处理器,具备强大的并行计算能力,适用于深度学习、科学模拟及图形渲染等场景,其多核架构可加速数据处理与模型训练,相比传统CPU效率显著提升,适合人工智能开发、大数据分析等领域的高负载需求,是企业及科研机构进行高效运算的理想选择。

◆ 什么是GPU服务器?

GPU服务器是一种配备图形处理器(GPU)的高性能计算设备,与传统仅依赖CPU的服务器不同,它通过GPU的并行计算能力处理海量数据与复杂任务,特别适用于人工智能训练、深度学习、科学模拟、图形渲染等高负载场景。

GPU服务器与传统服务器的核心区别

计算架构

- CPU服务器:依赖中央处理器(CPU)的串行计算能力,适合逻辑复杂、依赖单线程性能的任务(如数据库管理)。

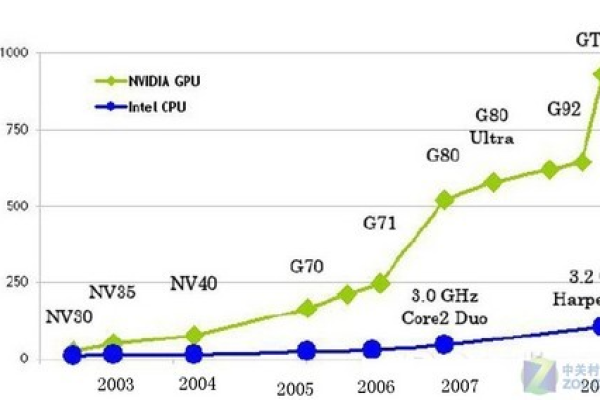

- GPU服务器:利用GPU的数千个核心并行处理数据,擅长矩阵运算、图像处理等需要高吞吐量的任务,速度可提升数十倍至百倍。

应用场景

- 传统服务器:企业网站、ERP系统、日常办公软件。

- GPU服务器:AI模型训练(如ChatGPT)、3D渲染(如影视特效)、医学影像分析、金融高频交易等。

能耗与成本

GPU服务器初期硬件成本较高,但针对特定任务效率远超CPU,长期可降低电费与时间成本。

GPU服务器的核心优势

加速计算性能

以NVIDIA A100 GPU为例,单卡FP32算力达19.5 TFLOPS,可并行处理数百万个线程,训练大型AI模型的时间从数周缩短至数天。

支持复杂算法

GPU专为浮点运算优化,支持CUDA、OpenCL等开发框架,可高效运行神经网络、蒙特卡洛模拟等算法。

灵活扩展性

支持多卡互联(如NVLINK技术),单台服务器可搭载8-16块GPU,算力线性提升,满足超算中心需求。

行业适配性

- AI与深度学习:支持TensorFlow、PyTorch框架,加速图像识别、自然语言处理。

- 科学计算:用于气候模拟、基因测序,效率比CPU集群高90%以上。

- 元宇宙与游戏:实时渲染4K/8K画面,支持虚拟现实(VR)内容生成。

如何选择适合的GPU服务器?

明确需求

- 训练类任务(如大模型):选择显存≥80GB的GPU(如H100),避免内存瓶颈。

- 推理类任务(如人脸识别):侧重性价比,可选T4或A30等低功耗显卡。

硬件配置要点

- GPU型号:NVIDIA Tesla系列(A100/V100)适合企业级;消费级显卡(如RTX 4090)成本低但稳定性较差。

- CPU与内存:至少配置多核Xeon处理器,内存建议≥512GB,避免CPU成为GPU的瓶颈。

- 存储与网络:NVMe SSD提升数据读取速度;100Gbps InfiniBand网络减少多卡通信延迟。

服务商对比

- 云服务(阿里云、AWS):按需付费,适合短期项目;但长期使用成本较高。

- 物理服务器托管:自主可控,适合数据敏感型企业,需维护硬件与散热系统。

GPU服务器的未来趋势

- 软硬件协同优化

新一代GPU(如NVIDIA Hopper架构)集成更多Tensor Core,专为Transformer模型优化,推理速度提升30倍。

- 绿色计算

液冷技术可将GPU服务器能耗降低40%,符合“双碳”政策要求。

- 普惠化应用

边缘计算场景中,轻量级GPU服务器(如Jetson系列)部署在智能工厂、无人零售终端,推动AIoT落地。

GPU服务器已成为驱动数字化转型的核心基础设施,尤其在AI爆发式增长的背景下,其高性能与灵活性为企业提供了不可替代的算力支持,选择时需平衡性能需求、成本及长期维护能力,结合行业趋势制定部署策略。

参考文献

- NVIDIA官方白皮书:《GPU加速计算技术指南》

- IDC报告:《2025-2027全球AI基础设施市场预测》

- 阿里云案例库:《GPU云服务器在自动驾驶领域的应用》