GPU云服务器如何优化您的云端计算性能与成本

- 行业动态

- 2025-04-18

- 2

什么是GPU云服务器?

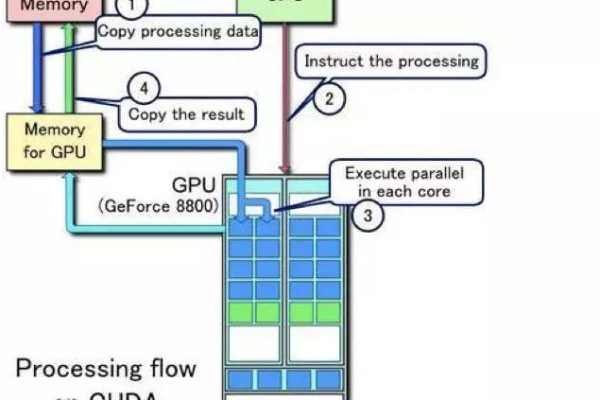

GPU云服务器是基于云计算技术,搭载图形处理器(GPU)的虚拟化计算资源,与传统的CPU服务器不同,GPU凭借其并行计算能力,特别适合处理高复杂度任务,如人工智能训练、科学模拟、图形渲染等,用户通过云服务商按需租用GPU算力,无需自行购买硬件,即可快速部署高性能计算环境。

GPU云服务器的核心优势

高性能计算能力

GPU拥有数千个计算核心,可同时处理大量数据,在深度学习、图像处理等场景中,效率比CPU提升数十倍至数百倍。案例:训练一个ResNet-50模型,使用单卡GPU可比CPU快15倍以上(数据来源:NVIDIA官方测试)。

弹性扩展与成本优化

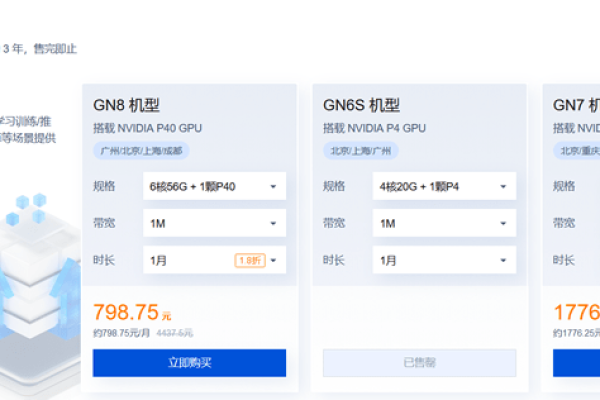

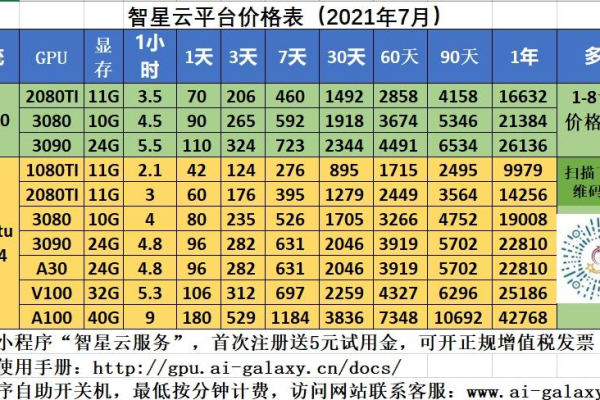

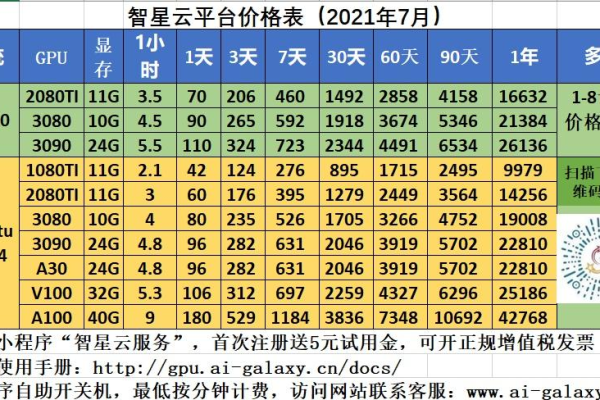

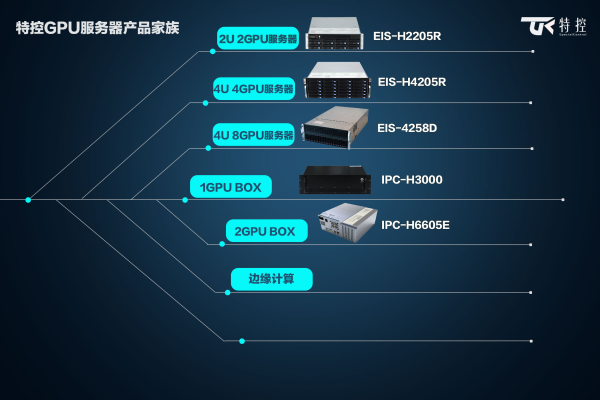

用户根据业务需求灵活选择GPU型号(如NVIDIA A100、V100、T4等)和数量,按小时或按月付费,避免硬件闲置浪费。示例:中小企业在高峰期临时扩容10台GPU实例,任务完成后立即释放,成本降低60%。

开箱即用的生态支持

主流云平台预装深度学习框架(TensorFlow、PyTorch)、CUDA工具包和行业解决方案,用户可快速启动项目,无需配置复杂环境。

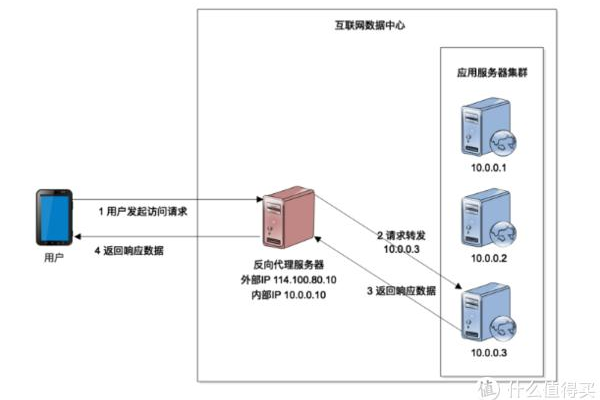

全球节点与低时延网络

通过云服务商的全球数据中心,用户可就近部署GPU资源,结合高速专有网络,保障数据传输效率。

典型应用场景

- AI模型开发与训练

支持自然语言处理(NLP)、计算机视觉(CV)等模型的分布式训练,缩短迭代周期。 - 3D渲染与影视制作

提供实时渲染能力,适用于动画制作、建筑可视化等领域。 - 科学计算与仿真

加速气象预测、基因测序、流体动力学等复杂计算任务。 - 边缘计算与推理部署

在靠近用户的位置部署轻量级GPU服务器,实现低延迟推理(如自动驾驶、实时视频分析)。

如何选择GPU云服务器?

明确需求

- 计算类型:训练需高精度(如FP32/FP64),推理可选低功耗卡(如T4)。

- 显存容量:大模型(如GPT-3)需32GB以上显存。

- 网络带宽:分布式训练需25Gbps以上互联速度。

对比主流云服务商

| 服务商 | 优势 | 典型GPU型号 |

|———-|—————————–|————————–|

| 阿里云 | 亚太区域覆盖广,性价比高 | A10、A100、V100 |

| AWS | 生态完善,支持混合云部署 | T4、A10G、A100 |

| 酷盾 | 适配国产芯片,定制化方案 | 英伟达系列、自研AI芯片 |

关注附加服务

- 数据安全:是否提供加密存储、私有网络隔离。

- 运维支持:7×24小时技术支持、自动容灾备份。

- 计费模式:抢占式实例可节省80%成本,适合弹性任务。

快速上手GPU云服务器的步骤

- 注册并登录云平台控制台

- 选择GPU实例规格与镜像

推荐使用预装深度学习框架的公有镜像(如PyTorch 2.0 + CUDA 11.7)。 - 配置网络与存储

挂载SSD云盘存放数据集,设置安全组限制访问IP。 - 通过SSH或Jupyter连接实例

- 部署代码与运行任务

# 示例:启动分布式训练 torchrun --nproc_per_node=4 train.py --batch_size=64

- 监控与优化

利用云平台监控工具查看GPU利用率,调整批处理大小或使用混合精度训练。

未来趋势:GPU云服务的创新方向

- 异构计算架构:CPU+GPU+DPU协同,提升能效比。

- Serverless GPU:按毫秒级计费,实现极致弹性。

- 绿色计算:液冷技术降低PUE值,符合碳中和目标。

常见问题解答(FAQ)

Q1:GPU云服务器适合个人开发者吗?

A:是的,按需付费模式降低门槛,个人用户可通过竞价实例低成本运行实验性项目。

Q2:如何避免GPU资源浪费?

A:使用Kubernetes集群自动扩缩容,或启用监控告警功能。

Q3:数据隐私如何保障?

A:选择通过ISO 27001认证的服务商,并启用传输加密(TLS)与静态加密(AES-256)。

Q4:与本地GPU相比,云服务的延迟是否更高?

A:对于非实时任务(如模型训练),延迟影响可忽略;实时场景可通过边缘节点优化。

引用说明

本文参考数据来源:NVIDIA官方性能白皮书、IDC《2025全球云计算市场报告》、AWS技术文档。