双机服务器如何实现存储连接的高效与稳定?

- 行业动态

- 2025-04-18

- 2

服务器双机存储连接通过共享存储架构(如SAN或双活存储)实现数据同步与高可用性,确保双机系统实时访问同一数据集,采用冗余路径、心跳检测及故障切换机制,保障业务连续性和数据一致性,适用于关键业务场景下的负载均衡与容灾需求。

在服务器双机部署中,存储连接是实现高可用性、数据冗余和业务连续性的核心环节,其设计需兼顾性能、稳定性与容灾能力,同时需匹配实际业务场景的扩展需求,以下是针对该主题的深度解析与技术建议:

双机存储连接的典型架构

直连存储(DAS)

- 原理:每台服务器直接连接独立存储设备(如本地硬盘、JBOD阵列)。

- 适用场景:小型应用、测试环境或预算有限的项目。

- 局限性:单点故障风险高,扩展性差,需依赖双机热备软件实现数据同步。

共享存储(SAN/NAS)

- SAN(存储区域网络)

- 通过光纤通道(FC)或iSCSI协议实现块级存储共享。

- 优势:低延迟、高吞吐,适合数据库、虚拟化等IO密集型业务。

- 典型方案:双机通过HBA卡连接至同一SAN存储,配合集群软件(如Windows Failover Cluster)管理资源切换。

- NAS(网络附加存储)

- 基于NFS/CIFS协议提供文件级共享存储。

- 优势:部署简单,支持跨平台访问,适合文件服务器、非结构化数据存储。

- SAN(存储区域网络)

分布式存储

- 原理:数据分散存储于多节点,通过冗余副本或纠删码保障可靠性。

- 适用场景:云原生环境、大规模数据处理(如Ceph、GlusterFS)。

- 特点:避免单点瓶颈,天然支持横向扩展,但需额外规划网络带宽与管理节点。

双机存储连接的核心技术要点

冗余链路设计

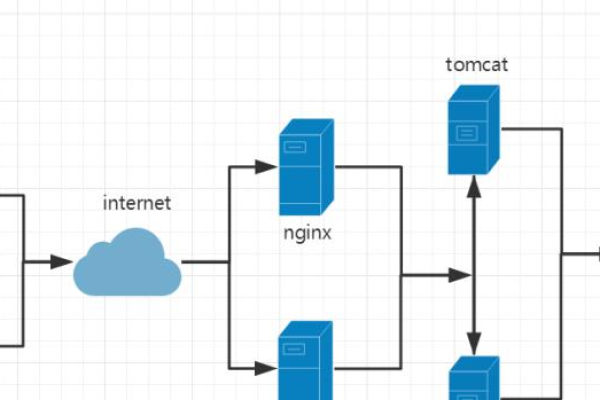

- 多路径(Multipath I/O):通过多条物理链路连接存储,自动切换故障路径,避免单链路中断导致服务不可用。

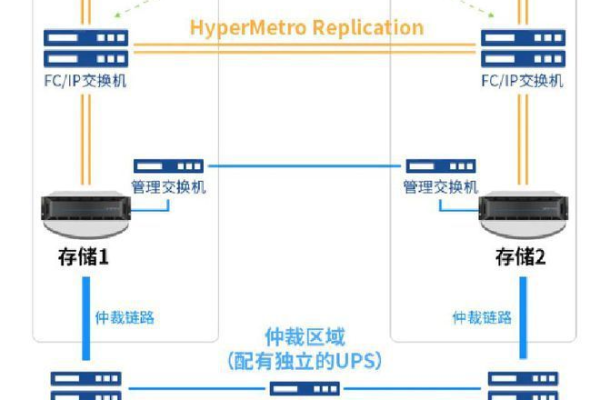

- 双活网络架构:部署双交换机和双网卡,构建无单点故障的网络环境。

数据同步机制

- 实时同步(同步复制):写入操作需同时完成主备存储确认,保证数据零丢失,但对网络延迟敏感。

- 异步复制:主存储写入后异步更新备存储,适用于跨地域容灾,但存在短暂数据不一致风险。

- 混合模式:结合同步与异步策略,平衡性能与可靠性(如优先同步关键数据,非关键数据异步处理)。

故障切换(Failover)方案

- 心跳检测机制:通过专用网络(心跳线)或共享磁盘检测节点存活状态。

- 虚拟IP(VIP)漂移:故障时自动将服务IP切换至备用节点,实现业务无感知切换。

- 存储隔离(Fencing):强制隔离故障节点,防止“脑裂”导致数据损坏。

部署与优化建议

硬件选型

- 存储介质:根据IOPS需求选择SSD或HDD;企业级存储需支持RAID 10/50/60。

- 网络带宽:SAN环境建议使用16Gb以上光纤通道,iSCSI需至少10Gb以太网。

软件配置

- 集群管理工具:如Pacemaker+Corosync(Linux)、Veritas Cluster Server(跨平台)。

- 存储快照与备份:定期备份结合CDP(持续数据保护),缩短RTO(恢复时间目标)。

性能调优

- 队列深度优化:调整HBA卡或iSCSI Initiator的队列参数,提升并发处理能力。

- 缓存策略:启用存储控制器写缓存(需配合UPS保障断电安全)。

- 协议调优:针对iSCSI启用Jumbo Frame、调整TCP窗口大小。

常见问题与解决方案

| 问题场景 | 排查方向 | 解决方案 |

|---|---|---|

| 存储切换延迟高 | 网络带宽不足、多路径配置错误 | 升级网络、检查MPIO策略 |

| 双机“脑裂”导致数据损坏 | 心跳线中断、隔离策略失效 | 配置冗余心跳链路,启用存储级隔离(SCSI Reservation) |

| 存储性能波动大 | 缓存未生效、RAID卡电池故障 | 检查缓存策略,更换RAID卡电池或启用超级电容 |

未来趋势与扩展能力

- 超融合架构(HCI):整合计算、存储与网络资源,简化双机部署复杂度。

- NVMe over Fabrics:利用RDMA技术实现超低延迟存储访问,适用于AI/ML场景。

- 云存储混合架构:本地双机集群与公有云存储联动,实现分级容灾。

参考文献与引用

- IBM Redpaper: Designing a High Availability Storage Infrastructure

- Microsoft Docs: Storage Spaces Direct in Windows Server

- SNIA(全球网络存储工业协会)技术白皮书:Shared Storage Model

- 华为《双活数据中心解决方案技术指南》