DataX数据同步为何频繁产生脏数据?

- 行业动态

- 2025-04-17

- 2

DataX数据同步过程中可能出现脏数据问题,通常由源数据异常、规则配置不当或传输错误导致,可通过配置

脏数据检查阈值、设置清洗规则及异常处理机制,结合日志监控与数据校验,减少同步过程中的数据丢失或失真,确保传输质量与一致性。

脏数据的核心定义与影响

技术定义:脏数据指不符合目标端约束规则、业务逻辑或数据结构规范的数据记录,典型表现为:

- 类型冲突:字符串写入数值型字段(如

"N/A"→INT) - 约束违反:主键重复、非空字段缺失(如订单号空缺)

- 精度溢出:金额字段超DECIMAL(16,2)存储范围

- 编码异常:GBK编码写入UTF-8字段

业务影响矩阵:

| 影响维度 | 短期表现 | 长期风险 |

|---|---|---|

| 数据一致性 | 同步任务失败 | 报表数据失真 |

| 系统稳定性 | 线程阻塞/资源耗尽 | 存储空间异常占用 |

| 决策可靠性 | 局部数据异常 | 业务决策偏差累积效应 |

DataX脏数据处理机制全景解析

预检机制

通过preCheck模块执行字段映射检测,提前拦截:

- 元数据不匹配(字段数量/类型/约束)

- 分片策略冲突

- 权限验证异常

运行时校验

采用多级校验策略:

# 模拟DataX核心校验逻辑

def validate_record(record, target_schema):

for field in target_schema:

if field.is_required and record[field.name] is None:

raise NullConstraintViolation()

if not isinstance(record[field.name], field.data_type):

raise TypeMismatchError()

if field.unique and exists_in_target(record[field.name]):

raise DuplicateKeyError()

容错策略对照表:

| 策略类型 | 处理方式 | 适用场景 |

|---|---|---|

| 中断策略 | 任务立即终止 | 关键业务数据同步 |

| 跳过策略 | 记录错误日志继续执行 | 非核心数据批处理 |

| 替换策略 | 填充默认值/占位符 | 可容忍部分缺失的统计场景 |

实战优化方案

场景案例:某电商平台订单数据同步时出现金额字段¥199.0无法写入DECIMAL(10,2)字段

分步解决方案:

- 预处理配置:

"transformer": { "type": "dx_replace", "column": "amount", "regex": "[^0-9.]", "replace": "" } - 精度控制:

CAST(ROUND(amount, 2) AS DECIMAL(10,2))

- 异常监控:

# 日志分析命令 grep "DIRTY_DATA" datax.log | awk -F'|' '{print $4}' | sort | uniq -c

高级技巧:

- 动态阈值配置:根据历史数据分布设置自适应校验规则

- 模式进化:通过Schema Registry实现字段类型动态适配

- 数据谱系追踪:使用Apache Atlas构建数据血缘关系

长效治理框架

质量度量体系:

- 脏数据率 = 异常记录数 / 总记录数 ×100%

- 建立分级预警机制(<0.1%正常 / 0.1-1%警告 / >1%熔断)

技术架构升级:

数据源 → 缓冲队列 → 清洗引擎 → 校验模块 → 目标库 ↗错误日志分析 ↘死信队列处理组织协同机制:

- 建立数据责任人(Data Steward)制度

- 制定字段级数据标准文档

- 实施变更联动通知机制

工具链推荐

- 数据质量检测:Apache Griffin

- 元数据管理:DataHub

- 自动化测试:Great Expectations

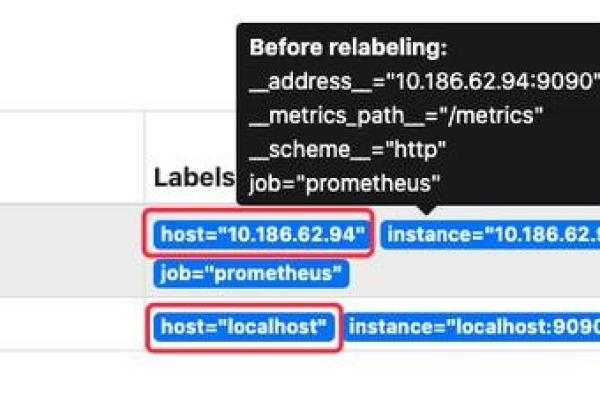

- 可视化监控:Grafana + Prometheus

引用说明

本文技术方案参考阿里云DataX官方文档(2025版)、Apache基金会数据治理白皮书及金融行业数据质量管理规范,具体配置参数请以实际环境测试结果为准。