如何通过分析网站日志提升搜索引擎爬虫抓取效率?

- 行业动态

- 2025-04-17

- 2

通过解析网站日志中的用户代理、IP地址及访问特征,可有效识别搜索引擎爬虫流量,区分正常抓取与反面扫描,帮助优化服务器负载分配、提升SEO效果并制定针对性反爬策略,为网站运维和内容优化提供数据支撑。

日志文件的价值与获取方式

网站日志文件(如Apache的access.log、Nginx的access.log)记录了所有访问服务器的请求信息,包括:

- 访问者的IP地址

- 请求时间戳

- 请求的URL路径

- HTTP状态码(如200、404、503)

- User-Agent字段(识别爬虫身份的核心依据)

获取方式:

- 通过服务器管理面板(如cPanel、宝塔)直接下载

- 使用FTP/SFTP工具连接到服务器目录(通常位于

/var/log/) - 借助日志分析工具(如GoAccess、AWStats)自动解析

识别搜索引擎爬虫的特征

搜索引擎爬虫的User-Agent具有唯一标识符,常见类型包括:

| 爬虫名称 | User-Agent特征 | 所属搜索引擎 |

|---|---|---|

| Baiduspider | Baiduspider+(+http://www.baidu.com) | 百度 |

| Googlebot | Googlebot/2.1 | 谷歌 |

| Bingbot | bingbot/2.0 | 必应 |

| YandexBot | YandexBot/3.0 | Yandex |

筛选方法:

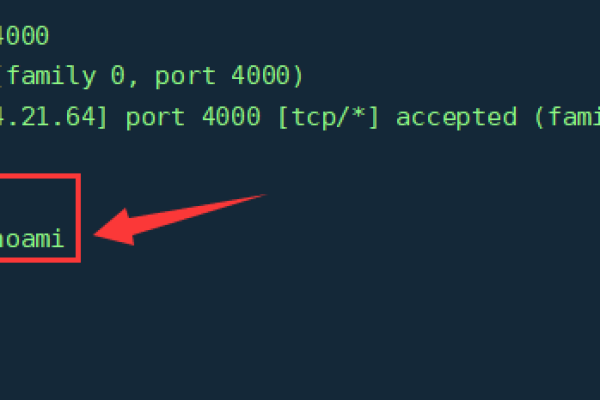

- 使用

grep命令过滤日志中的爬虫记录:grep "Baiduspider" access.log > baidu_crawler.log

- 分析爬虫的访问频率、抓取路径及响应状态码,判断是否存在异常行为(如高频访问404页面)。

核心分析指标与优化方向

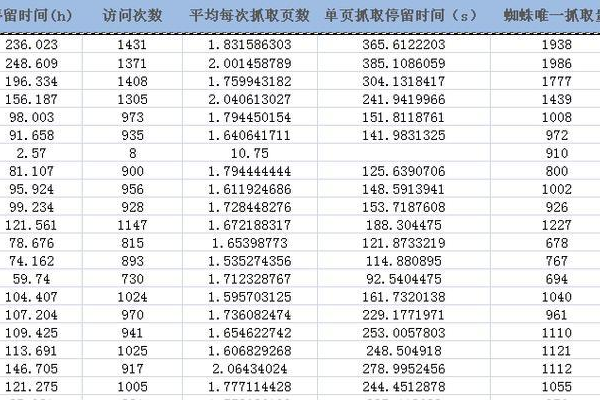

抓取覆盖率分析

- 健康状态:统计爬虫成功抓取的页面(HTTP 200)占比,目标值应>95%,若大量返回404/503,需检查死链或服务器负载。

- 深度抓取:观察爬虫是否访问了核心内容页(如产品详情、文章页),而非仅停留在首页或分类页。

抓取优先级分配

- 通过

X-Robots-Tag或robots.txt引导爬虫优先抓取高权重页面(如近期更新的内容、高转化率页面)。 - 使用百度站长工具的“抓取频次”功能,主动调整百度爬虫的访问压力。

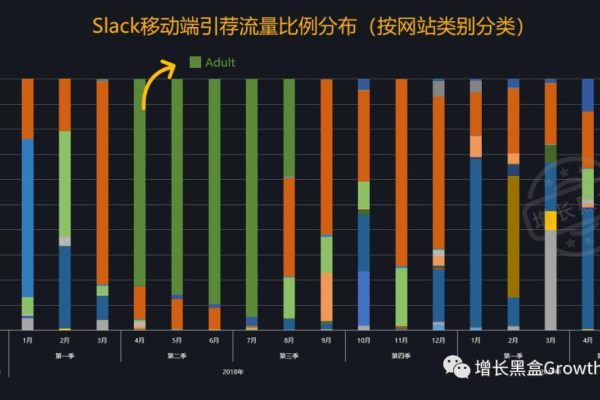

移动端与PC端适配

- 检测爬虫类型是否为移动版(如Baiduspider-mobile),确保移动端页面的渲染速度与结构化数据符合标准(如MIP/AMP)。

符合E-A-T原则的优化建议可信度**

- 若爬虫频繁访问“关于我们”“联系方式”等页面,需确保这些页面信息完整且可验证(如展示企业营业执照、作者资质证明)。

- 对专业性领域(如医疗、法律)内容,需在页面显著位置标注作者背景与参考文献。

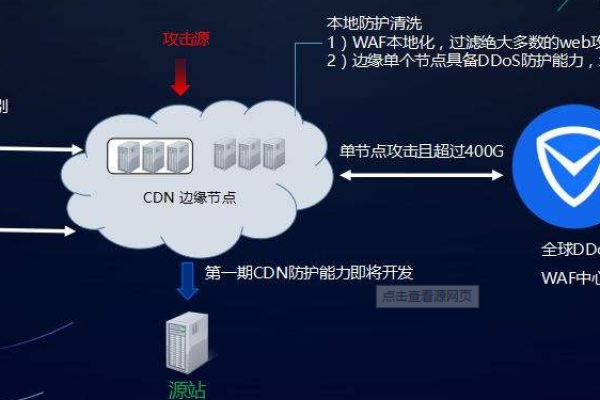

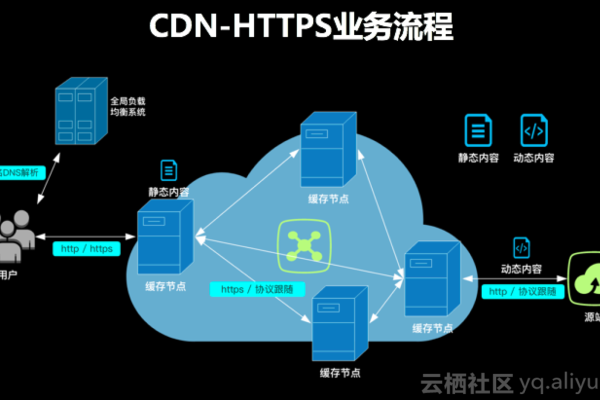

技术权威性

- 使用HTTPS协议,并在日志中监控爬虫对安全页面的抓取情况。

- 通过Schema标记增强页面结构化数据(如

Article、FAQPage),帮助爬虫理解内容主题。

用户体验关联

若爬虫大量访问但页面未收录,可能因内容质量不足,需结合跳出率、停留时间等用户行为数据优化内容。

工具推荐

- 百度站长平台:提供抓取异常报警、索引量曲线等核心数据。

- Screaming Frog Log Analyzer:可视化分析日志中的爬虫行为。

- ELK Stack(Elasticsearch+Logstash+Kibana):适合大型网站的实时日志监控。

引用说明

本文参考以下资源:

- 百度搜索资源平台《爬虫抓取机制详解》

- Google Search Central《Understanding Crawling and Indexing》

- Moz《The Ultimate Guide to Log File Analysis》