你的下一台云服务器会是AI吗?

- 行业动态

- 2025-04-17

- 1

什么是个人AI云服务器?

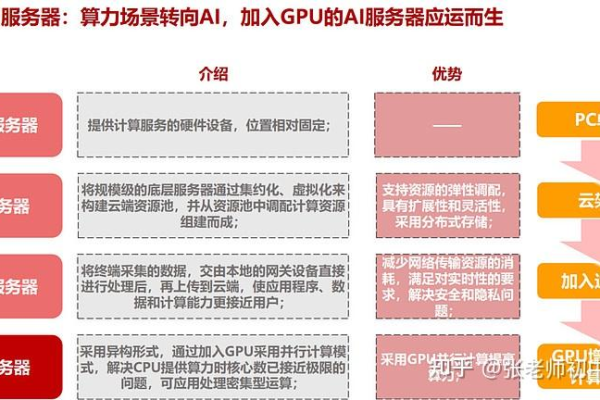

个人AI云服务器是一种结合人工智能(AI)技术与云计算资源的私有化部署方案,它允许用户通过云端服务器运行、训练和部署个性化AI模型,同时完全掌控数据与算力资源,与公共AI服务(如ChatGPT或Midjourney)不同,个人AI云服务器的核心优势在于数据隐私性、定制化功能以及成本可控性,尤其适合开发者、中小企业或对隐私要求较高的用户。

为什么需要个人AI云服务器?

数据安全与隐私保护

公共AI服务通常需要用户上传数据至第三方平台,存在泄露风险,个人AI云服务器部署在私有环境(如自有服务器或云服务商账户),所有数据仅在用户控制的范围内流通,满足GDPR等法规要求。定制化AI能力

用户可根据需求自由选择AI框架(如TensorFlow、PyTorch)、训练专属模型(例如语音识别、图像分类),甚至集成多个AI工具链,突破公共API的功能限制。长期成本优化

对于高频使用AI的团队,租赁云服务器并部署开源模型,比按次付费的公共API更经济,Stable Diffusion的自托管成本可能比商业绘图工具低50%以上。

无缝集成现有系统

个人AI云服务器可通过API与企业内部软件(如CRM、ERP)对接,实现自动化流程,例如智能客服、数据分析报告生成等。

如何搭建个人AI云服务器?

步骤1:选择云服务商与配置

- 主流服务商:AWS EC2、酷盾CVM、阿里云ECS等,提供GPU实例(如NVIDIA T4)以加速AI训练。

- 推荐配置:初期可选4核CPU+16GB内存+1块GPU(显存≥16GB),按需扩展。

步骤2:部署AI开发环境

- 安装Docker容器化工具,快速部署预配置的AI框架(如TensorFlow镜像)。

- 使用Jupyter Notebook或VS Code Server进行远程开发。

步骤3:模型训练与优化

- 本地训练:在小数据集上调试模型(如YOLO目标检测)。

- 云端分布式训练:使用Kubeflow或Horovod加速大规模数据训练。

步骤4:API化部署

- 通过Flask或FastAPI将模型封装为RESTful API,供外部调用。

- 配置Nginx反向代理与SSL证书,保障服务安全。

步骤5:监控与维护

- 使用Prometheus+Granafa监控服务器负载、API调用频次。

- 定期更新AI框架版本,修补安全破绽。

典型应用场景

- 个人助手

部署开源LLM(如Llama 2),构建私有化智能问答、文档总结工具。 - 智能家居中枢

通过云端AI分析家庭物联网数据,实现语音控制、能耗优化。 - 企业自动化

训练行业专属模型(如法律合同审查、医疗影像诊断),替代重复性人工任务。 创作**

自托管AIGC工具(如Stable Diffusion),生成定制化图片/视频内容。

选择服务商的注意事项

- 合规性:确保服务商支持数据加密存储,且服务器位于符合法规的区域(如国内用户需选境内节点)。

- 弹性计费:支持按小时计费的GPU实例,避免资源闲置。

- 技术支持:优先选择提供24/7运维响应及AI优化指南的服务商。

推荐组合方案

- 高性价比:酷盾GPU计算型GN10X + Docker + TensorFlow Serving

- 企业级:AWS SageMaker + Kubernetes集群 + 自定义模型库

未来趋势:个人AI服务器的进化方向

- 低代码化:云平台提供可视化AI编排工具,降低技术门槛。

- 边缘协同:与边缘计算结合,实现“云端训练+本地推理”的高效模式。

- 合规增强:内置隐私计算技术(联邦学习、同态加密),满足金融、医疗等敏感场景需求。

引用说明

- 云计算配置建议参考AWS官方文档(2025)

- 分布式训练方案部分内容引自Horovod白皮书

- 成本数据基于Gartner《2025年云AI服务经济性报告》

- 技术架构图灵感来源于IBM云解决方案案例库