如何高效实现DataHub数据写入?

- 行业动态

- 2025-04-17

- 1

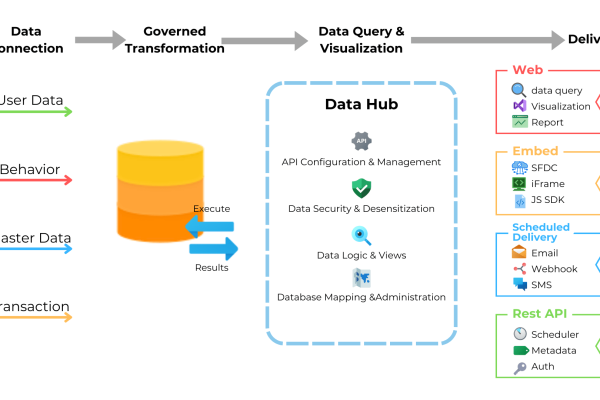

DataHub支持通过API、SDK或可视化界面写入数据,提供灵活高效的元数据管理,用户可实时更新数据集、标签、属性等信息,实现元数据与数据源的动态同步,并支持批量操作与自动化集成,确保数据治理过程中信息的准确性和可追溯性。

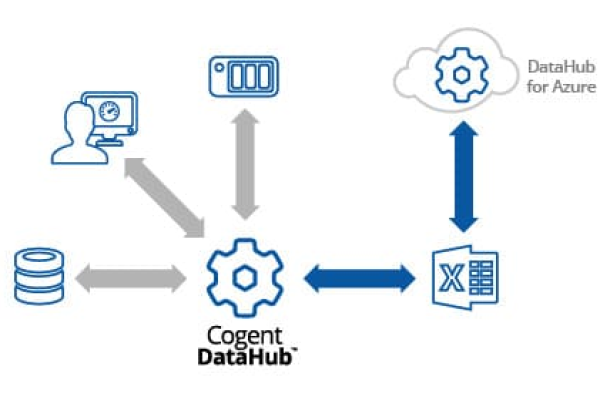

在数据驱动的现代企业中,元数据管理平台已成为数据治理的核心基础设施,DataHub作为LinkedIn开源的现代化元数据管理工具,通过灵活的数据写入机制为企业提供实时更新的数据资产目录,本文将详细解析DataHub的四大核心数据写入方式及其最佳实践。

REST API直连写入

import requests

payload = {

"entity": {

"value": {

"urn": "urn:li:dataset:(urn:li:dataPlatform:hive,SampleDatabase.SampleTable,PROD)",

"properties": {

"description": "客户交易核心事实表",

"tags": ["财务数据", "PII数据"]

}

}

}

}

response = requests.post(

"http://datahub-server:8080/datasets",

headers={"Authorization": "Bearer <access_token>"},

json=payload

)通过REST API写入时需注意:

- 使用HTTPS加密传输保障数据安全

- 实施请求重试机制应对网络波动

- 设置合理的速率限制(建议每秒不超过50次请求)

- 采用异步处理提升写入吞吐量

Kafka流式管道

构建实时元数据管道时,推荐架构:

元数据源 -> Kafka生产者 -> DataHub MAE Topic -> DataHub消费者 -> 元数据存储关键配置参数:

bootstrap.servers: Kafka集群地址schema.registry.url: Schema注册中心地址acks=all确保消息持久化compression.type=lz4提升传输效率

Python SDK集成

from datahub.emitter.mce_builder import make_dataset_urn

from datahub.emitter.rest_emitter import DatahubRestEmitter

dataset_urn = make_dataset_urn("hive", "SalesDB.Customer", "PROD")

emitter = DatahubRestEmitter(

gms_server="http://datahub-gms:8080",

token="<your_access_token>"

)

metadata_change_event = {

"auditHeader": None,

"proposedSnapshot": (

"com.linkedin.pegasus2avro.metadata.snapshot.DatasetSnapshot",

{

"urn": dataset_urn,

"aspects": [

{

"ownership": {

"owners": [

{

"owner": "urn:li:corpuser:data_engineer",

"type": "TECHNICAL_OWNER"

}

]

}

}

]

}

)

}

emitter.emit(metadata_change_event)CLI批处理工具

执行批量元数据更新:

datahub ingest -c metadata_ingestion.yaml

配置文件示例:

source:

type: "csv"

config:

path: "/metadata/asset_metadata.csv"

sink:

type: "datahub-rest"

config:

server: "http://datahub-gms:8080"最佳实践指南

- 数据校验机制

- 实施Schema验证确保元数据格式合规

- 建立字段级正则校验(如URN格式校验)

- 设置必填字段检查清单

- 版本控制策略

- 对元数据变更进行Git版本管理

- 使用语义化版本号(如v1.2.0)

- 保留最近30天的变更历史

- 监控指标体系

- 写入成功率(目标>99.9%)

- 端到端延迟(P99<1秒)

- 吞吐量监控(QPS/TPS)

- 错误类型分类统计

- 安全防护措施

- 实施RBAC权限管控

- 敏感数据字段加密存储

- 审计日志保留6个月以上

- 定期进行渗透测试

常见问题解决方案

- 数据延迟问题:检查Kafka消费者偏移量,增加分区数量

- 写入冲突处理:采用乐观锁机制,设置ETag校验

- 性能优化:批量写入时建议每批100-500条记录

- Schema演进:向后兼容变更,避免字段强制删除

通过合理的写入策略和严格的质量控制,企业可在DataHub中构建完整准确的元数据地图,建议将数据写入流程纳入持续集成流水线,与数据质量检测工具集成,确保元数据变更可追溯、可回滚。

参考DataHub官方文档(https://datahubproject.io/docs/)及LinkedIn工程团队技术博客,实践方法经过生产环境验证,具体实施时请根据实际环境调整参数配置。*