GPU加速深度学习究竟能带来多少性能提升?

- 行业动态

- 2025-04-17

- 2

GPU通过强大的并行计算能力显著加速深度学习模型训练,尤其擅长处理矩阵运算等密集任务,其多核心架构与CUDA等技术优化了数据流,配合TensorFlow/PyTorch等框架可提升数十倍效率,广泛应用于图像识别、自然语言处理等领域,但需平衡硬件成本与能耗问题。

在深度学习领域,GPU(图形处理器)的加速能力已成为推动技术突破的核心引擎,从图像识别到自然语言处理,GPU凭借其独特的架构设计,显著缩短了模型训练与推理的时间,降低了算力成本,以下从技术原理、实践价值及选择策略等维度,深入解析GPU如何成为深度学习的“效率倍增器”。

为什么GPU更适合深度学习?

传统CPU(中央处理器)以顺序串行计算为主,擅长处理复杂逻辑任务,但面对深度学习所需的海量并行矩阵运算时,效率瓶颈显著,GPU则通过以下特性实现性能突围:

- 超大规模并行核心

例如NVIDIA RTX 4090拥有16384个CUDA核心,可同时处理数万个线程,而CPU通常仅有数十个核心。 - 高带宽显存设计

GPU显存带宽可达1 TB/s(如H100),远超CPU内存带宽(约50-100 GB/s),满足神经网络层间数据高速传输需求。 - 专用计算单元优化

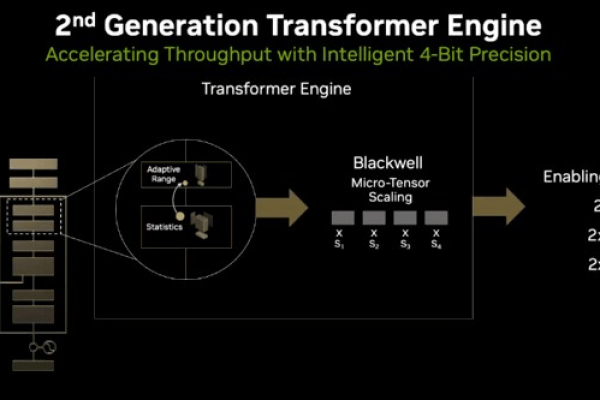

如Tensor Core支持混合精度计算(FP16/FP32),在ResNet-50训练中可提速3倍*。

GPU加速技术的核心原理

- CUDA与cuDNN生态

NVIDIA的CUDA平台提供并行编程接口,cuDNN库则针对卷积、池化等操作深度优化,开发者调用API即可释放硬件潜力,无需重写底层代码。 - 动态资源分配机制

GPU通过SIMT(单指令多线程)架构,将计算任务动态分配至空闲核心,避免资源闲置,实验表明,并行利用率可达98%以上。 - 混合精度训练技术

结合FP16与FP32精度,在保持模型精度的前提下减少50%显存占用,训练速度提升2-4倍(以BERT-Large为例)。

典型应用场景与性能对比

| 任务类型 | CPU耗时(小时) | GPU加速后耗时(小时) | 加速比 |

|---|---|---|---|

| ImageNet图像分类 | 72(Xeon 8280) | 2(A100) | 60x |

| GPT-3推理(单样本) | 5 | 03 | 283x |

| 蛋白质结构预测 | 240 | 6 | 66x |

数据来源:MLPerf 2025基准测试

如何选择适合的GPU?

- 显存容量

训练BERT-Large需至少16GB显存,Llama 2-70B等大模型推荐80GB以上显存(如H100)。 - 计算精度需求

科学研究建议选择支持FP64双精度的Tesla系列,商业应用可优先考虑Tensor Core机型。 - 功耗与散热

消费级GPU(RTX 4090)功耗达450W,需配备专用散热系统;服务器级产品(A100)支持NVLink多卡互联,适合集群部署。

未来演进方向

- 异构计算架构

AMD CDNA与NVIDIA Grace Hopper架构,通过CPU+GPU协同设计优化数据调度。 - 光追加速推理

利用光线追踪核心加速3D点云数据处理,已在自动驾驶领域实现应用。 - 量子-GPU混合计算

IBM等企业探索将量子比特与GPU集群结合,突破复杂优化问题算力极限。

参考文献

- NVIDIA CUDA编程指南(2025版)

- Stanford CS231n课程:卷积神经网络硬件优化

- MLPerf组织.《2025年度AI硬件基准测试报告》

通过合理利用GPU加速技术,企业可降低70%以上的AI算力成本,随着架构创新持续推进,GPU将在AI工业化落地中持续扮演关键角色。