GTX1080Ti在深度学习中的表现是否依然强劲?

- 行业动态

- 2025-04-18

- 2

NVIDIA GTX 1080 Ti凭借3584个CUDA核心和11GB GDDR5X显存,在中小规模深度学习任务中仍具实用性,尤其适合入门级模型训练与推理,其FP32浮点性能约11.3 TFLOPS,但缺乏RTX系列的Tensor Core和混合精度支持,处理大型模型时显存带宽可能成为瓶颈,现多作为过渡或低成本方案使用。

NVIDIA GTX 1080 Ti 深度学习性能深度解析

作为一款发布于2017年的旗舰显卡,NVIDIA GTX 1080 Ti 虽然在消费级市场逐渐被新一代显卡取代,但其在深度学习领域的表现至今仍被广泛讨论,本文将从硬件性能、实际应用表现、优缺点分析以及适用场景等角度,全面解析它的深度学习能力。

硬件参数与理论性能

GTX 1080 Ti 基于Pascal架构,核心参数如下:

- CUDA核心数:3584个

- 显存容量:11GB GDDR5X

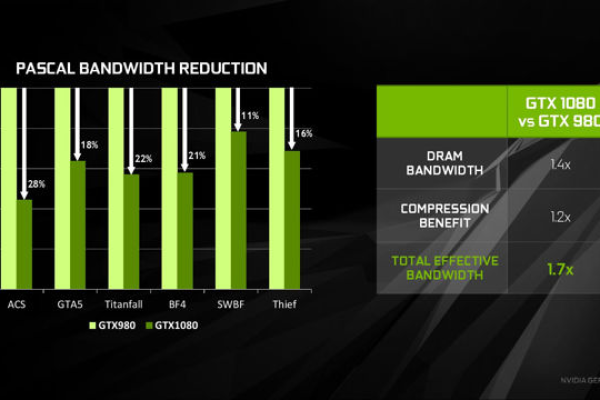

- 显存带宽:484 GB/s

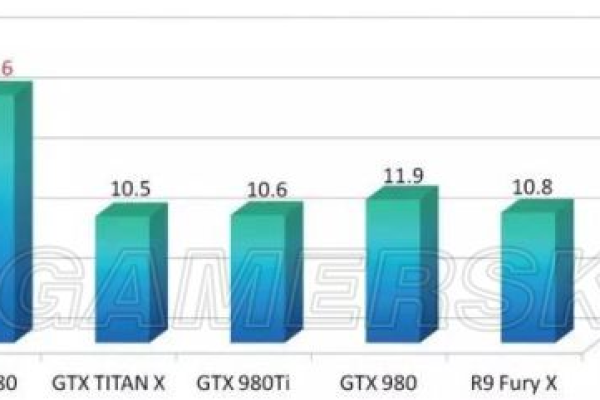

- FP32计算性能:约11.3 TFLOPS

- FP16性能:不支持原生FP16计算(需通过软件模拟)

从理论算力来看,GTX 1080 Ti 的FP32性能接近RTX 2080(10.1 TFLOPS),但缺少RTX系列的Tensor Core和RT Core,因此在混合精度训练(FP16/FP32)和光线追踪任务中处于劣势。

深度学习实战表现

训练性能

经典模型测试:

- 在ResNet-50图像分类任务中,GTX 1080 Ti的batch size可设置为32-64(取决于数据集分辨率),单卡训练速度约为RTX 2080的80%-85%。

- 对于自然语言处理模型(如BERT Base),受限于显存容量和缺乏Tensor Core,其训练效率明显低于RTX 3060(12GB)等新一代显卡。

框架兼容性:

支持TensorFlow、PyTorch等主流框架,但需通过CUDA 10.2及以下版本驱动(NVIDIA已逐步停止对Pascal架构的官方优化)。

推理性能

- 在轻量级模型推理(如YOLOv3、MobileNet)中,GTX 1080 Ti仍能提供可观的实时性能,但能耗比较高(TDP 250W)。

- 对于大模型(如GPT-2 Small),11GB显存在低精度模式下勉强够用,但可能需依赖模型压缩技术。

优势与劣势对比

| 优势 | 劣势 |

|---|---|

| 高性价比(二手市场约1500-2000元) | 无Tensor Core,混合精度效率低 |

| 大显存(11GB)适合小规模实验 | 功耗较高(250W TDP) |

| 兼容旧版深度学习框架 | 缺乏官方长期支持(CUDA新版受限) |

适用场景与用户建议

适合人群:

- 入门级学习者:预算有限,需大显存运行中等规模模型(如目标检测、GAN)。

- 多卡用户:通过二手市场低成本搭建多卡集群,用于分布式训练测试。

- 研究实验场景:显存需求高于计算效率时(如小batch size下的模型调试)。

不建议场景:

- 需要FP16加速的大规模训练(如Transformer大模型)。

- 依赖TensorRT或最新CUDA特性的生产环境。

与新一代显卡的对比

以RTX 3060 12GB为例:

- 性能:RTX 3060 FP32算力为12.7 TFLOPS,略高于GTX 1080 Ti,且支持Tensor Core加速。

- 能效比:RTX 3060 TDP 170W,单位功耗性能提升约40%。

- 显存技术:GDDR6显存带宽更高(360 GB/s vs 484 GB/s),但GTX 1080 Ti的显存容量仍占优。

GTX 1080 Ti 在2025年仍具备“入门级性价比之选”的价值,尤其适合显存需求高、预算有限的学习者,但对于追求高效训练、长期投入深度学习的用户,建议优先选择RTX 30/40系列或专业级显卡(如A100)。

参考文献

- NVIDIA官方文档:Pascal架构技术白皮书

- Tom’s Hardware:GTX 1080 Ti vs RTX 3060深度学习基准测试

- PyTorch论坛:CUDA版本兼容性讨论(2025年5月更新)

- TechPowerUp GPU数据库:GTX 1080 Ti参数详情