如何准确测量并优化服务器延迟?

- 行业动态

- 2025-01-04

- 1

服务器延迟是网络通信中不可忽视的一环,它直接影响到用户在使用互联网服务时的响应速度和体验,服务器延迟指的是从用户发出请求到服务器响应并返回结果所需的时间间隔,这个时间间隔由多个因素共同决定,以下是一些常见的影响服务器延迟的因素:

| 影响因素 | 描述 |

| 网络延迟 | 数据包在网络中传输所需的时间,受网络带宽、传输距离、路由器性能等多种因素影响,网络拥塞、物理距离远、路由器跳数多等都会导致网络延迟增加。 |

| 服务器处理时间 | 服务器接收到请求后,处理请求并生成响应所需的时间,这包括应用层逻辑处理、数据库查询、文件读写等操作,服务器硬件性能不足(如CPU、内存、磁盘I/O瓶颈)或软件优化不佳都会导致处理时间延长。 |

| 队列等待时间 | 在高并发场景下,服务器可能会因为处理能力不足而将请求放入队列等待处理,导致额外的延迟。 |

| 缓存策略 | 缓存的命中率和更新策略直接影响响应速度,如果缓存未命中,服务器可能需要从更慢的数据源(如数据库)中检索数据,从而增加延迟。 |

| 系统资源限制 | CPU、内存、磁盘I/O等资源瓶颈也会导致服务器延迟增加,当服务器负载过高时,这些资源的争用会更加激烈,进一步加剧延迟问题。 |

| 应用程序设计 | 应用程序的设计质量对服务器延迟也有重要影响,复杂的算法、频繁的文件I/O操作、不合理的数据库查询等都会增加处理时间。 |

| 网络设备配置 | 路由器、交换机等网络设备的配置也会影响服务器延迟,QoS(服务质量)设置可以确保重要流量优先处理,减少延迟。 |

| 地理位置 | 服务器与用户之间的地理距离越远,网络延迟通常越高,这是因为光速有限,数据需要更长的时间在网络中传输。 |

为了降低服务器延迟,可以采取以下措施:

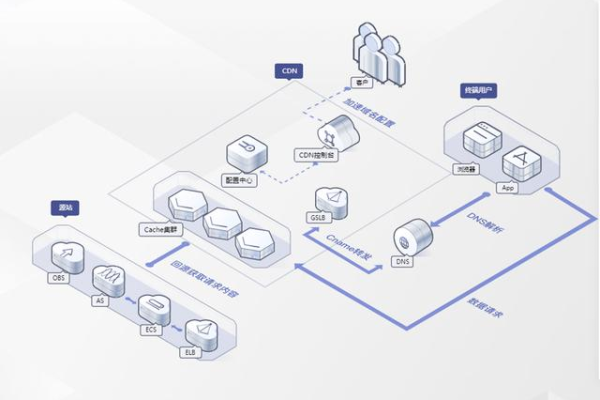

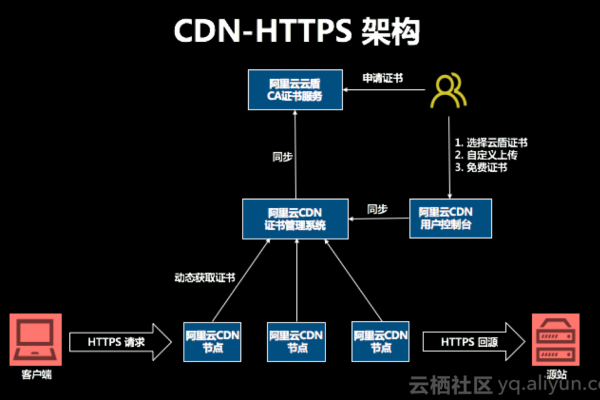

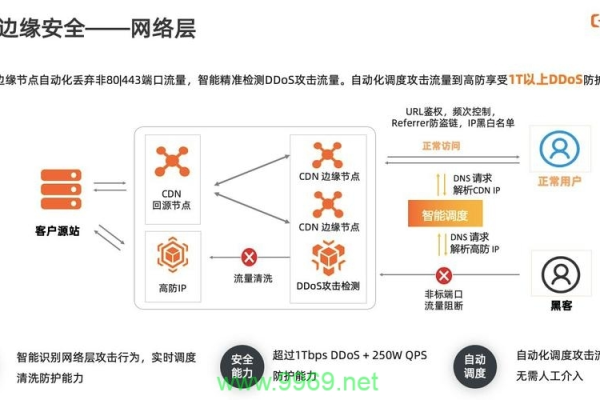

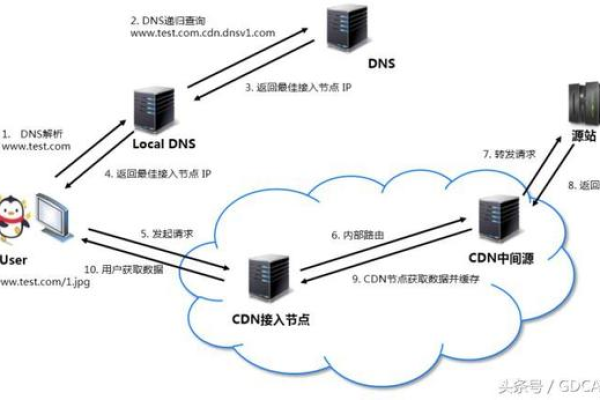

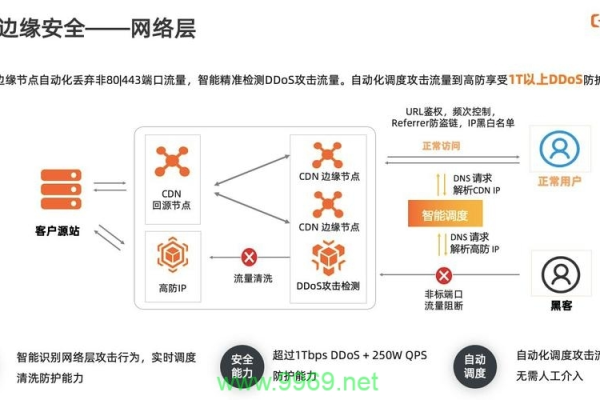

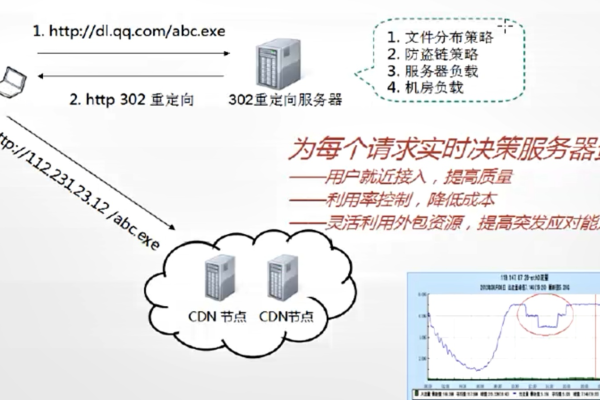

1、优化网络架构:选择高性能的网络设备,提高网络带宽和吞吐量;部署CDN(内容分发网络),将内容缓存到离用户更近的节点;使用TCP加速技术(如TCP Fast Open)减少TCP连接建立时间。

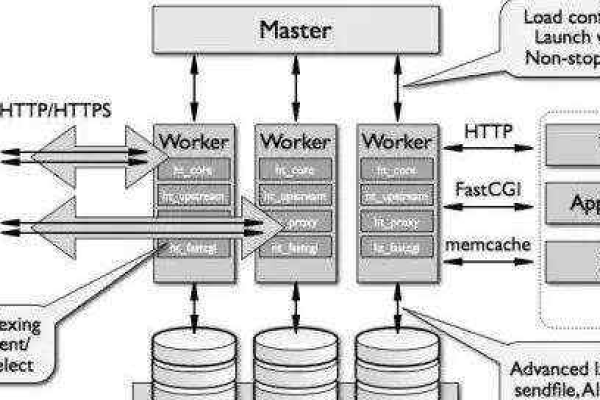

2、提升服务器处理能力:升级服务器硬件(如使用更快的CPU、更大的内存和更高性能的磁盘);优化应用逻辑,减少不必要的计算和I/O操作;使用异步处理框架提高并发处理能力。

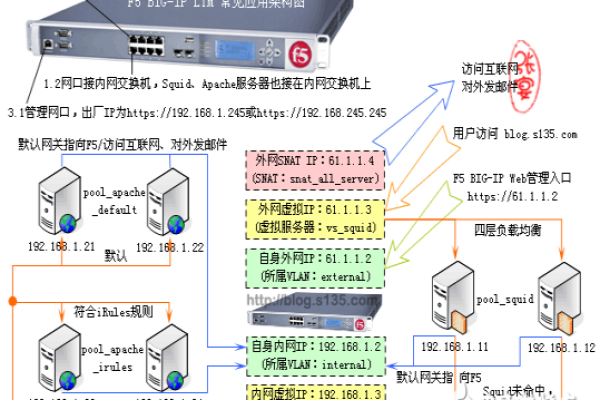

3、优化队列管理:设计合理的队列容量和优先级策略,确保高优先级请求得到优先处理;使用负载均衡技术将请求分散到多个服务器上处理。

4、改进缓存策略:提高缓存命中率,通过智能缓存替换算法(如LRU、LFU)和缓存预热技术;引入分布式缓存(如Redis、Memcached)提高缓存的可用性和可扩展性。

5、资源优化与监控:定期监控和分析系统资源使用情况,识别并优化资源瓶颈;使用容器化技术(如Docker、Kubernetes)实现资源的动态分配和弹性扩展;引入自动扩容机制根据负载情况自动调整服务器数量。

6、数据库优化:优化数据库查询使用索引、分区等技术提高查询效率;引入读写分离和数据库分片技术分散数据库压力;使用NoSQL数据库(如MongoDB、Cassandra)处理大规模、高并发的数据读写需求。

相关问答FAQs

1、问:为什么有时候访问同一个网站,不同用户的延迟差异很大?

答: 访问同一个网站时,不同用户的延迟差异可能由多种因素造成,用户的地理位置不同,与服务器之间的物理距离不同,导致网络传输时间存在差异,用户的网络环境不同,如有的用户使用有线连接,而有的用户使用无线连接,或者不同的ISP提供的网络服务质量不同,这些都会影响网络延迟,用户的设备性能、浏览器类型和版本、当前网络负载等因素也可能导致延迟差异,网站本身的负载情况、服务器性能以及是否采用了CDN等优化措施也会对延迟产生影响。

2、问:如何判断服务器延迟是由网络问题还是服务器本身问题导致的?

答: 要判断服务器延迟是由网络问题还是服务器本身问题导致的,可以采取以下几种方法:使用ping命令测试从本地到服务器的网络延迟,如果延迟较高且不稳定,可能是网络问题;如果延迟较低且稳定,则可能是服务器本身的问题,可以使用traceroute命令跟踪数据包的传输路径,观察在哪一跳出现延迟增大的情况,从而定位网络瓶颈或故障点,还可以通过对比同一时间段内不同用户的访问延迟来判断问题所在,如果所有用户都有较高的延迟,则可能是服务器问题;如果只有部分用户延迟较高,则可能是网络问题或用户自身设备问题,可以联系服务器提供商或网络服务提供商进行进一步的诊断和排查。