跑深度学习用的服务器_附录

- 行业动态

- 2024-07-04

- 4706

基于您提供的内容,我无法直接生成摘要,因为您没有给出具体的信息或上下文。如果您需要帮助撰写关于深度学习服务器的附录摘要,请提供更详细的信息,如服务器的配置、用途、性能测试结果等,这样我才能更准确地为您生成摘要。

1、硬件配置

CPU:CPU是服务器的核心,对于深度学习任务来说,多核高频率的CPU可以提供更好的数据处理能力,建议选择具有8核以上的高性能CPU。

GPU:深度学习任务对计算资源的需求很高,因此需要一块高性能的图形处理单元(GPU),NVIDIA的GPU在深度学习领域有广泛的应用,其CUDA和cuDNN库可以大大加速深度学习模型的训练。

内存:深度学习模型通常需要大量的内存来存储数据和模型参数,建议至少配置64GB的RAM,对于更复杂的模型和更大的数据集,可能需要更多的内存。

硬盘:硬盘用于存储操作系统、软件、数据和模型,建议使用SSD硬盘,因为其读写速度快,可以加快数据加载速度,提高工作效率。

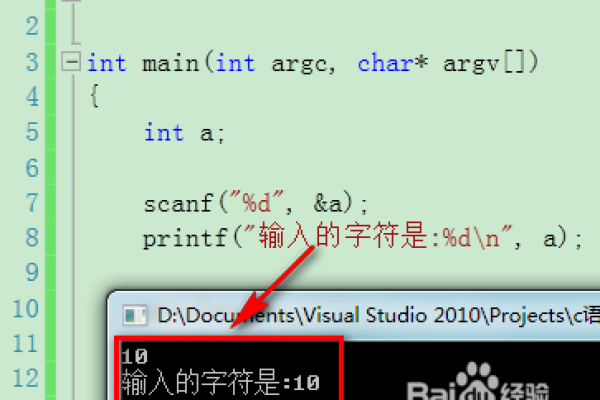

2、软件配置

操作系统:Linux是深度学习领域最常用的操作系统,因为它稳定、开源,并且有大量的深度学习工具和库支持。

驱动和库:需要安装适合GPU的驱动程序,以及CUDA和cuDNN库,这些库可以加速深度学习模型的训练。

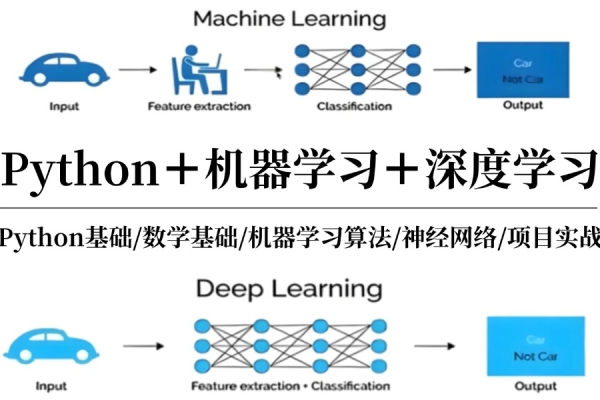

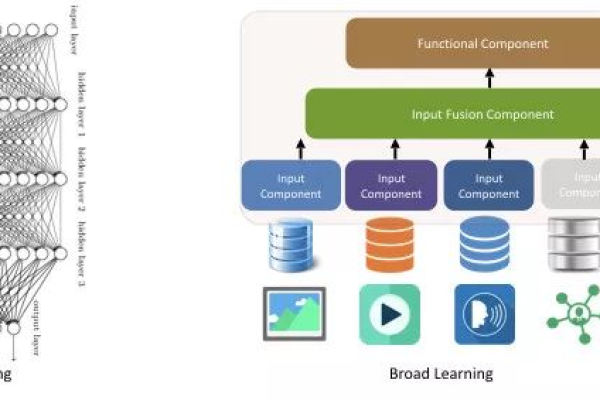

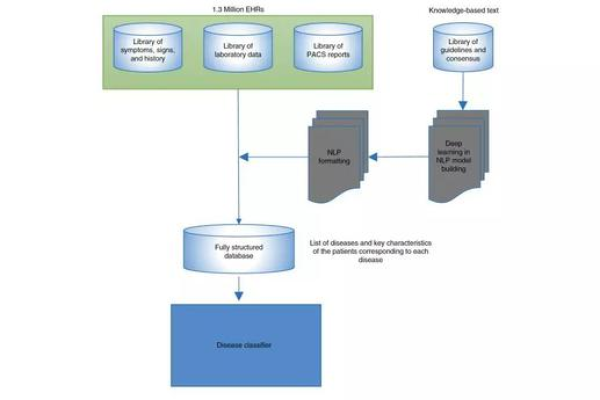

深度学习框架:PyTorch、TensorFlow等是最常用的深度学习框架,它们提供了大量的预训练模型和易于使用的API,可以大大提高开发效率。

3、环境配置

Docker:Docker是一个开源的应用容器引擎,可以将应用及其依赖环境打包到一个可移植的容器中,使得应用可以在任何支持Docker的平台上运行,在深度学习环境中,Docker可以帮助我们快速部署和复制环境,避免环境差异带来的问题。

SDK工具:NVIDIA提供了一系列的SDK工具,如TensorRT、DeepStream等,可以帮助我们优化和部署深度学习模型。

4、性能需求

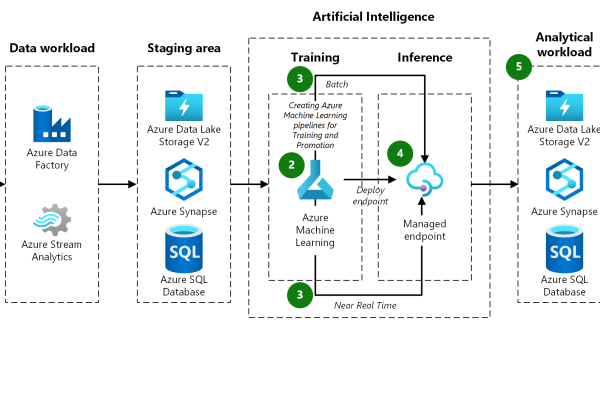

训练性能:深度学习模型的训练通常需要大量的计算资源,因此需要一台具备高性能计算能力的服务器,GPU的性能直接影响到模型训练的速度,因此选择一块高性能的GPU是非常重要的。

推理性能:除了训练性能外,推理性能也是一个重要的考虑因素,推理是指在训练好的模型上进行预测的过程,这通常需要快速的计算能力,NVIDIA的GPU在这方面有非常好的表现。

5、推荐配置

最低配置:对于初学者和小型项目,可以使用一块NVIDIA的GPU,64GB的RAM,以及一块SSD硬盘,这种配置可以满足大部分深度学习任务的需求。

高级配置:对于大型项目和研究,可以使用多块NVIDIA的GPU,128GB以上的RAM,以及多块SSD硬盘,这种配置可以提供更高的计算能力和存储空间,满足大规模深度学习任务的需求。

深度学习是一个非常复杂和计算密集型的任务,需要强大的硬件和软件支持,选择合适的硬件配置、软件配置和环境配置,可以大大提高深度学习的效率和效果,根据项目的大小和需求,可以选择不同的配置方案。

FAQs

Q1: 我应该选择什么样的GPU?

A1: 你应该选择NVIDIA的GPU,因为它们在深度学习领域有广泛的应用,并且有丰富的工具和库支持,具体型号可以根据预算和需求来选择,例如NVIDIA的Tesla系列、Quadro系列或者GeForce系列。

Q2: 我是否需要使用SSD硬盘?

A2: 是的,你可能需要使用SSD硬盘,因为SSD硬盘的读写速度快,可以加快数据加载速度,提高工作效率,如果你的预算有限,可以考虑使用一块小容量的SSD硬盘来安装操作系统和软件,然后使用大容量的HDD硬盘来存储数据和模型。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/38481.html