从数据库获取json数据

- 行业动态

- 2025-04-07

- 1

从数据库获取 JSON 数据:全面解析与实践指南

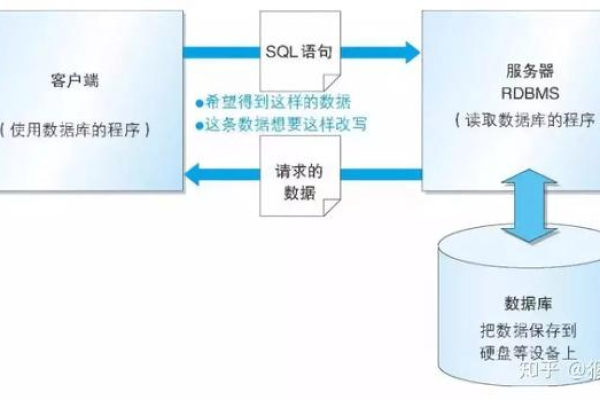

在当今数字化时代,数据存储与交互的高效性至关重要,从数据库获取 JSON 数据已成为众多应用程序开发中的常见需求,无论是构建动态网页、移动应用后端,还是进行数据分析与处理,都离不开这一关键环节,以下将深入探讨从数据库获取 JSON 数据的多种方式、相关技术要点以及实际应用案例,助力开发者掌握这一关键技术。

一、关系型数据库获取 JSON 数据

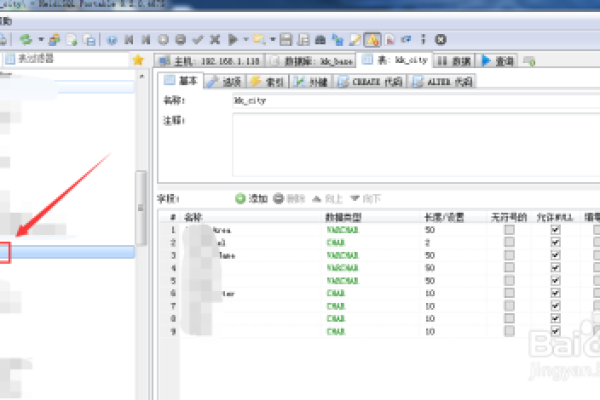

(一)MySQL 数据库

1、使用 SELECT INTO OUTFILE

原理:通过 MySQL 的SELECT INTO OUTFILE 语句,可以将查询结果直接导出为 JSON 格式的文件,假设有一个名为users 的表,包含id、name 和email 等字段,若要将其数据导出为 JSON,可执行如下 SQL 语句:

示例代码:

SELECT id, name, email INTO OUTFILE '/path/to/output.json'

FIELDS TERMINATED BY ','

OPTIONALLY ENCLOSED BY '"'

LINES TERMINATED BY '

'

FROM users;注意事项:这种方法需要在 MySQL 服务器上有相应的文件写入权限,并且要确保指定的文件路径存在且可写,对于大型数据集,可能会受到文件系统的限制和性能影响。

2、借助存储过程与编程语言结合

原理:首先在 MySQL 中创建一个存储过程,用于查询所需数据并以特定格式返回,然后在应用程序端(如使用 Python 的mysql connector python 库)调用该存储过程,并将结果转换为 JSON 格式。

示例代码(MySQL 存储过程):

DELIMITER //

CREATE PROCEDURE GetUsersAsJson()

BEGIN

SELECT id, name, email FROM users;

END //

DELIMITER ;示例代码(Python 调用及转换):

import mysql.connector

import json

connection = mysql.connector.connect(

host="localhost",

user="your_username",

password="your_password",

database="your_database"

)

cursor = connection.cursor()

cursor.callproc('GetUsersAsJson')

result = cursor.fetchall()

json_data = json.dumps(result, default=str)

print(json_data)优势:这种方式灵活性较高,可以对查询结果进行更复杂的处理和格式化,适用于需要对数据进行进一步加工的场景,但需要编写额外的存储过程代码,并处理应用程序与数据库之间的连接和数据传输。

(二)PostgreSQL 数据库

1、利用 COPY TO 命令

原理:PostgreSQL 的COPY TO 命令类似于 MySQL 的SELECT INTO OUTFILE,可用于将表数据导出为文本文件,然后再通过外部工具或脚本将其转换为 JSON 格式。

示例代码:

COPY (SELECT id, name, email FROM users) TO '/path/to/output.csv' CSV HEADER;

后续转换操作:可以使用 Python 的pandas 库读取 CSV 文件,并将其转换为 JSON 格式。

import pandas as pd

df = pd.read_csv('/path/to/output.csv')

json_data = df.to_json(orient='records')

print(json_data)特点:这种方法利用了 PostgreSQL 自身的强大文本导出功能,能够高效地处理大量数据,但在转换过程中可能需要一些额外的步骤来确保数据格式的准确性,尤其是对于复杂数据类型和特殊字符的处理。

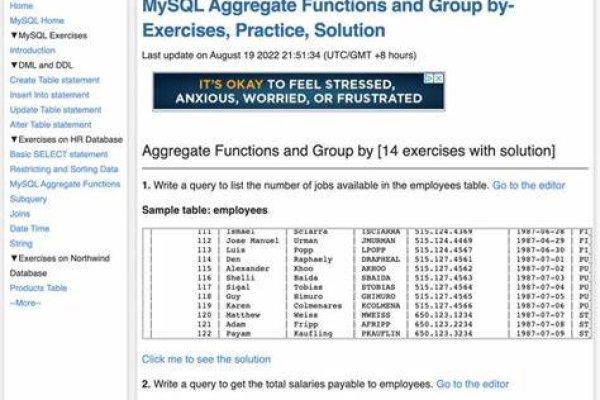

2、使用 PostgreSQL 的 JSON 函数

原理:PostgreSQL 提供了丰富的 JSON 处理函数,可以直接在 SQL 查询中使用这些函数将数据转换为 JSON 格式,使用row_to_json 函数将一行数据转换为 JSON 对象,再使用array_to_json 将多行数据组成的数组转换为 JSON 数组。

示例代码:

SELECT array_to_json(array_agg(row_to_json(users))) AS json_data

FROM users;适用场景:适用于在数据库层面直接获取 JSON 数据的场景,无需在应用程序中进行额外的转换操作,提高了数据处理的效率和简洁性,但对于不熟悉 PostgreSQL JSON 函数的开发者来说,可能需要一定的学习成本来掌握其使用方法和技巧。

二、非关系型数据库获取 JSON 数据

(一)MongoDB 数据库

1、基本查询与转换

原理:MongoDB 是文档型数据库,其存储的数据格式本身就是类似 JSON 的 BSON(Binary JSON)格式,通过简单的查询操作即可获取 JSON 数据,使用 MongoDB 的 Shell 或驱动程序(如 Python 的pymongo 库)连接到数据库后,执行查询语句并直接获取结果。

示例代码(Python 使用 pymongo):

from pymongo import MongoClient

client = MongoClient('mongodb://localhost:27017/')

db = client['your_database']

collection = db['users']

users = collection.find({}, {'_id': 0})

json_data = list(users)

print(json.dumps(json_data, ensure_ascii=False, indent=4))优势:由于 MongoDB 的数据模型与 JSON 天然契合,所以在获取 JSON 数据方面非常便捷,无需复杂的转换操作,能够快速地满足应用程序对 JSON 数据的需求,MongoDB 支持丰富的查询语法和索引机制,可以高效地查询和筛选数据。

2、聚合框架获取复杂 JSON 数据

原理:MongoDB 的聚合框架提供了强大的数据处理能力,可以对数据进行复杂的计算、分组、排序等操作,并将最终结果以 JSON 格式返回,要对users 集合按年龄分组并统计每组的人数,可以使用如下聚合管道:

示例代码:

pipeline = [

{"$group": {"_id": "$age", "count": {"$sum": 1}}}

]

result = collection.aggregate(pipeline)

json_data = list(result)

print(json.dumps(json_data, ensure_ascii=False, indent=4))应用场景:适用于需要对数据进行深度分析和处理的场景,如生成报表、数据统计分析等,通过聚合框架,可以在数据库端完成复杂的数据计算和转换,减少数据传输量和应用程序端的处理压力。

三、混合数据库环境获取 JSON 数据

在一些复杂的应用系统中,可能会同时使用关系型数据库和非关系型数据库,关系型数据库用于存储结构化的业务数据,如用户信息、订单明细等;而非关系型数据库则用于存储半结构化或非结构化的数据,如日志文件、用户配置等,在这种情况下,获取 JSON 数据可能需要综合运用上述不同数据库的技术和方法。

1、数据整合与转换策略

ETL 工具的使用:可以使用 ETL(Extract, Transform, Load)工具来整合不同数据库中的数据,并将其转换为统一的 JSON 格式,使用开源的 Talend、Apache NiFi 等工具,通过配置数据抽取任务从关系型数据库和非关系型数据库中获取数据,然后使用内置的转换组件对数据进行清洗、转换和合并操作,最后将整合后的数据加载到目标存储位置(可以是文件系统或另一个数据库),并以 JSON 格式输出。

自定义应用程序逻辑:在应用程序中编写自定义的代码来分别连接关系型数据库和非关系型数据库,获取所需的数据后进行整合和转换,在一个基于微服务架构的电商平台中,订单服务可能使用关系型数据库存储订单信息,而用户偏好服务使用非关系型数据库存储用户的个性化设置,当需要生成一个包含订单详情和用户偏好的综合 JSON 数据时,订单服务可以通过调用关系型数据库的接口获取订单数据,并将其转换为 JSON 格式;用户偏好服务从非关系型数据库中查询用户偏好数据并转换为 JSON 格式,这两个服务的 JSON 数据可以在前端应用程序中进行合并和展示。

2、数据一致性与同步问题

事务管理:在涉及多个数据库的数据操作中,确保数据的一致性是一个关键问题,如果关系型数据库支持事务管理(如 MySQL 的 InnoDB 存储引擎),可以在关系型数据库的操作中使用事务来保证数据的原子性、一致性、隔离性和持久性(ACID),但对于非关系型数据库,其事务支持相对较弱或没有传统的事务机制,在这种情况下,可以采用分布式事务解决方案,如基于两阶段提交协议(2PC)或补偿事务的方式来实现跨数据库的数据一致性,在使用 Seata 框架进行分布式事务管理时,可以将关系型数据库和非关系型数据库的操作纳入同一个全局事务中进行管理,确保在数据获取和转换过程中的一致性。

数据同步机制:为了保证不同数据库之间的数据同步,可以采用数据复制、消息队列等技术手段,当关系型数据库中的数据发生更新时,可以通过触发器或应用程序逻辑将变更数据发送到消息队列中,然后由订阅该消息队列的非关系型数据库或其他系统进行相应的数据更新操作,这样可以避免由于不同数据库的数据不一致导致的错误和异常情况。

从数据库获取 JSON 数据的方法多种多样,取决于所使用的数据库类型以及具体的应用场景和需求,在选择方法时,需要综合考虑数据量、性能要求、开发难度、数据一致性等因素,以确定最适合的技术方案,随着数据库技术的不断发展和创新,新的获取 JSON 数据的方法和技术也在不断涌现,开发者需要保持学习和探索的精神,以适应不断变化的应用开发需求。

FAQs

Q1:从 MySQL 数据库获取 JSON 数据时,使用SELECT INTO OUTFILE 命令有什么限制和注意事项?

A1:使用SELECT INTO OUTFILE 命令时,需要注意以下几点限制和事项:

1、文件路径权限:必须确保 MySQL 服务器进程有权限在指定的文件路径下创建和写入文件,如果没有足够的权限,命令将会失败,在某些操作系统上,可能需要以超级用户身份运行 MySQL 服务或者修改文件系统的权限设置。

2、字段数据类型:对于一些特殊的数据类型,如二进制数据(BLOB、BINARY 等)、日期时间类型(DATETIME、TIMESTAMP 等)以及包含特殊字符的字符串类型,在写入文件时可能会出现格式转换问题,默认情况下,SELECT INTO OUTFILE 会将数据按照文本格式存储,对于非文本数据类型可能需要进行额外的处理或转换。

3、性能影响:在大数据量的情况下,SELECT INTO OUTFILE 命令可能会对数据库的性能产生一定的影响,尤其是在高并发的读写操作环境下,因为它需要将查询结果写入磁盘文件,这涉及到 I/O 操作,可能会与其他数据库操作竞争系统资源,如果查询语句本身比较复杂且耗时较长,那么整个操作的时间也会相应增加。

4、安全性考虑:由于SELECT INTO OUTFILE 会将数据直接写入到服务器的文件系统中,存在数据泄露的风险,如果文件中包含了敏感信息,如用户密码、个人隐私数据等,需要确保文件的安全性,例如设置合适的文件权限、加密存储或者及时删除不再需要的文件等。

Q2:在 PostgreSQL 中使用 COPY TO 命令导出数据为 CSV 后转换为 JSON,如何处理数据类型转换和编码问题?

A2:当使用 PostgreSQL 的 COPY TO 命令将数据导出为 CSV 格式后转换为 JSON 时,可能会遇到以下数据类型转换和编码问题及处理方法:

1、数据类型转换:

数值类型:CSV 文件中通常以文本形式表示数值,但在转换为 JSON 时可能需要根据实际需求将其转换为适当的数值类型(整数、浮点数等),在 Python 中使用pandas 库读取 CSV 文件后,可以使用pd.to_numeric 函数将数值列转换为数值类型。

日期时间类型:CSV 中的日期时间数据可能以字符串形式存储,需要根据日期时间的格式进行解析和转换,使用pd.to_datetime 函数可以将符合特定格式的日期时间字符串转换为datetime 对象,然后再进行处理,对于一些不规则的日期时间格式,可能需要编写自定义的解析函数来进行转换。

布尔类型:CSV 中的布尔值可能以不同的文本形式表示,如 “true”/“false”、 “1”/“0”、 “是”/“否” 等,在转换为 JSON 时,需要统一将这些文本表示转换为布尔类型(True/False),可以使用条件判断语句或映射函数来实现这种转换。

2、编码问题:

字符编码:确保在读取和写入文件时的字符编码一致,如果在导出 CSV 文件时使用了特定的字符编码(如 UTF-8),那么在读取该文件并转换为 JSON 时也需要使用相同的编码方式,否则,可能会出现乱码或字符解析错误,在 Python 中,可以使用open 函数并指定encoding 参数来确保正确的字符编码处理。with open('file.csv', 'r', encoding='utf-8') as f:。

转义字符:CSV 文件中的特殊字符(如逗号、换行符等)通常会被转义处理,在转换为 JSON 时,需要注意正确处理这些转义字符,避免出现解析错误,大多数的 CSV 解析库会自动处理转义字符,但如果手动处理的话,需要了解并遵循相应的转义规则,在 Python 中,使用csv 模块读取 CSV 文件时,它会正确处理转义字符并将每一行解析为一个列表,但在将列表转换为 JSON 字符串时,需要确保其中的字符串元素没有被错误地转义或截断。