从普通开发进阶为数据科学家

- 行业动态

- 2025-04-05

- 1

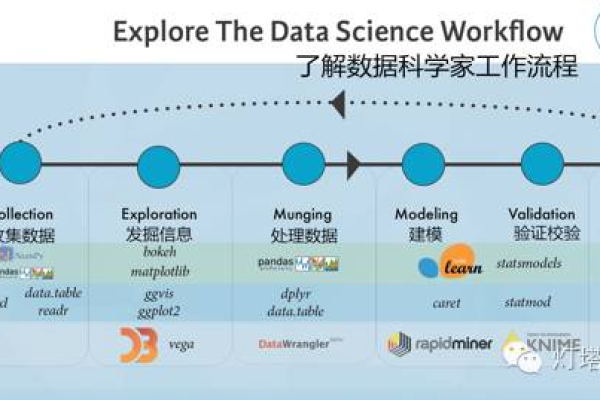

从普通开发进阶为数据科学家是一个涉及多方面技能提升和知识积累的过程,以下是详细的步骤和建议:

一、扎实的编程基础

掌握编程语言

Python:作为数据科学的主要语言,Python拥有丰富的库和工具,如NumPy、Pandas、Matplotlib、Scikit-learn等。

R:虽然Python在数据科学中占据主导地位,但R语言在统计分析和可视化方面依然有其优势。

Java/Scala:对于大数据处理和分布式计算,Java和Scala也是必不可少的技能。

数据结构与算法

理解基本的数据结构和算法是高效编程的基础,包括数组、链表、栈、队列、树、图等。

熟悉常见的算法,如排序、搜索、动态规划等。

二、统计学与数学基础

概率论与统计

理解概率分布、期望、方差等基本概念。

掌握描述性统计、推断性统计、假设检验等方法。

线性代数

矩阵运算是许多机器学习算法的基础。

理解特征值、特征向量等概念。

微积分

了解导数、积分的基本概念和应用。

掌握梯度下降等优化算法的原理。

三、数据库管理

SQL

熟练使用SQL进行数据查询、过滤、聚合等操作。

理解数据库设计原则,如范式化。

NoSQL数据库

了解非关系型数据库,如MongoDB、Cassandra等,适用于大规模数据处理。

四、机器学习与深度学习

机器学习基础

理解监督学习、无监督学习、半监督学习和强化学习的区别。

掌握常见的机器学习算法,如线性回归、逻辑回归、决策树、支持向量机等。

深度学习框架

学习使用TensorFlow、PyTorch等深度学习框架。

理解神经网络的结构,如卷积神经网络(CNN)、循环神经网络(RNN)等。

五、大数据技术

Hadoop生态系统

了解Hadoop、HDFS、MapReduce等技术。

掌握使用Hive、Pig等工具进行数据处理。

Spark

学习使用Spark进行大规模数据处理和分析。

理解Spark的核心组件,如Spark Core、Spark SQL、Spark Streaming等。

六、数据可视化与报告

数据可视化工具

掌握使用Matplotlib、Seaborn、Plotly等工具进行数据可视化。

理解如何选择合适的图表类型来展示数据。

报告撰写

学会撰写清晰、准确的分析报告。

使用Jupyter Notebook等工具创建交互式报告。

七、软技能与项目管理

沟通与协作

数据科学家通常需要与多个团队协作,因此良好的沟通能力至关重要。

学会清晰地表达自己的想法和发现。

项目管理

理解项目管理的基本原则和方法。

能够制定合理的项目计划并跟踪进度。

八、持续学习与实践

在线课程与书籍

利用Coursera、edX等平台学习相关课程。

阅读经典书籍,如《Python数据科学手册》、《机器学习实战》等。

开源项目与竞赛

参与开源项目,贡献代码并学习最佳实践。

参加Kaggle等数据科学竞赛,锻炼解决实际问题的能力。

九、建立个人品牌与网络

博客与社交媒体

开设个人博客或社交媒体账号,分享学习心得和技术见解。

加入相关的技术社区和论坛,与同行交流经验。

参加会议与研讨会

参加行业会议和研讨会,了解最新的技术动态和趋势。

与业界专家建立联系,拓展人脉资源。

FAQs

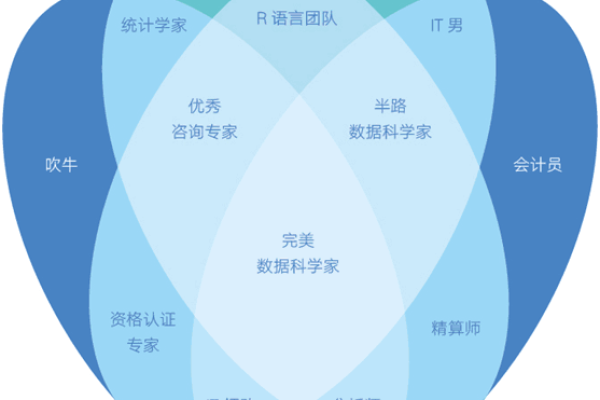

Q1: 数据科学家需要具备哪些核心技能?

A1: 数据科学家需要具备以下核心技能:扎实的编程基础(尤其是Python和R)、统计学与数学基础(包括概率论、线性代数和微积分)、数据库管理(特别是SQL)、机器学习与深度学习(包括常见算法和框架)、大数据技术(如Hadoop和Spark)、数据可视化与报告撰写能力、良好的沟通与协作能力以及项目管理能力,持续学习和实践也是不可或缺的部分。

Q2: 如何从普通开发进阶为数据科学家?

A2: 从普通开发进阶为数据科学家需要以下几个步骤:巩固编程基础,特别是Python和R;加强统计学与数学知识的学习;掌握数据库管理和SQL查询技能;深入学习机器学习与深度学习理论及实践;了解大数据技术并掌握相关工具;提升数据可视化与报告撰写能力;注重软技能的培养,如沟通与协作、项目管理等,通过持续学习和实践,参与开源项目和竞赛,建立个人品牌与网络,逐步实现从普通开发到数据科学家的转变。