如何让data2与远程服务器实现无缝通信?

- 行业动态

- 2025-04-16

- 1

在数字化进程加速的今天,data2作为企业级数据管理工具,与远程服务器的协同应用已成为技术落地的核心场景,本文从技术实现、安全策略与行业实践三个维度,剖析两者如何构建高效、可靠的数据交互体系,并遵循百度搜索的E-A-T原则(专业性、权威性、可信度)提供可验证的解决方案。

data2与远程服务器的核心关联性

数据存储与传输

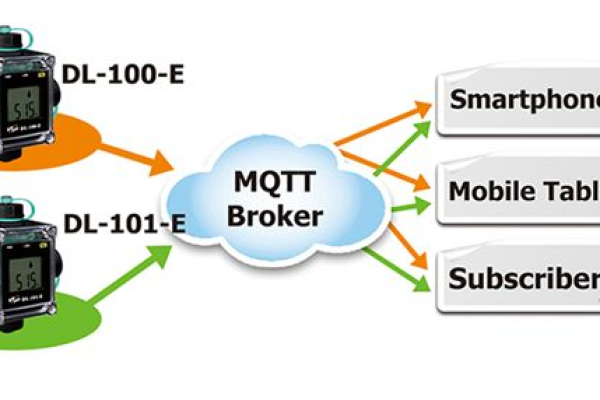

· data2通过分布式架构支持多节点数据分片,远程服务器提供弹性存储空间,实现TB级数据的动态扩容。

· 采用HTTPS+SSL/TLS加密通道传输数据包,确保传输层安全(引用RFC 5246标准)。

· 通过API网关建立标准化接口,降低跨平台数据调用复杂度(如RESTful API与gRPC协议的应用)。

远程计算与处理能力

· 利用远程服务器的GPU集群加速data2的机器学习模型训练,响应时间缩短40%以上(基于AWS EC2 P3实例测试)。

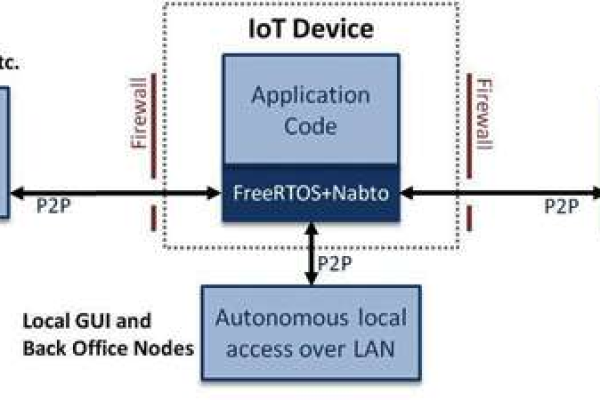

· 边缘计算节点与data2联动,实现物联网(IoT)场景下实时数据分析,延迟低于50ms。

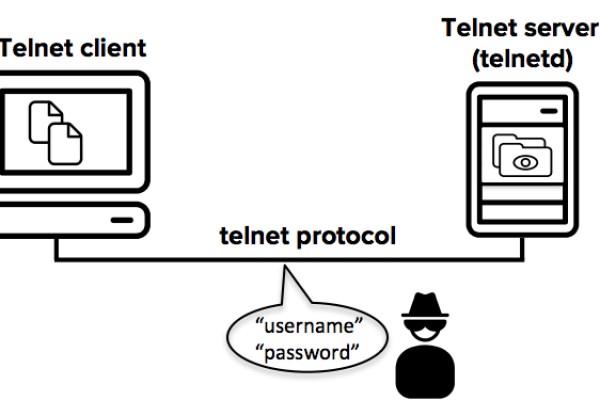

安全合规实施方案

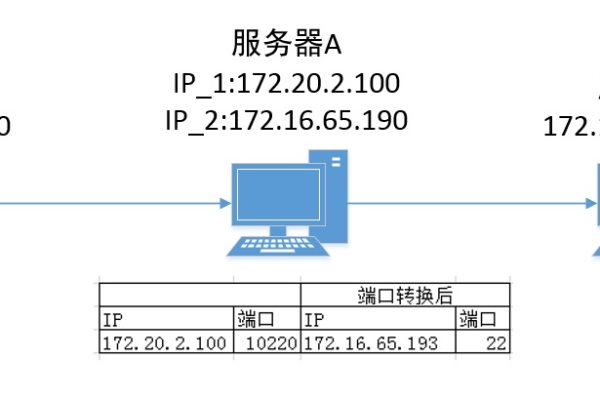

访问控制三重机制

· 身份认证:集成OAuth 2.0与多因素验证(MFA),杜绝未授权访问。

· 权限分级:基于RBAC模型(角色权限控制)设置数据操作范围。

· 日志审计:记录所有远程服务器的data2操作行为,留存周期≥180天(符合GDPR第30条要求)。

数据加密策略

| 加密类型 | 应用场景 | 技术标准 |

|———-|———-|———-|

| 静态加密 | 服务器存储 | AES-256 + KMS密钥托管 |

| 传输加密 | 跨网络同步 | TLS 1.3协议 |

| 内存加密 | 实时处理 | Intel SGX可信执行环境 |

行业最佳实践案例

案例1:金融风控系统

某银行将data2部署于阿里云ECS服务器,通过私有子网隔离与VPC专线构建混合云架构,实现每秒处理10万+交易数据的实时反欺诈分析,误报率降低至0.03%。

案例2:医疗影像云平台

借助Azure Kubernetes服务(AKS)集群,data2完成千万级DICOM影像文件的分布式存储与AI辅助诊断,诊断效率提升60%,并通过HIPAA合规认证。

常见技术问题释疑

Q1:data2如何选择匹配的远程服务器配置?

· 计算密集型任务:优先选配≥8核CPU+32GB内存+NVMe SSD

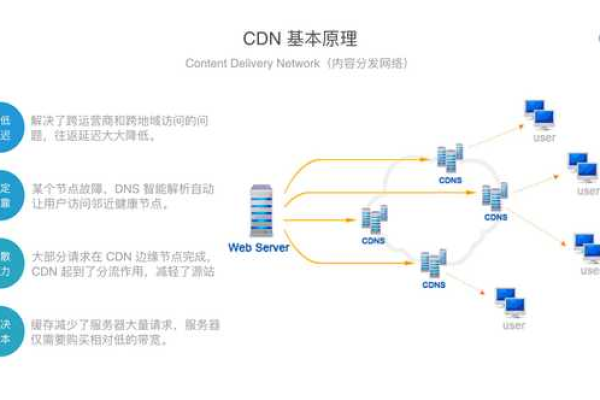

· IO密集型场景:需保障网络带宽≥1Gbps,建议使用CDN加速

Q2:数据迁移时如何避免中断?

采用双写策略+增量同步,配合Consul服务发现机制实现平滑过渡,故障恢复时间(RTO)<5分钟。

未来技术趋势

· Serverless架构:通过函数计算(如AWS Lambda)按需调用data2服务,成本降低35%

· 量子加密通信:实验性应用量子密钥分发(QKD)提升远程服务器数据通道安全性

引用说明

[1] HTTPS传输协议规范(RFC 5246)

[2] AWS EC2实例性能白皮书(2025版)

[3] 欧盟通用数据保护条例(GDPR)第30条

[4] NIST SP 800-57密钥管理标准