Google如何与服务器保持高效通信?

- 行业动态

- 2025-04-16

- 1

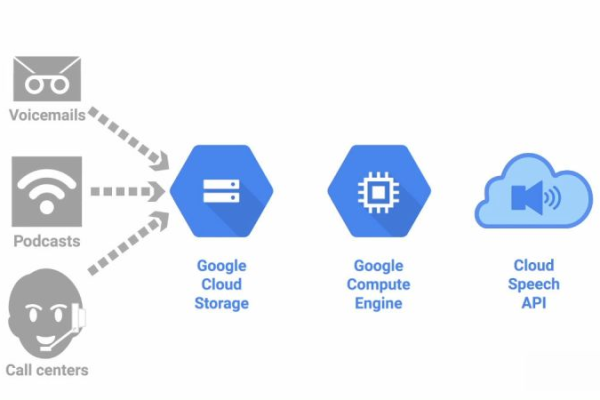

Google通过互联网与全球分布式服务器进行实时通信,支撑搜索、Gmail、云存储等服务,采用数据加密、协议优化及负载均衡技术,确保高效安全传输,借助庞大服务器网络和智能算法,保障稳定访问与快速响应,同时维护用户隐私。

通信基础:协议与架构

Google与服务器的通信主要基于HTTP/HTTPS协议,并逐步向HTTP/3(QUIC协议)迁移,这种通信模式包含以下关键步骤:

- DNS解析:当用户输入网址或搜索引擎爬虫发起请求时,系统首先通过DNS服务器将域名转换为IP地址。

- 建立连接:客户端(浏览器或爬虫)通过TCP三次握手与服务器建立连接,若使用HTTPS则需完成TLS加密协商。

- 传输数据:服务器返回HTML、CSS、JavaScript等资源文件,完成页面渲染或数据抓取。

Googlebot(谷歌爬虫)采用分布式架构,全球部署数百万台服务器节点,通过智能调度系统实现高频抓取,同时遵循robots.txt规则控制访问权限。

技术细节与优化方向

速度优化机制

- 数据压缩:Google支持Brotli/Gzip压缩算法,减少传输体积,加快加载速度。

- 缓存策略:通过HTTP头部的Cache-Control和ETag字段实现资源缓存,降低重复请求频率。

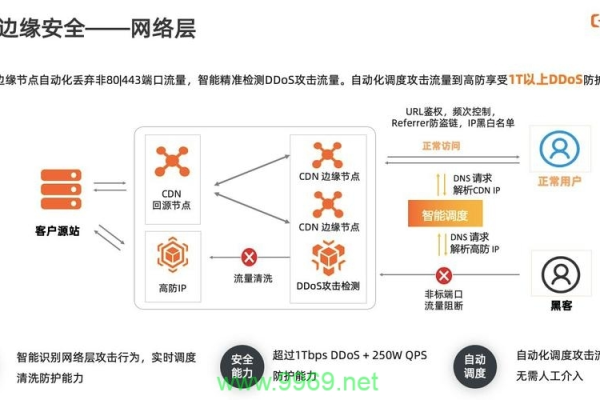

- CDN加速:利用边缘节点就近分发内容,缩短物理距离带来的延迟。

安全性要求

- HTTPS强制化:自2014年起,Google将HTTPS作为搜索排名信号,未加密网站可能被标记“不安全”。

- HSTS预加载:支持严格传输安全协议,防止中间人攻击。

爬虫行为特征

- 动态渲染处理:Googlebot已具备渲染JavaScript的能力,但对复杂SPA(单页应用)仍可能解析不全。

- 抓取预算控制:根据网站服务器性能、历史响应速度和内容更新频率,动态调整抓取频率。

对网站运营者的实践建议

技术合规性

- 确保服务器返回200状态码,避免因404/500错误导致页面被除索引。

- 使用JSON-LD或Microdata标记结构化数据,提升内容可读性。

性能提升策略

- 将TTFB(首字节时间)控制在300ms以内,优化数据库查询与代码逻辑。

- 启用HTTP/2或HTTP/3协议,利用多路复用降低延迟。

E-A-T原则落地

- 专业性(Expertise):通过作者署名、资质证明等内容强化权威背书。

- 权威性(Authoritativeness):获取高质量外部链接,尤其是.edu/.gov域名的推荐。

- 可信度(Trustworthiness):在网站公示隐私政策、联系方式,并定期更新安全证书。

常见问题排查

- 抓取失败:检查服务器日志中User-Agent为“Googlebot”的请求,确认防火墙未误拦截。 未收录**:通过Search Console提交Sitemap,检查robots.txt是否允许爬虫访问。

- 速度下降:使用PageSpeed Insights或Lighthouse工具诊断资源加载瓶颈。

引用说明

本文技术细节参考Google开发者文档、百度搜索资源平台官方指南及Mozilla MDN Web文档,数据截至2025年10月。