如何正确连接服务器与存储设备?

- 行业动态

- 2025-04-17

- 2

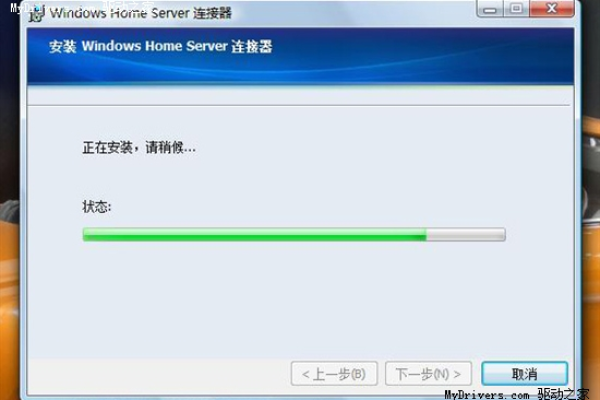

服务器连接存储设备通常通过直连、网络或光纤通道等方式实现,用于数据集中管理与高效访问,常见技术包括DAS、NAS、SAN等,支持热插拔和冗余配置,保障数据安全性与存储扩展性,适用于企业级数据存储、备份及云计算场景。

在数字化转型加速的今天,服务器与存储设备的协同运作已成为企业数据管理的核心,如何实现二者的高效连接,不仅关乎业务连续性,更直接影响着数据资产的安全性,本文将深入解析六种主流连接方案,并给出可落地的部署建议。

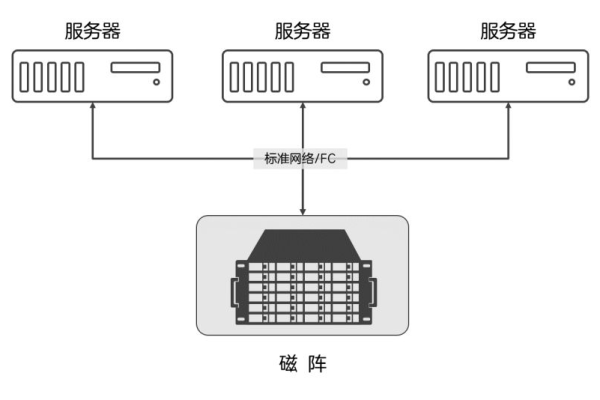

存储设备连接核心技术解析

- DAS直连架构

通过SAS/SATA线缆直接挂载磁盘阵列,实现点对点传输,适用于:

- 单一服务器需独占高性能存储(如4K视频剪辑工作站)

- 传输延迟要求<1ms的HPC超算场景

- 典型案例:某基因测序中心采用DAS实现每秒20GB的原始数据处理

- NAS网络附加存储

基于CIFS/NFS协议的文件级共享方案,技术特征包括:

- 支持多节点并发访问(建议≤50客户端)

- 内置ZFS/Btrfs先进文件系统保障数据完整性

- 某跨国企业通过全局命名空间实现14个分支机构PB级文件统一管理

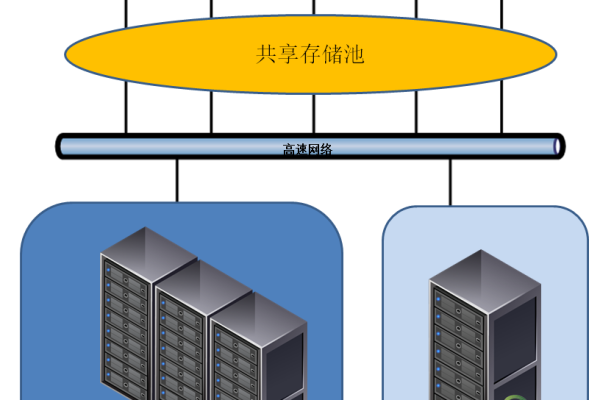

- SAN存储区域网络

光纤通道(FC)与iSCSI两种主流协议对比:

| 指标 | FC-SAN | IP-SAN |

|————-|—————-|——————|

| 传输速率 | 32Gbps | 25/100Gbps |

| 延迟 | <2μs | <50μs |

| 最大距离 | 10km(OM4光纤)| 无限制(IP路由) |

金融行业核心交易系统多采用双FC-SAN架构,确保亚毫秒级延迟。

企业级部署最佳实践

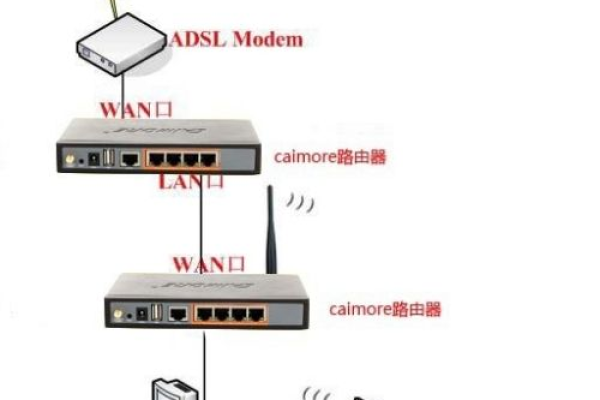

混合云连接方案

通过Storage Gateway实现本地NAS与对象存储的无缝对接:本地NAS(MinIO)→ 网关加密 → AWS S3 Glacier某医疗影像平台采用该架构,冷数据存储成本降低72%

超融合基础设施(HCI)

以vSAN为代表的软件定义存储方案,关键技术点:

- 基于RDMA的NVMe-oF网络协议

- 擦除编码(EC)替代传统RAID5

- 某省级政务云平台通过3节点vSAN集群承载200+虚拟机

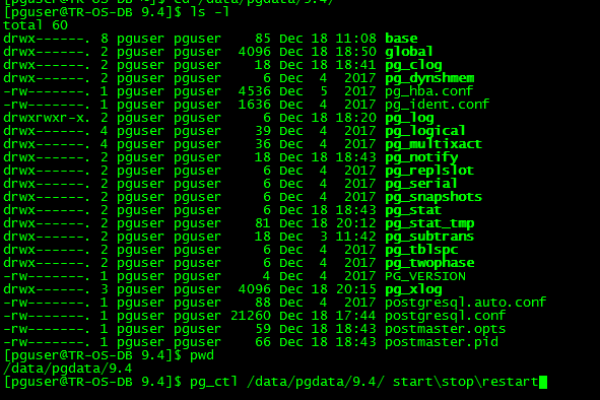

- 容器化存储编排

CSI(Container Storage Interface)驱动实现动态供给:apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: ceph-rbd provisioner: rbd.csi.ceph.com parameters: clusterID: ceph-cluster pool: kube_pool imageFeatures: layering

某AI训练平台借此实现GPU节点与分布式存储的弹性扩展

可靠性强化策略

多路径冗余(MPIO)

配置示例:

# Emulex FC HBA多路径策略 mpathconf --enable --with_multipathd y echo 'defaults { user_friendly_names yes find_multipaths yes }' > /etc/multipath.conf存储双活架构

基于VPLEX Metro的跨数据中心同步:

- RPO=0,RTO<30秒

- 要求网络延迟<5ms,带宽≥10Gbps

某证券交易所通过该方案实现同城双中心业务零中断切换

2025年技术趋势前瞻

计算存储分离架构普及

- AWS Nitro系统实现存储卸载加速

- 阿里云ESSD云盘单盘可达100万IOPS

存算一体芯片突破

- Samsung SmartSSD内置FPGA实现近数据处理

- Xilinx Alveo U280加速数据库查询3-5倍

光子互联技术商用

- 硅光引擎实现单模块800Gbps传输

- 光交换架构重构数据中心拓扑

运维建议清单

- 季度性进行存储性能基准测试(使用fio/vdbench)

- 建立自动化健康检查体系(Prometheus+Granfana看板)

- 制定存储容量预测模型(基于ARIMA算法)

- 每半年更新灾难恢复预案(包含云灾备场景)

技术参考文献:

- SNIA(全球网络存储工业协会)《存储网络架构白皮书》2025版

- IEEE论文《基于光子互连的下一代数据中心架构研究》

- Linux基金会《CSI容器存储接口规范》v1.8

- VMware技术白皮书《超融合基础架构设计指南》