计算机视觉如何成为增强现实突破的核心驱动力?

- 行业动态

- 2025-04-16

- 2

增强现实(AR) 正在悄然改变人类与数字世界的交互方式,无论是手机游戏中的虚拟角色,还是工业场景中的实时数据叠加,其背后的核心技术都离不开计算机视觉(CV),本文将从计算机视觉的底层逻辑出发,探讨AR如何实现虚实融合,并分析其技术挑战与未来趋势。

AR的核心:计算机视觉如何“看见”真实世界?

AR的本质是将虚拟信息精准叠加到真实场景中,整个过程依赖计算机视觉的三项关键技术:

场景理解与特征提取

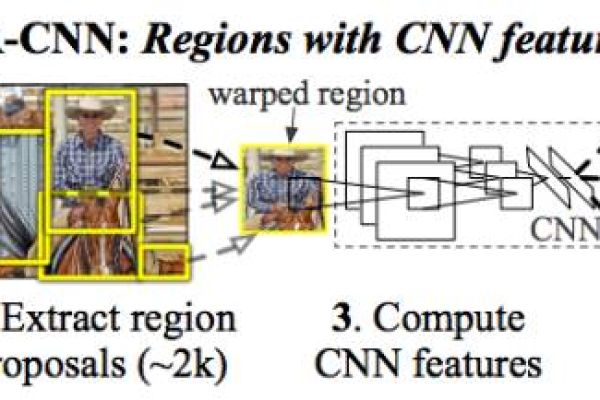

摄像头捕捉的原始图像需转化为机器可识别的信息,CV算法通过特征点检测(如SIFT、ORB)或深度学习模型(如CNN)提取场景中的关键点、边缘、纹理,ARCore利用特征点构建稀疏点云,作为跟踪注册的基准。姿态估计与空间定位

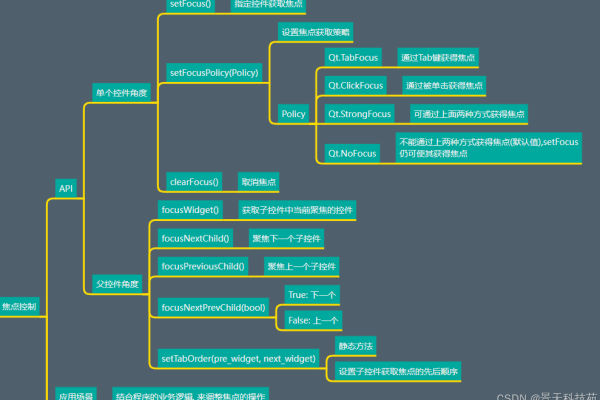

AR设备需要实时计算自身在三维空间中的位置(位置)和方向(旋转),这一过程称为6DoF(六自由度)姿态估计,传统方法依赖PnP算法(Perspective-n-Point),结合IMU传感器数据优化;而基于SLAM(同步定位与建图)的算法(如ORB-SLAM3)能动态构建环境地图,适用于未知场景。三维重建与虚实配准

虚拟对象必须与真实环境的光照、透视关系匹配,CV通过多视图几何或深度传感器(如ToF、结构光)重建场景的3D模型,苹果ARKit的“Scene Geometry”功能可生成实时网格,让虚拟物体与桌面、墙壁自然贴合。

AR落地的技术难点与突破

尽管AR应用已渗透到教育、医疗、工业等领域,但技术层面仍面临严峻挑战:

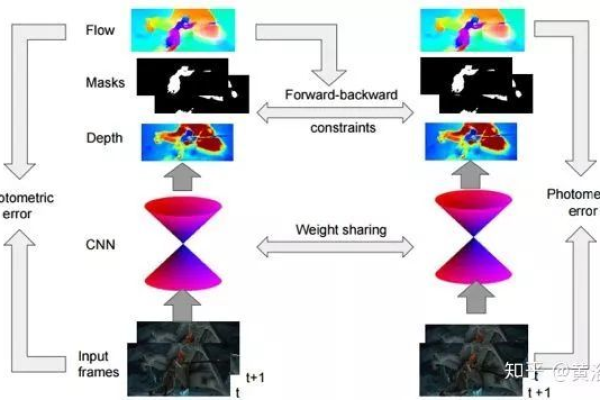

动态环境的鲁棒性

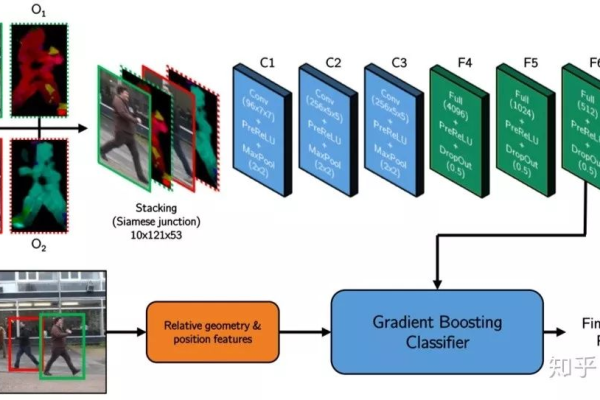

光照变化、运动模糊、遮挡等问题会导致特征跟踪失效,解决方案包括采用光流法追踪连续帧的运动,或使用语义分割(如Mask R-CNN)区分动态与静态物体。实时性与算力平衡

移动端设备算力有限,算法需在精度和效率间取舍,轻量化模型(如MobileNet)与边缘计算(如高通XR芯片)成为关键,微软HoloLens 2采用定制HPU(全息处理单元)加速CV任务。跨尺度一致性

远距离大场景与近距离细节需统一坐标系,结合视觉惯性里程计(VIO)与GPS、LiDAR等多模态数据是主流方向,自动驾驶AR导航中,高精地图与实时SLAM的融合即为此类典型应用。

未来趋势:当深度学习重塑AR

随着AI技术的演进,AR正从“规则驱动”转向“数据驱动”:

神经渲染(NeRF)

传统三维重建依赖几何模型,而NeRF通过神经网络直接从2D图像生成逼真的3D场景,谷歌的“Block-NeRF”已能重建城市级规模的环境,为AR提供高保真虚拟背景。语义增强现实

CV模型不仅能识别物体,还能理解场景语义,AR眼镜通过目标检测识别手术器械并叠加操作指南,或通过行为识别预警工业流水线异常。无标记AR的普及

早期AR依赖二维码或特定标记,而基于自然特征跟踪的技术(如WebXR)支持任意平面或物体作为锚点,大幅扩展应用场景。

AR与CV的共生进化

AR的每一次跃迁,都伴随着计算机视觉技术的突破——从特征点匹配到深度学习,从单一传感器到多模态融合,随着空间计算与具身智能的发展,AR或将彻底消除数字与物理的边界,而计算机视觉,正是这场变革的“眼睛”与“大脑”。

引用说明

本文部分技术细节参考自OpenCV官方文档、谷歌ARCore技术白皮书、《Computer Vision: Algorithms and Applications》(Richard Szeliski著)及CVPR 2025会议论文《NeRF in the Wild》。