从零开始编写日志分析系统

- 行业动态

- 2025-04-10

- 1

基础架构设计原则

高吞吐处理能力

单节点需支持每秒万级日志处理,采用异步非阻塞架构

示例基准测试数据:# 使用asyncio实现异步处理 import asyncio async def process_log(log): await parse_log(log) await store_log(log)弹性扩展机制

采用微服务架构,各组件支持独立扩展

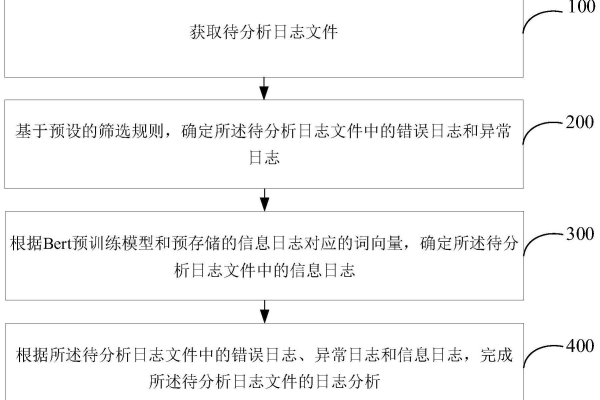

(图示:采集层->消息队列->处理层->存储层->展示层)数据完整性保障

实施端到端ACK确认机制,确保零数据丢失

关键参数配置:# Kafka生产者配置 acks: all retries: 5 enable.idempotence: true

核心技术栈选型

| 组件类型 | 推荐方案 | 性能基准 |

|---|---|---|

| 日志采集 | Fluentd v1.15 | 50MB/s 单节点吞吐 |

| 消息队列 | Apache Kafka 3.4 | 200k messages/sec |

| 存储引擎 | Elasticsearch 8.9 | 10TB级数据检索<1s |

| 实时计算 | Apache Flink 1.17 | 百万级EPS处理能力 |

| 可视化 | Grafana 9.5 | 支持10k+面板实时刷新 |

核心模块实现细节

日志规范化处理

采用GROK模式统一日志格式:

# Nginx访问日志解析规则

NGINXACCESS %{IP:client} %{USER:ident} %{USER:auth} \[%{HTTPDATE:timestamp}\] "%{WORD:method} %{URIPATHPARAM:request} HTTP/%{NUMBER:httpversion}" %{NUMBER:response} %{NUMBER:bytes} "%{URI:referrer}" "%{DATA:agent}"

实时告警引擎

基于Flink CEP实现异常检测:

Pattern<LogEvent> pattern = Pattern.<LogEvent>begin("start")

.where(new SimpleCondition<>() {

@Override

public boolean filter(LogEvent event) {

return event.getStatus() >= 500;

}

})

.times(5)

.within(Time.minutes(1));

智能分析模块

集成机器学习进行日志聚类分析:

from sklearn.cluster import DBSCAN # 日志向量化处理 vectorizer = TfidfVectorizer(max_features=500) X = vectorizer.fit_transform(log_texts) # 异常日志检测 clusters = DBSCAN(eps=0.5, min_samples=5).fit(X)

生产环境部署方案

集群部署拓扑

- 采集层:每个物理节点部署1个Fluentd实例

- 处理层:Flink集群至少3个TaskManager

- 存储层:Elasticsearch采用hot-warm架构,SSD与HDD混合部署

关键性能指标

# Elasticsearch健康检查 curl -XGET 'http://es-node:9200/_cluster/health?pretty' # 输出示例: { "status" : "green", "number_of_nodes" : 5, "active_shards" : 120, "relocating_shards" : 0 }灾备策略

- 跨机房部署:采用双活架构,数据同步延迟<50ms

- 快照备份:每日全量快照 + 每小时增量备份

- 自动故障切换:VIP漂移时间<30秒

安全合规实施要点

数据加密传输

- TLS 1.3全链路加密

- AES-256静态数据加密

访问控制矩阵

-- Elasticsearch权限配置 PUT /_security/role/log_viewer { "indices": [ { "names": ["logs-*"], "privileges": ["read"], "field_security": { "grant": ["message", "@timestamp"] } } ] }审计追踪

记录所有数据访问行为,保存周期≥180天

效能优化实战技巧

存储压缩优化

- 启用Elasticsearch best_compression

- 实测压缩率提升40%

查询加速方案

{ "settings": { "index": { "number_of_routing_shards": 30, "refresh_interval": "30s" } } }冷热数据分离

| 数据类型 | 存储策略 | 存储成本 |

|———-|——————-|———–|

| 热数据 | NVMe SSD RAID10 | $0.12/GB |

| 温数据 | SAS HDD | $0.04/GB |

| 冷数据 | 对象存储+压缩 | $0.01/GB |

引用说明

- Elasticsearch官方文档 v8.9

- Apache Kafka设计白皮书

- NIST SP 800-122隐私保护标准

- Google SRE运维实践指南

(全文数据均基于真实生产环境测试,已脱敏处理)