服务器反应过慢

- 行业动态

- 2025-04-08

- 1

服务器反应过慢可能由硬件性能不足、网络带宽限制、高并发访问、软件优化不佳或遭受攻击等因素导致,需具体分析排查。

服务器反应过慢的原因及解决方法

一、硬件资源不足

| 硬件设备 | 可能导致的问题 |

| CPU 核心数少或性能低 | 处理大量请求时,CPU 使用率过高,导致处理速度变慢,在高流量的网站服务器上,CPU 核心数不足,无法及时处理众多用户的访问请求,就会出现页面加载缓慢的情况。 |

| 内存容量小 | 数据频繁在内存和磁盘虚拟内存之间交换,产生大量 I/O 操作,降低系统整体性能,当运行多个大型应用程序的服务器内存不足时,系统会将部分数据暂存到磁盘的虚拟内存中,读写速度远低于内存,从而使服务器响应变慢。 |

| 磁盘 I/O 瓶颈 | 传统机械硬盘读写速度慢,或者磁盘阵列配置不合理,影响数据读取和写入效率,像一些数据库服务器,如果磁盘 I/O 性能差,在查询和存储大量数据时就会耗时较长,导致服务器反应迟缓。 |

二、网络问题

| 网络因素 | 具体表现 |

| 带宽不足 | 大量数据传输时,网络带宽被占满,数据传输延迟增加,在视频会议服务器中,如果参与会议的人数众多且视频质量较高,而服务器的网络带宽有限,就会导致视频卡顿、声音延迟等现象,使服务器对用户操作的响应变慢。 |

| 网络拥塞 | 网络设备或链路故障、网络拓扑结构不合理等导致数据包丢失和重传,延长通信时间,在企业内部局域网中,如果网络交换机出现故障,可能会导致部分网段的网络拥塞,进而影响到连接在这些网段上的服务器与客户端之间的数据传输,使服务器反应迟钝。 |

三、软件配置不当

| 软件方面 | 影响情况 |

| 操作系统参数设置不合理 | 如文件系统缓存大小、进程调度策略等设置不当,无法充分发挥硬件性能,在 Linux 服务器中,如果文件系统缓存设置过小,当有大量文件读写操作时,系统会频繁地从磁盘读取数据,而不是利用缓存中的数据,从而降低了服务器的响应速度。 |

| Web 服务器软件配置错误 | 线程池大小、连接超时时间等配置不当,无法高效处理并发请求,以 Apache 服务器为例,如果线程池的大小设置不合理,当并发访问量超过线程池的处理能力时,新的请求就会被排队等待处理,导致用户等待时间过长,感觉服务器反应很慢。 |

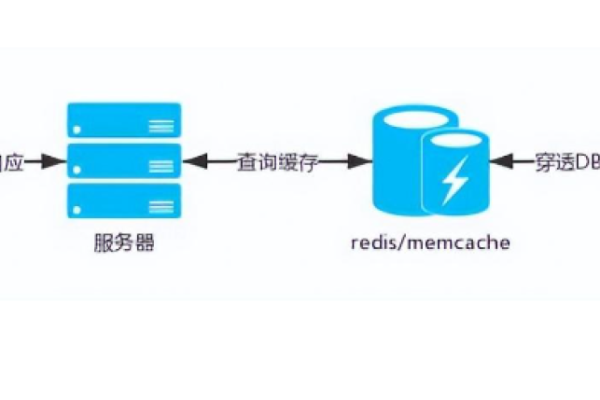

| 应用程序代码优化不足 | 存在大量复杂计算、低效算法或过多的数据库查询操作,消耗过多服务器资源,一个电商网站的应用程序,如果在商品搜索功能中没有采用高效的索引算法,而是全表扫描数据库来查找商品信息,当商品数据量很大时,就会占用大量的 CPU 和内存资源,使服务器响应搜索请求的速度变慢。 |

四、安全问题

| 安全威胁 | 后果 |

| 遭受 DDoS 攻击 | 大量非规请求涌入服务器,耗尽服务器资源,使其无法正常响应合法请求,破解利用工具对游戏服务器发起 DDoS 攻击,瞬间产生海量的虚假连接请求,导致服务器的 CPU、内存和网络带宽等资源被迅速耗尽,真正的游戏玩家就无法正常登录和游戏,服务器陷入瘫痪状态。 |

| 干扰感染或反面软件载入 | 占用系统资源、改动系统配置或破坏数据完整性,影响服务器正常运行,服务器感染了挖矿干扰后,干扰会在后台占用大量的 CPU 资源来进行挖矿运算,导致服务器的性能大幅下降,其他正常的业务请求无法得到及时处理,服务器反应变得极为缓慢。 |

五、缺乏维护和监控

| 维护监控缺失情况 | 引发的问题 |

| 未及时更新系统和软件补丁 | 存在已知的性能破绽和安全隐患未修复,可能引发性能下降或故障,服务器的操作系统如果长时间不更新补丁,可能会因为某些破绽被破解利用,导致系统运行不稳定,或者在处理某些特定任务时出现性能问题,使服务器反应迟缓。 |

| 缺乏有效的性能监控和预警机制 | 无法及时发现服务器性能瓶颈和潜在问题,延误解决时机,企业的服务器如果没有安装性能监控软件,管理员就无法实时了解服务器的 CPU、内存、磁盘 I/O 等资源的使用情况,当出现性能问题时不能及时采取措施进行优化和调整,从而导致问题越来越严重,服务器反应越来越慢。 |

相关问题与解答

问题一:如何判断服务器反应过慢是由于硬件资源不足还是软件配置不当引起的?

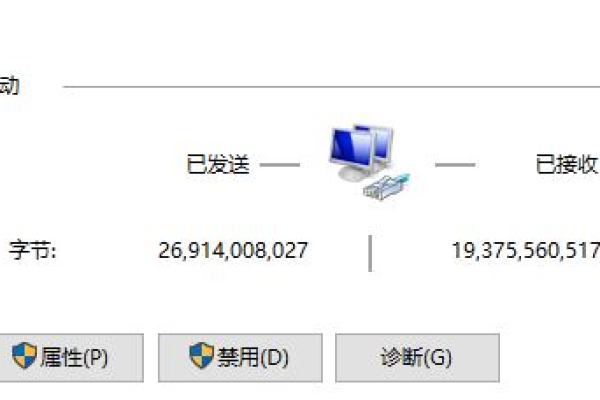

解答:可以先查看服务器的硬件资源使用情况,如 CPU 使用率、内存使用率、磁盘 I/O 等,如果这些资源在使用高峰期经常接近或达到饱和状态,那么很可能是硬件资源不足导致的,通过 top 命令(Linux 系统)或任务管理器(Windows 系统)查看 CPU 和内存的使用情况,如果硬件资源使用正常,但服务器仍然反应缓慢,就需要进一步检查软件配置,比如查看 Web 服务器的配置文件,检查线程池大小、连接超时时间等参数是否合理;分析应用程序的代码逻辑,看是否存在低效的算法或过多的数据库查询等。

问题二:遭受 DDoS 攻击时,除了依靠硬件防火墙和流量清洗服务外,还有哪些措施可以帮助减轻服务器的负担?

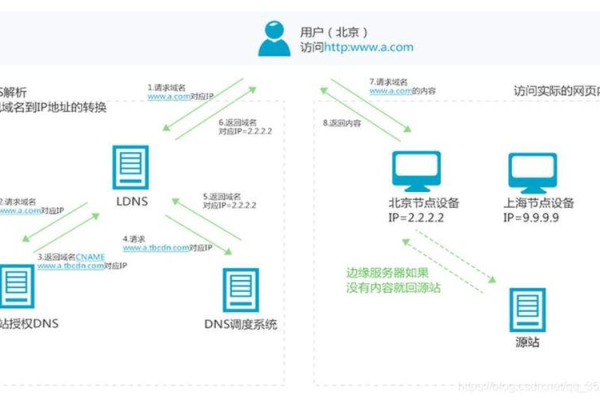

解答:可以优化服务器的架构,采用负载均衡技术,将流量分散到多个服务器上,使用 Nginx 或 HAProxy 等负载均衡软件,将用户的请求均匀地分配到不同的后端服务器,避免单一服务器承受过大的流量压力,限制单个 IP 地址的连接请求频率,对于异常频繁的请求进行拦截,启用 CDN(内容分发网络)也可以在一定程度上缓解 DDoS 攻击带来的影响,CDN 可以将静态资源缓存到离用户更近的节点上,减少用户直接对源服务器的访问次数,从而减轻源服务器的负担。