如何优化WordPress SEO插件Rank Math的General Settings以提高网站排名?

- 行业动态

- 2024-09-18

- 6

WordPress SEO插件Rank Math设置教程(二):General Settings设置

Rank Math是WordPress的一个强大的SEO插件,它提供了丰富的功能来优化你的网站,在这篇教程中,我们将介绍如何在Rank Math的“General Settings”部分进行设置。

1. 配置站点信息

你需要配置你的站点信息,这包括你的站点标题、描述和标志,这些信息将在搜索引擎结果页面上显示。

站点标题:输入你的网站名称或品牌名。

站点描述:输入一个简短的描述,说明你的网站是关于什么的。

站点标志:上传你的网站标志图片。

2. 设置社交媒体配置

Rank Math允许你添加社交媒体链接,这样当有人在社交媒体上分享你的网页时,相关的信息就会显示出来。

Facebook: 输入你的Facebook页面URL。

Twitter: 输入你的Twitter账户URL。

Pinterest、LinkedIn、MySpace、Google+等:同样,输入相应的社交媒体账户URL。

3. 设置Webmaster工具

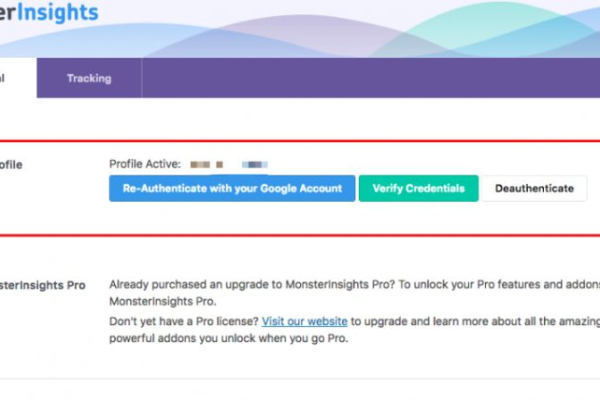

Webmaster工具可以帮助你监控你的网站在搜索引擎中的表现,Rank Math支持多种搜索引擎的Webmaster工具,如Google Search Console、Bing Webmaster Tools等。

Google验证:输入你的Google Search Console代码。

Bing验证:输入你的Bing Webmaster Tools代码。

4. 设置Local SEO

如果你的网站针对特定的地理位置,你可以在这里设置。

Address: 输入你的地址。

City: 输入你的城市。

State/Province: 输入你的州或省份。

Postal Code: 输入你的邮政编码。

Country: 选择你的国家。

5. 设置Schema Markup

Schema Markup是一种优化技术,可以帮助搜索引擎更好地理解你的网页内容,Rank Math允许你轻松地添加Schema Markup。

Person: 如果你是个人博客,可以选择这个选项。

Organization: 如果你是公司或组织,可以选择这个选项。

6. 设置Robots.txt

Robots.txt文件告诉搜索引擎哪些页面可以抓取,哪些页面不可以,Rank Math允许你轻松地编辑这个文件。

Disallow comments: 如果你不希望搜索引擎抓取评论,可以选择这个选项。

Disallow Yoast SEO database: 如果你以前使用过Yoast SEO插件,可以选择这个选项。

7. 设置404 Monitor

404 Monitor可以帮助你跟踪网站上的404错误,这对于保持网站的用户体验和SEO表现至关重要。

Email notifications: 你可以选择是否接收404错误的电子邮件通知。

相关问题与解答

Q1: 我是否需要为所有的社交媒体平台填写信息?

A1: 不必要,你只需要为你实际使用的社交媒体平台填写信息即可。

Q2: 我应该如何获取Google和Bing的Webmaster工具代码?

A2: 你需要先在Google Search Console和Bing Webmaster Tools上验证你的网站所有权,然后他们会给你提供相应的代码。