如何高效实现存储与服务器的无缝连接?

- 行业动态

- 2025-04-15

- 2

存储设备通过物理接口或网络协议与服务器连接,常见方式包括DAS(直连存储)、NAS(网络附加存储)和SAN(存储区域网络),DAS通过SCSI/SAS直接连接,NAS基于TCP/IP网络共享文件,SAN则采用光纤通道或iSCSI协议实现高速块级数据传输,满足不同场景的性能与扩展需求。

在企业级IT架构中,存储与服务器的连接方式直接影响数据访问效率、系统可靠性和业务连续性,本文将从技术原理、连接方案及选型建议等维度,解析存储与服务器的联接逻辑,以下内容基于行业通用技术标准和实践经验撰写,力求客观中立。

存储与服务器的联接基础

存储系统与服务器的交互本质是通过物理连接+数据传输协议实现的,需关注三个核心要素:

- 物理介质:如SATA、SAS、PCIe等接口的硬盘或固态盘;

- 网络架构:直连(DAS)、局域网(NAS)或专用存储网络(SAN);

- 通信协议:SCSI、iSCSI、NVMe over Fabrics等数据传输规则。

主流连接方案与技术对比

方案1:直连存储(DAS)

- 实现方式:通过SAS/SATA线缆直接连接服务器背板

- 典型场景:单台服务器本地存储扩展

- 优势:延迟低于1ms,成本低

- 局限:扩展性差,无法跨设备共享

方案2:网络附加存储(NAS)

- 实现方式:基于TCP/IP网络,通过NFS/SMB协议挂载

- 典型场景:文件共享、非结构化数据存储

- 优势:支持多平台访问,部署简单

- 局限:协议开销导致延迟较高(gt;5ms)

方案3:存储区域网络(SAN)

- 技术分支:

- FC SAN:光纤通道网络,延迟稳定在2-3ms

- IP SAN:iSCSI协议通过以太网传输,成本降低30%-50%

- NVMe-oF:新一代协议,可达到0.1ms级延迟

- 典型场景:数据库、虚拟化集群等高性能需求

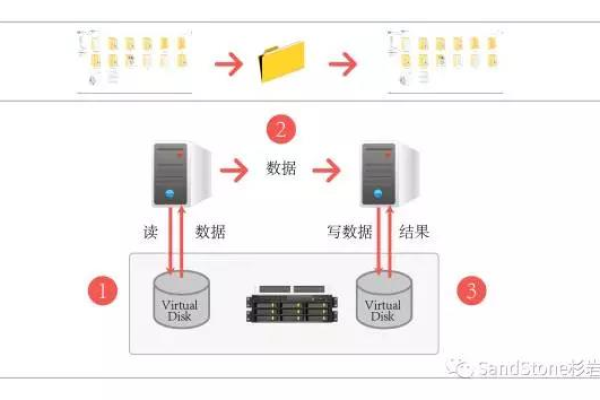

- 核心价值:实现存储资源池化,支持高可用架构

技术选型决策矩阵

| 维度 | DAS | NAS | FC SAN | NVMe-oF |

|---|---|---|---|---|

| 延迟 | ||||

| 扩展性 | ||||

| 成本 | ||||

| 管理复杂度 | 简单 | 中等 | 高 | 高 |

| 适用规模 | 单节点 | 中小集群 | 大型企业 | 超大规模 |

实施要点与最佳实践

性能优化:

- 机械硬盘阵列建议RAID 10配置

- NVMe SSD建议启用原子写特性

- 网络环境配置Jumbo Frame(9000字节MTU)

高可用设计:

- 双控制器存储设备冗余部署

- 多路径IO(MPIO)防止单点故障

- 定期执行存储QoS策略调优

安全防护:

- 光纤通道启用Port Security

- iSCSI环境强制CHAP认证

- 关键数据启用端到端校验

技术发展趋势

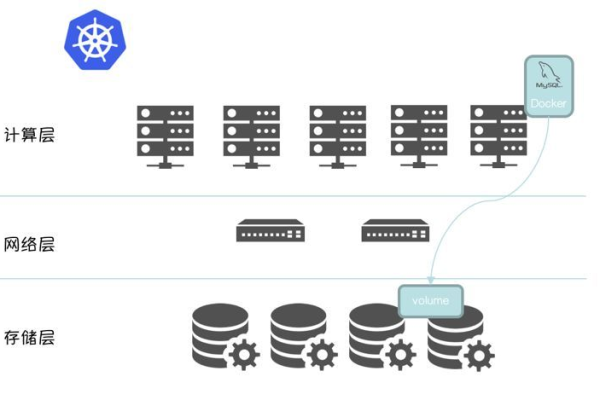

- 超融合架构:通过软件定义存储(SDS)实现计算存储深度融合

- SCM存储级内存:英特尔Optane等新技术推动纳秒级延迟

- 智能运维:AIops实现存储性能预测性维护

引用说明

- SNIA(全球网络存储工业协会)《存储网络架构白皮书》

- IEEE 802.3以太网技术标准文档

- 英特尔《持久内存技术指南》

- Gartner 2025年企业存储魔力象限报告

通过理解不同连接技术的特性,企业可根据业务需求选择最适合的存储架构,建议在关键系统实施前进行POC测试,确保技术方案与业务目标精准匹配。